顔認識モデル vs 人間!顔認識モデルのバイアスは人間よりも大きい?

3つの要点

✔️ 人間と顔認識モデルのバイアスを比較した初じめての論文

✔️ 顔認識モデルの性能は人間よりも高く、バイアスは同程度

✔️ 顔認識モデルと人間のいずれも男性・白人でより高性能、また人間は自分と類似した属性の人物に対してより高性能

Comparing Human and Machine Bias in Face Recognition

written by Samuel Dooley, Ryan Downing, George Wei, Nathan Shankar, Bradon Thymes, Gudrun Thorkelsdottir, Tiye Kurtz-Miott, Rachel Mattson, Olufemi Obiwumi, Valeriia Cherepanova, Micah Goldblum, John P Dickerson, Tom Goldstein

(Submitted on 15 Oct 2021 (v1), last revised 25 Oct 2021 (this version, v2))

Comments: Published on arxiv.

Subjects: Computer Vision and Pattern Recognition (cs.CV); Artificial Intelligence (cs.AI); Computers and Society (cs.CY); Machine Learning (cs.LG)

code:

本記事で使用している画像は論文中のもの、紹介スライドのもの、またはそれを参考に作成したものを使用しております。

概要

顔認識システムは、何十年もの間、注目されてきた研究分野です。そして、ここ数年、企業や政府は積極的に顔認識システムの導入を進めており、顔認識システムを目にする機会が増えてきていると思います。例えば、特定の人物が写っている画像を検索する(画像検索)ような気軽に導入できるものから、監視カメラ等で指名手配犯を検出するような物議を醸すものまで、様々な用途で利用されています。しかし、導入に際して、世界中でプライバシーや差別的な扱いが懸念・批判されています。

例えば、2020年、米ミネアポリスでアフリカ系アメリカ人ジョージ・フロイド氏が、警察官に首を押さえつけられて死亡した事件をきっかけに人種差別が話題となり、警察が捜査利用してた顔認識システムに対しても批判が集中しました。世界中で「顔認識技術は、人種差別・性差別を助長する」と批判が沸き起こり、大手ハイテク企業が相次いで提供の停止や開発の中止を発表しました。現在でも、公共性が高く、社会的に重要な用途、例えば、司法や警察機関における顔認識システムの使用には賛否両論あります。

これまでも顔認識システムのバイアスに関する研究は行われていました。しかし、顔認識システムのバイアスが「人間と比べて大きいのか」という観点での報告はなく、疑問が残ったままとなっていました。顔認識システムは、総合的な性能や処理速度の面で人間より優れていることはよく知られていますが、バイアスについては、いまだにわかっていませんでした。

仮に、顔認識システムのバイアスが、人間よりも遥かに大きいとなれば、顔認識システムの導入には慎重になる必要があります。例えば、監視カメラなどで利用されてしまえば、標的となる人物に大きな不利益が生じてしまいます。特定の人種や性別に対する誤認識から誤認逮捕につながる恐れが考えられます。しかし、人間と同程度であれば、理想的なシステムではないものの、人間よりも早く高精度に顔認識ができる技術ですから、実際に導入できる用途も十分に考えられます。また、顔認識システムのバイアスの特徴を理解することで、取り扱いに注意して、上手く付き合う方法を検討することもできます。

この論文では、今まで明らかになっていなかった人間と顔認識システムのバイアスを評価しています。この論文では、バイアスを公正に評価するために「InterRace」という新たなデータセットを作成し、人間と顔認識モデルに対して、Identification(1:N)とVerifivation(1:1)の2つのタスクの精度(Accuracy)とバイアスを評価しています。

「InterRace」データセット

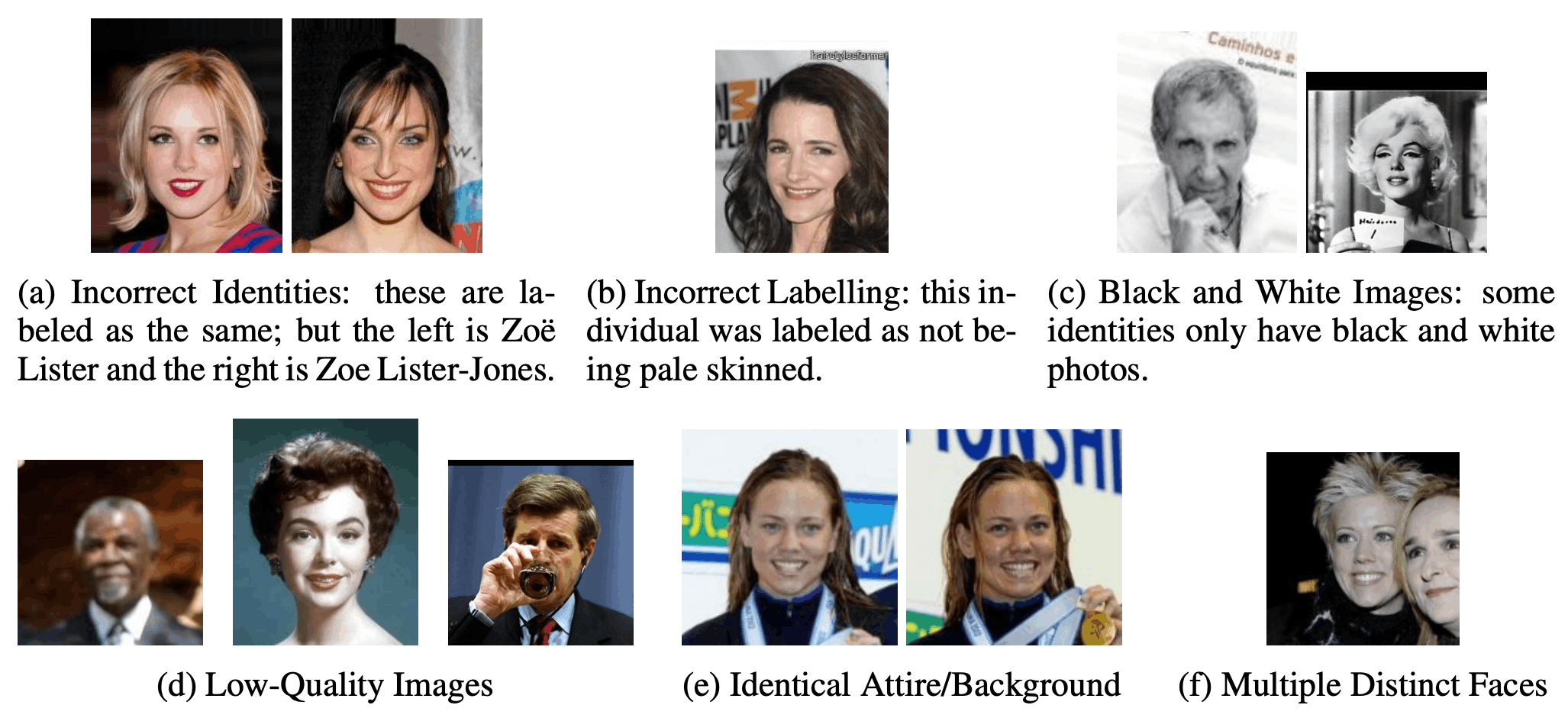

この論文では、正確にバイアスを評価するために、新たなデータセット「InterRace」を作成しています。既存のデータセットは大規模で利用しやすいですが、下図のように、別人に同一人物のラベルが付与されていたり、不鮮明な画像が含まれていたり、1つの画像に複数の人物が写っている場合があり、顔認識のモデル学習を妨げるデータが多く含まれていました。また、類似した画像がGalleryとTestの両方に含まれており、精度評価の際に、不当に精度が高くなってしまうようなデータも含まれていました。さらに、データセット内のデモグラに関するラベルの構成割合が大きく偏っており、バイアスを正確に検証することが難しい状態になっていました。この論文では、顔認識モデルの学習・評価でよく使われている大規模データセット「LFW」と「CelebA」を利用して、手作業でデータを修正・選別して、新たなデータセット「InterRace」を作成しています。

各画像には、生年月日・出身国・性別・肌色の4つがラベル付けされています。生年月日・出身国・性別は、Wikipediaや雑誌やインタビュー等のパブリックコメントを参考にしてラベルをつけており、複数人でダブルチェックを行っています。肌色は、Fitzpatrick Scaleと呼ばれる基準で肌の明るさで6つに分類しています。

最終的に、合計7,447枚の画像になり、2,545人のIDを含むデータセットを作成しています。構成は、明るい肌色(Fitzpatrick:I-III)が1,744人、暗い肌色(Fitzpatrick:IV-VI)が801人、また、男性は1,660人、女性は885人で構成されています。性能評価では、このデータセットから属性のバランスを調整したサブグループを作成しています。

実験

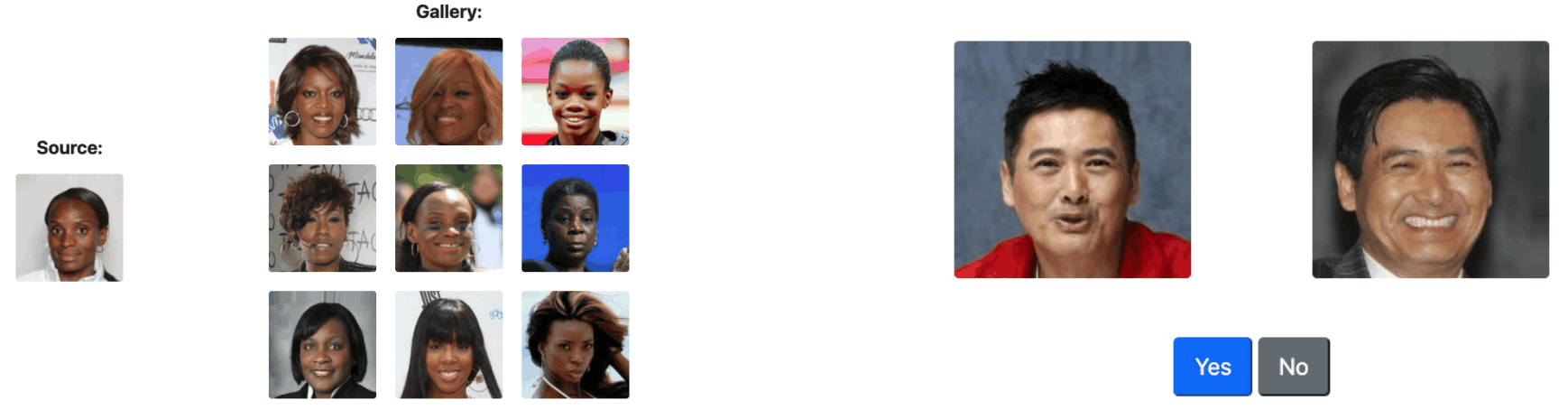

顔認識と人間の認識性能とバイアスと比較評価するために、Identification(1:N)とVerification(1:1)の実験をしています。Verificationでは、1枚のSource画像に対して1枚の同一人物の画像と8枚の性別と肌色が同じ人物の画像、計9枚を表示して、1枚の同一人物の画像を選ぶ性能を評価しています。Verification(1:1)では、1枚のSource画像に対して、1枚の同一人物の画像と1枚の性別と肌色が同じ人物の画像が表示され、表示された2枚の画像が同一人物かどうかを評価しています。

また質問を作成では、IdentificationとVerificationのタスクごとに、性別(2通り)と肌色(6通り)の12通りに対して、78人の人物を選定し、タスクごとに936問を用意しています。さらに、ここから、顔周辺のコンテキスト(背景や服など)で人物を特定できてしまうが画像を削除し、最終的にIdentificationに対して901問、Verificationに対して905問の質問を用意しています。

人間に対する調査は、クラウドソーシングを利用しており、各ユーザーにはIdentificatioを36問とVerificationを72問を約10分程度で回答してもらっています。質問はあらかじめ用意されたIdentificationの901問、Verificationの905問からランダムに選定され、属性情報に偏りがないように各属性情報(12通り)ごとに、Identificationが3問、Verificationが6問、出題されています。

各タスクにおいて、最初5問の直後、最後5問の直前に、注意力をチェックする質問をしています。Identificationでは、SourceとGalleryが同じ画像の質問、Verificationでは明らかに異なる画像ペア(「明るい肌色の女性」と「暗い肌色の男性」、明らかに同一の画像ペア(同一の画像)の質問を入れています。この質問に正しく回答できなかった回答者は、質問に真剣に取り組んでいないと判断して分析対象外としています。また、注意力をチェックする質問には正しく回答できたものの、調査時間が4分以内と極端に短い回答者も質問に真剣に取り組んでいないと判断して分析対象外としています。さらに、回答者が質問の形式に順応するために時間がかかる可能性があるため、各回答者が回答した各タスクの最初の3問も分析から除外しています。回答者は18歳以上で米国居住者で545人です。

顔認識モデルに対する調査では、AcademicモデルとCommercialモデル(API)を利用しています。また、顔認識モデルは人間とは異なり、疲労による集中力の低下などがないため、Identificationの901問、Verificationの905問の全てに回答しています。

Academicモデルでは、ResNet-18、ResNet-50、MobileFaceNet、NN(CosFace)、NN(ArcFace)をCelebA(9,277枚)で学習させています。なお、検証で使用するInterRaceのIDとは重複していません。Commercialモデル(API)では、AWS Rekognition、Microsoft Azure、Megvii Face++を利用していますが、AWS RekognitionとMicrosoft Azureは、Identification(1:N)とVerification(1:1)を評価し、Megvii Face++はVerification(1:1)のみを評価しています。

実験結果

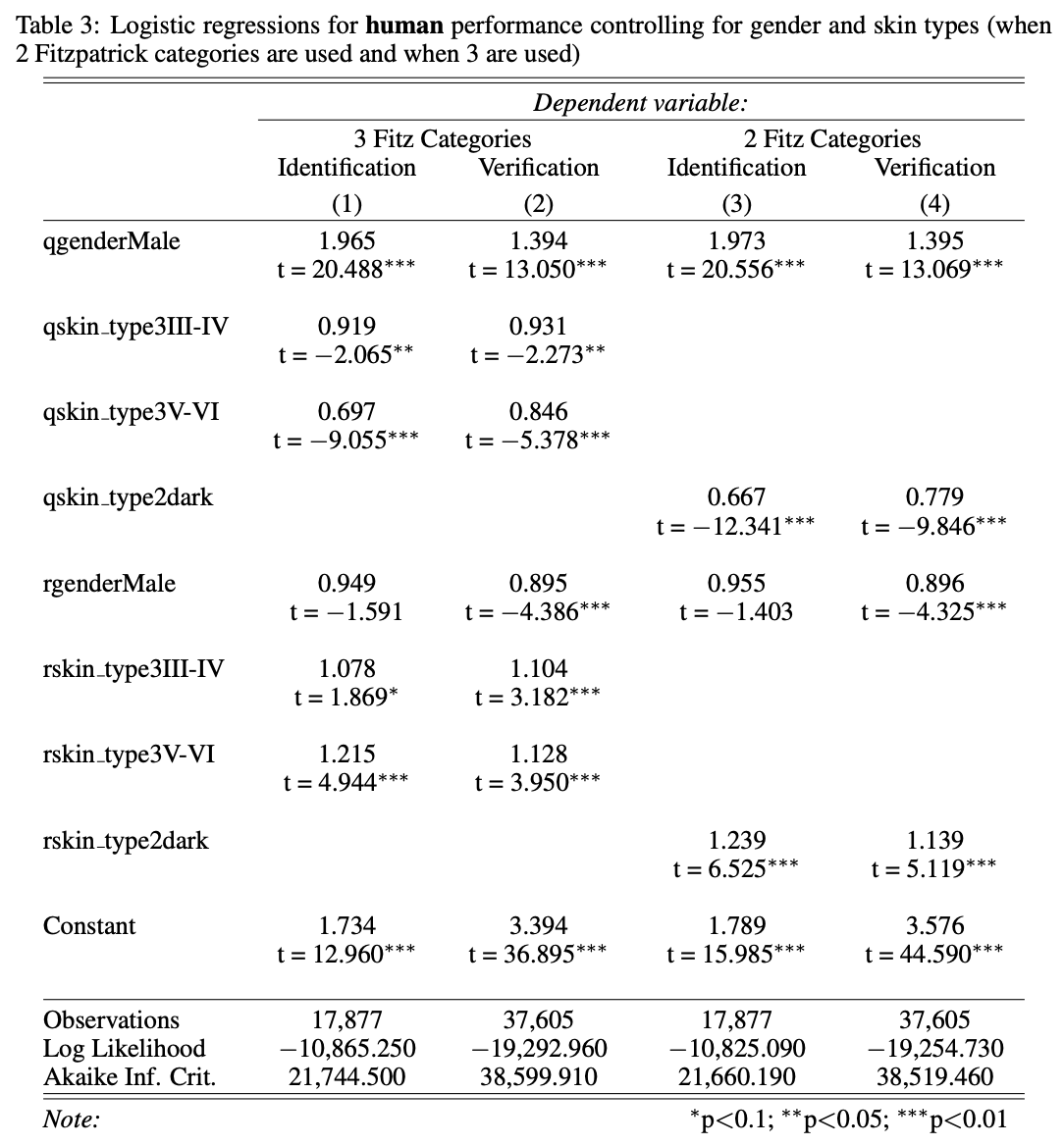

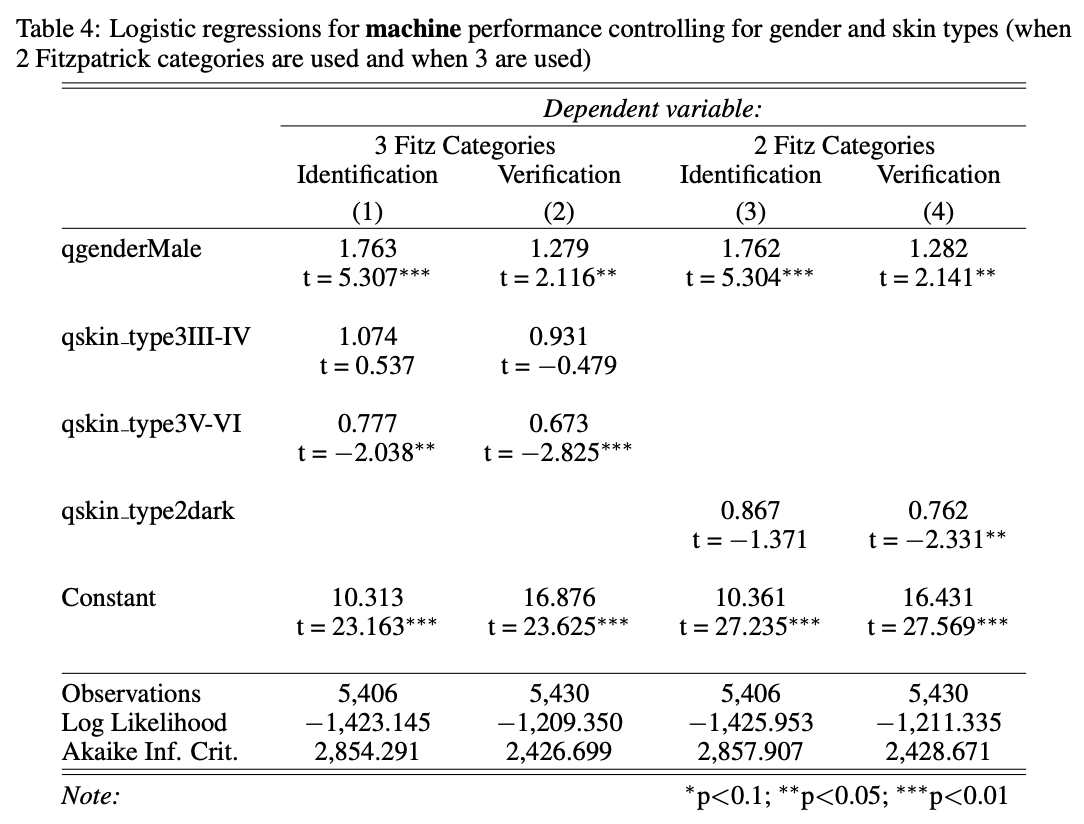

評価の結果、以下の2つの表の通りです。1つ目は人間の性能評価に対するロジスティック回帰の結果です。回答者の属性情報を制限している場合でも被験者の性別と肌のタイプに対してバイアスがあることを表しています(ロジスティック回帰)。2つ目は顔認識モデルの性能評価に対するロジスティック回帰の結果です。回答者の属性情報を制限していない場合における被験者の性別と肌のタイプに対するバイアスを表しています(ロジスティック回帰)。質問の対象者の属性情報はq(qgenderおよびqskinタイプ)で表され、回答者の属性情報はr(rgenderおよびrskinタイプ)で表されています。

以上から評価の結果、以下のことがわかっています。

- 人間・顔認識モデルともに、男性の方が結果がよくなる

- 人間・顔認識モデルともに、白人の方が結果が良くなる。

- 人間は、自分に似ているデモグラ属性の人に対して、性能が良くなる。

- Commercialモデル(API)は、顔認識精度が非常に高く、人種や性別による大きな性能差はない。

全体として、顔認識モデルは人間よりも精度(Accuracy)が高く、t検定・ロジスティック回帰の結果、人間と同程度の統計的優位なバイアスを持つことも分かっています。

しかし、この論文で注意すべき点は、回答者があくまでクラウドソーシングで集めた人たちである点です。顔認識の専門家ではないため、必ずしも人間よりも顔認識モデルが優れている、あるいは、人間と同程度と結論づけることはできません。あくまで、米国の非専門家/一般的な人たちの結果であるという点は注意が必要です。また、顔認識モデルについても、あくまで、この論文の著者が選んだモデルに限定されているため、他の顔認識モデルで同様の結果になるかは分かりません。これらの点は注意が必要です。

とはいえ、非専門家/一般的な人と比べると、顔認識モデルは性能がよく、バイアスも同程度であるため、導入メリットが大きいといえます。司法、警察による利用では、さらに研究が必要になるものの、顔認識モデルがもたらすメリットとデメリットを理解するために、十分役立つ、結果といえます。

この記事に関するカテゴリー