深層学習からデータを守ることはできるか?

3つの要点

✔️ 深層学習モデルが学習に利用できない$unlearnable$データを作成する手法の提案

✔️ 誤差を最小化するノイズにより、個人データが深層学習モデルに無断利用・悪用されることを防ぐ

✔️ 様々な条件において、$unlearnable$データの有効性を実証

Unlearnable Examples: Making Personal Data Unexploitable

written by Hanxun Huang, Xingjun Ma, Sarah Monazam Erfani, James Bailey, Yisen Wang

(Submitted on 13 Jan 2021)

Comments: Accepted to ICLR2021 Spotlight

Subjects: Machine Learning (cs.LG); Cryptography and Security (cs.CR); Computer Vision and Pattern Recognition (cs.CV); Machine Learning (stat.ML)

はじめに

ディープラーニングの成功は、インターネット上から集められた大規模なデータセットに支えられています。しかしながら、ネット上のデータが同意のもとに収集される保証も、正当な目的のために利用される保証もありません。

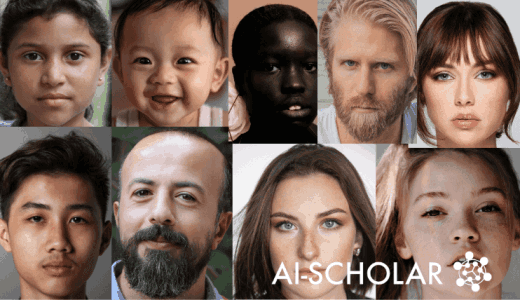

例えば、SNS等に投稿した自撮り写真が顔認証システムの作成に利用されたり、顔写真からその人のプロフィールを特定するシステムの作成等に利用されたりするかもしれません。このように、ネット上に投稿した個人データが本人の知らないうちに利用され、違法な目的のために悪用される可能性があります。

本記事で紹介する論文では、こうした問題に対処するため、ディープラーニングが「学習できない」($unlearnable$)データを作成する手法を提案しています。これは、画像に(人間には認識できない程度の)ノイズを加えることにより、それを学習に利用したディープラーニングモデルが、有効な性能を発揮できないようにする研究となります。

Adversarial Attackと類似する点もありますが、本手法の場合、損失(誤差)を最小化するようなノイズを加えることで、モデルに「学習できることはなにもない」と思い込ませることが特徴的です。

手法

問題設定と目標

はじめに、問題設定について説明します。

想定されるタスクは、深層ニューラルネットワーク(DNN)による画像分類タスクとします。

このとき、$K$クラス分類タスクについて、クリーンな($unlearnable$データを含まない)訓練データを$D_c$、テストデータを$D_t$、$D_c$上で学習されたDNNを$f_\theta$とします。(例えば、MNISTのtrainセットは$D_c$に、testセットは$D_t$に、$D_c$を用いて学習された何らかのモデルは$f_\theta$として表記されます。)

ここで、クリーンな訓練データ$D_c$を、$unlearnable$データ$D_u$に変換します($D_c$内の一部の画像にノイズを加えるなどの形で)。このとき、$D_u$を用いて訓練されたDNNが、テストデータ$D_t$上で性能が悪化するような$D_u$を生成することが目標となります。

より詳細には、クリーンな訓練データ$D_c$内に$n$個の例があるとすると、$D_c=\{(x_i,y_i)\}^n_{i=1}$と表すことができます($x \in X \subset R^d$は入力、$y \in Y=\{1,...,K\}$はラベル、$K$はクラスの総数)。

また、$unlearnable$データ$D_u$は、$D_u=\{(x^{\prime}_i,y_i)\}^n_{i=1}$と表されます。ここで、$x^{\prime}=x+\delta$であり、$x \in D_c$で、$\delta \in \Delta \subset R^d$は、目に見えない(人間に認識できない程度の大きさの)ノイズとなります。

このとき、$||\delta||_p \leq \epsilon$です($||・||_p$は$L_p$ノルム)。

また、画像分類タスクにおけるDNNモデルは、入力空間からラベル空間への写像$f: X→Y$を$D_c$上で学習します。このときの最終的な目標は、以下の式で表すことができます。

$arg min_\theta E_{(x^{\prime},y) \sim D_u} L(f(x^{\prime}),y)$

$L$はクロスエントロピー損失などの、一般的に用いられている分類損失となります。導入で述べた通り、誤差を最小化するようなノイズを生成することが目標となっています(arg minである点に注意)。

続きを読むには

(8895文字画像20枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー