大規模言語モデルPaLMを応用!Googleが開発する、医師の診断を支援する汎用AI「Med-PaLM M」とは?

3つの要点

✔️ 医療画像、遺伝子情報など医療の様々なデータを含む新しいベンチマーク「MultiMedBench」を紹介。

✔️ 1つのモデルで複数のタスクを処理できる世界初の汎用医療AIモデル「Med-PaLM M」を紹介。

✔️ 一部のタスクでは、臨床で受け入れ可能な水準に達していることを示した。

Towards Generalist Biomedical AI

written by Tao Tu, Shekoofeh Azizi, Danny Driess, Mike Schaekermann, Mohamed Amin, Pi-Chuan Chang, Andrew Carroll, Chuck Lau, Ryutaro Tanno, Ira Ktena, Basil Mustafa, Aakanksha Chowdhery, Yun Liu, Simon Kornblith, David Fleet, Philip Mansfield, Sushant Prakash, Renee Wong, Sunny Virmani, Christopher Semturs, S Sara Mahdavi, Bradley Green, Ewa Dominowska, Blaise Aguera y Arcas, Joelle Barral, Dale Webster, Greg S. Corrado, Yossi Matias, Karan Singhal, Pete Florence, Alan Karthikesalingam, Vivek Natarajan

(Submitted on 26 Jul 2023)

Subjects: Computation and Language (cs.CL); Computer Vision and Pattern Recognition (cs.CV)

code:

本記事で使用している画像は論文中のもの、紹介スライドのもの、またはそれを参考に作成したものを使用しております。

概要

医療分野は多岐にわたる情報を取り扱うマルチモーダルな性質を持ち、テキスト、画像、ゲノム情報など、多様なデータ形式を柔軟に処理できる汎用性の高いもAIモデルが求められています。

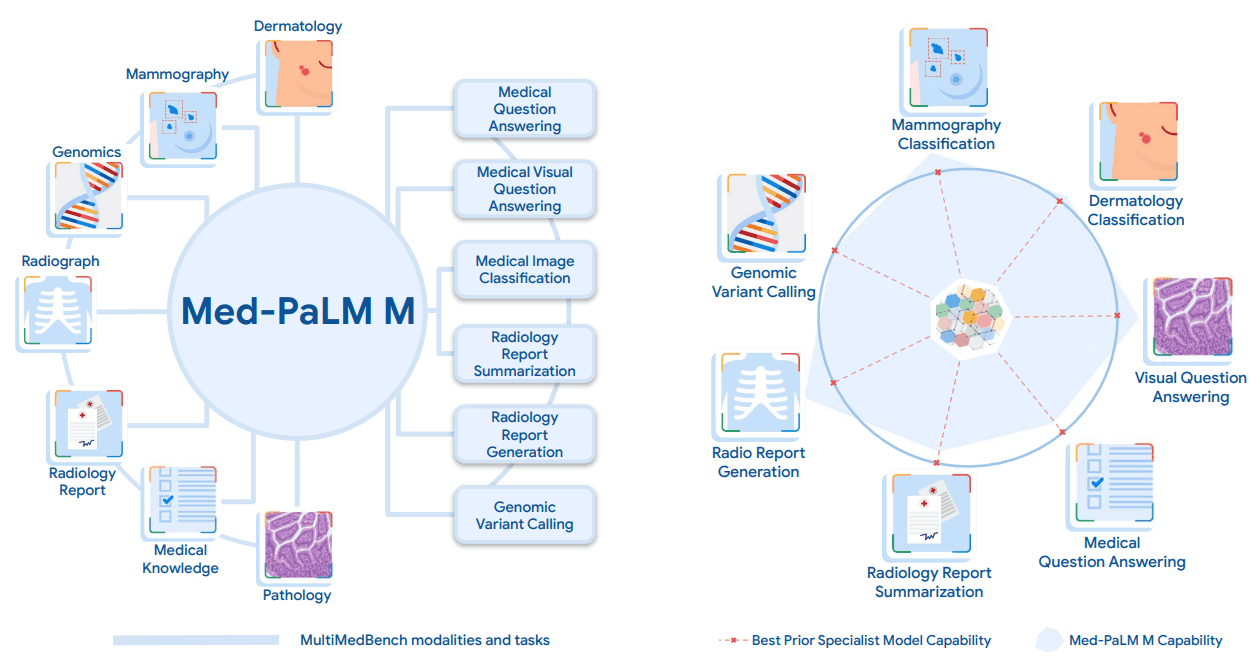

今回紹介する論文では、言語や医療画像、遺伝子情報など複数の種類の医療データを解釈し、1つのモデルで多くの異なるタスクをこなせる汎用性の高いAIモデル「Med-PaLM Multimodal」(以下、Med-PaLM M)を開発しています。これは1つのAIモデルで多様な医療データを扱うことができる最初の例であり、特定のタスクに特化したモデルよりも優れた成果を示しています。タスク特有の調整を行わずに、このような成果を達成しています。

また、Med-PaLM Mを開発するために、MultiMedBenchというベンチマークを構築しています。MultiMedBenchは、医療関連のQ&A、乳がん検査や皮膚病理の画像解析、放射線診断のレポート作成や要約、ゲノムの変異検出など、14の多彩なタスクを含んでいます。

Med-PaLM Mは、MultiMedBenchの全タスクにおいて、専門家のモデルを大きく上回ることが多い最先端のパフォーマンスを達成しています。また、MultiMedBenchは、AIが現実世界の複雑な医療データをどれだけ正確に理解し、適切に処理できるかを評価するためのベンチマークであり、Med-PaLM Mのような汎用性の高いAIシステムの性能を構築・評価するための有用なツールを提供しています。

「MultiMedBench」とは

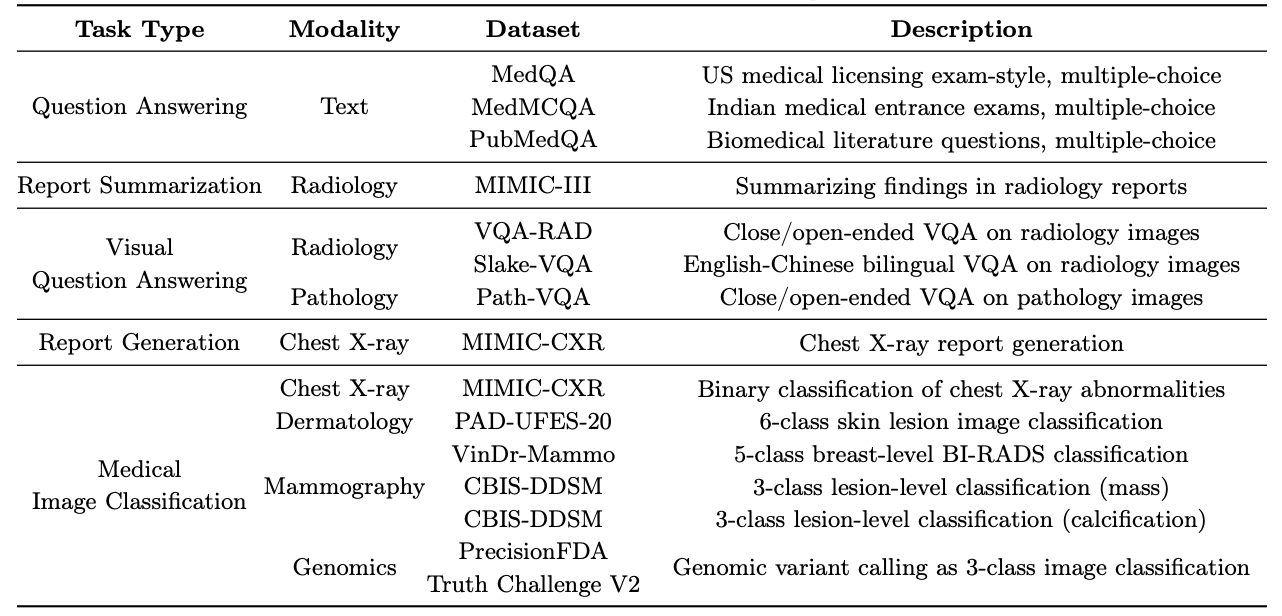

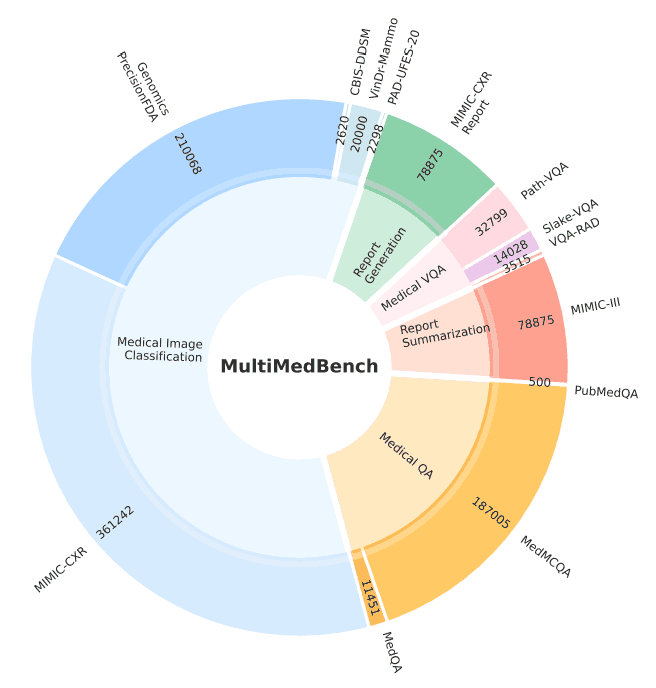

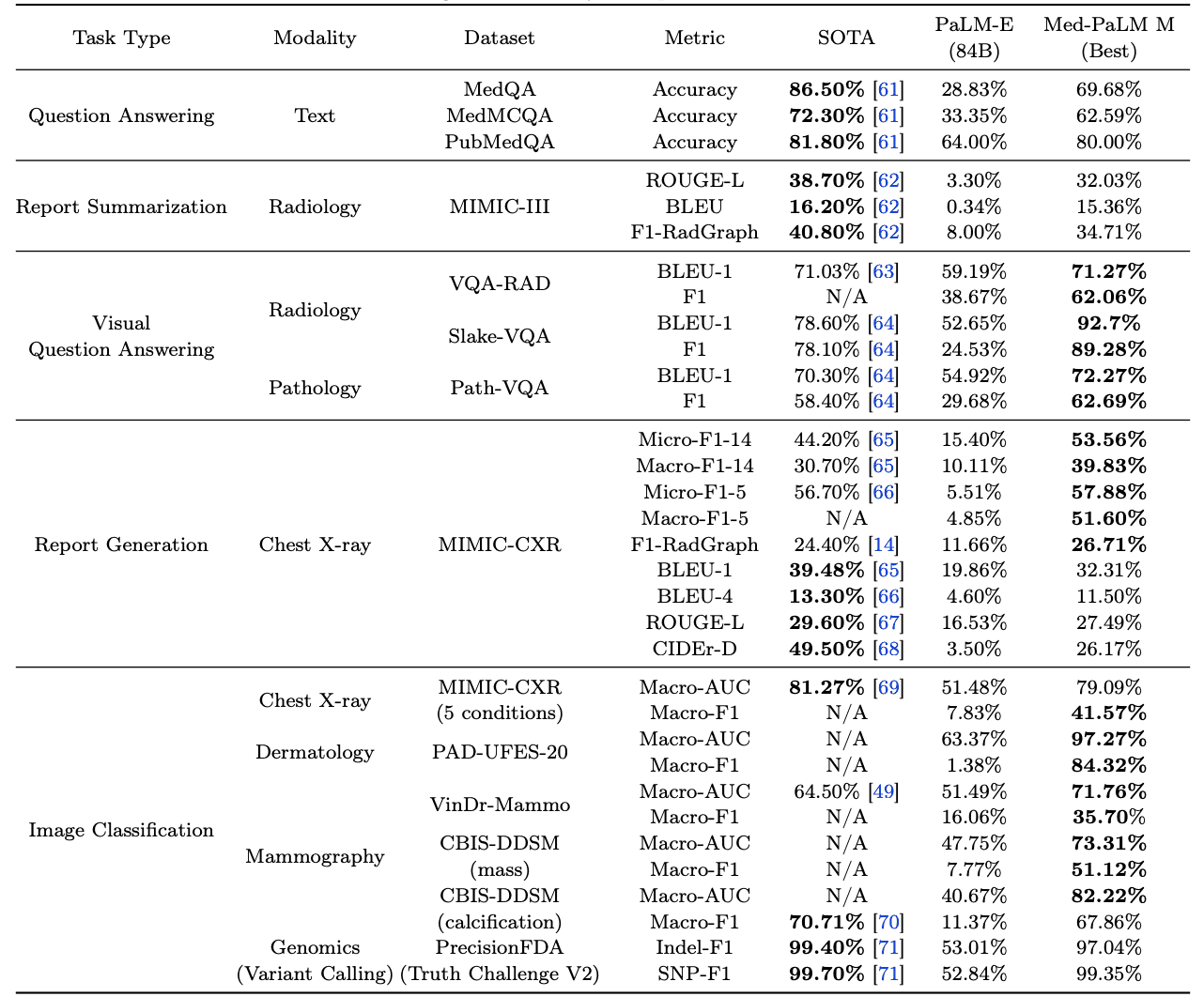

「MultiMedBench」は、Med-PaLM Mを開発・評価するために構築されたベンチマークであり、12種類のデータセットと14種類のタスクが含まれています。下表・下図は、データセットとタスクの概要です。ベンチマークには合計100万以上のサンプルが含まれています。

「Med-PaLM M」とは

Med-PaLM Mは、既存モデルであるPaLM-Eを医学分野に調整したモデルであり、PaLM・ViTのアーキテクチャやモデルパラメータをベースとして構築されたモデルです。

PaLMは、大規模言語モデルであり、インターネットのウェブページやWikipedia、ソースコード、SNSの投稿、ニュース、本などの大量のデータ(7800億トークン)で学習されており、いくつかのサイズ(80億、620億、5400億のパラメータ)があります。複雑な推論タスクで人間の平均的なパフォーマンスを超える性能を示しています。また、ViTは、Vision Transformerという画像認識モデルです。この論文では、40億と220億のパラメータを持つ2つのViTが使用されています。これらは約40億枚の画像を使って学習されいます。

PaLM-Eは、このPaLMとViTを組み合わせ、テキスト、画像やセンサーからのデータも理解できるマルチモーダルな言語モデルとして構築されたものであり、このモデルがMed-PaLM Mのベースになっています。この論文では、モデルサイズが異なるPaLMとViTモデルを組み合わせた3つのモデル(12B、84B、562B)を利用しています。

Med-PaLM Mは、このPaLM-EをMultiMedBenchでファインチューニングして構築されています。Med-PaLM Mもモデルサイズが異なる3つのモデル(12B、84B、562B)が構築されています。Med-PaLM Mは、医療分野に特化しており、医療関連の質問応答、放射線報告書の生成、画像分類、遺伝子変異の同定といったタスクを処理することができます。

性能評価

この論文では、Med-PaLM Mを2つのベースラインと比較しています。一つは、MultiMedBenchに含まれている各タスクにおいて、SOTAを達成している各タスクに特化したモデル、もう一つは、医療分野にファインチューニングしていないPaLM-E(84B)です。なお、PaLM-Eは計算リソースの制約のため、562Bではなく、84Bのモデルサイズを利用しています。

結果は下表のようになっています。表(太字)からわかるように、Med-PaLM Mは、MultiMedBenchに含まれている多くのタスクで既存のSOTAを上回っています。タスクに特化したファインチューニングをすることなく、同じモデル重みを利用して、複数のタスクでSOTAを達成しています。

また、医療分野にファインチューニングしていないPaLM-E(84B)と比較した場合、Med-PaLM Mは14種類の全てのタスクでパフォーマンスが向上していることがわかります。ほとんどのタスクで大幅に向上ししています。Med-PaLM Mが汎用性の高いAIモデルとして有用であることがわかります。

さらに、この論文では、学習していない新しい医療分野のタスクや概念への適用性(ゼロショットに対する性能)を検証しています。

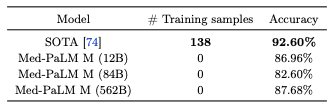

Montgomery County (MC) というデータセットを使用して、胸部X線画像からの結核を検出するタスクでゼロショットに対する性能を評価した結果は、下表の通りです。SOTAのモデルと競争力のある性能が得られています。

さらに、Med-PaLM Mは胸部X線画像を分析して、そこに結核などの異常があるかどうかを報告する能力もあります。そこで、放射線科医が人工知能が生成した報告書に含まれる見落としや誤りをチェックしています。Med-PaLM Mの臨床応用をさらに理解するために、Med-PaLM Mによって生成された胸部X線報告書(および人間の基準値)に対する放射線科医の評価を実施しています。

モデルサイズの異なる3つのMed-PaLM M(12B、84B、562B)が生成した報告書に含まれる見落としや誤りの数を計測しました結果、見落としに関しては、12Bと84Bモデルが平均して最も少ない見落としをし、次いで562Bモデルが少し多い見落としをすることがわかりました。また、誤りに関しては、84Bモデルが最も少なく、12Bが少し多く、562Bが最も多い誤りをすることがわかりました。これらの誤り率は、人間の放射線科医が過去の研究で示した誤り率と比較して似ており、このAIシステムの誤り率が、人間の専門家と同じくらいのレベルである可能性があるというを示しています。

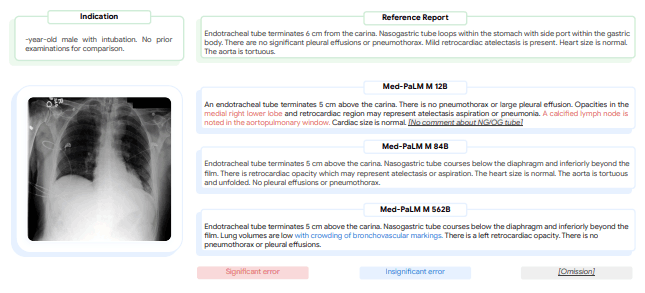

最後に、下図では、Med-PaLM Mが異なるサイズのモデルで生成した胸部X線の報告書の具体例を示しています。

この例では、放射線科医は、12Bのモデルによって作成された報告書には重要な誤りと見落としがあると評価し、84Bのモデルによって報告書には誤りや見落としがないと評価し、562Bモデルによって報告書は重要でない誤りが1つあるものの、見落としはないと評価しています。

まとめ

この論文では、医療分野で有用な汎用モデル「Med-PaLM M」と、その開発・評価に用いたベンチマーク「MultiMedBench」が紹介されています。1つのモデルで、多くのタスクでSOTAもしくはSOTAと同程度の性能を示しています。将来的には、このような汎用性の高いAIが専門性の高いAIと協力し、実際の臨床医や研究者と一緒になって医学の大きな課題に取り組むことが期待されます。

多様な医療データを統合し、新しい状況に迅速に対応できる汎用性の高いAIは、より良いヘルスケアシステムの構築に不可欠です。Med-PaLM Mは、このようなAIを作るための重要なステップであり、実用化に向けたさらなる開発と検証が期待されます。

この記事に関するカテゴリー