競馬からヒントを得た損失関数で学習する DeepGamblers が登場

3つの要点

✔️ 分類問題において予測に自信がないときに「棄権」できるモデルは実用上重要

✔️ ポートフォリオ理論で競馬における doubling rate を最大化することを考え、それとの類推から「棄権」を含む損失関数を提案

✔️ 予測クラスを一つ増やして損失関数を差し替えるだけでどのモデルにも適用でき、先行研究を上回る性能を発揮

Deep Gamblers: Learning to Abstain with Portfolio Theory

written by Liu Ziyin, Zhikang Wang, Paul Pu Liang, Ruslan Salakhutdinov, Louis-Philippe Morency, Masahito Ueda

(Submitted on 29 Jun 2019 (v1), last revised 1 Oct 2019 (this version, v2))

Comments: Published by NeurIPS 2019.

Subjects: Machine Learning (cs.LG); Machine Learning (stat.ML)

はじめに

ディープラーニングは CS 分野に限らず、物理、生物、化学、ヘルスケア、など様々な分野で活躍していますが、応用範囲が広がると予測の性能を高めることとは別の様々な要求が湧いてきます。

そういった要求の中でも重要なものの一つとして、予測の信頼性もしくは不確実性を取り扱えるようにするというものがあります。

例えば、実験データの中からモデルが発見したと思われる希少なシグナルが信頼に足るものなのかを測りたかったり、医療診断にモデルを使うときに誤診をしないように信頼できる予測だけを使いたかったり、という用途が考えられます。

このような用途においては、予測の信頼度に応じて予測結果を採用したり予測を棄権したりする必要があります。分類問題に限った場合、このような問題は selective classification problem と呼ばれます。この記事では分類問題のみを取り扱います。

この記事で紹介する DeepGamblers では、ポートフォリオ理論(その中でも単勝競馬レースに限定)から着想を得た損失関数を提案して、従来手法よりもシンプルで高性能なモデルを構築しました。

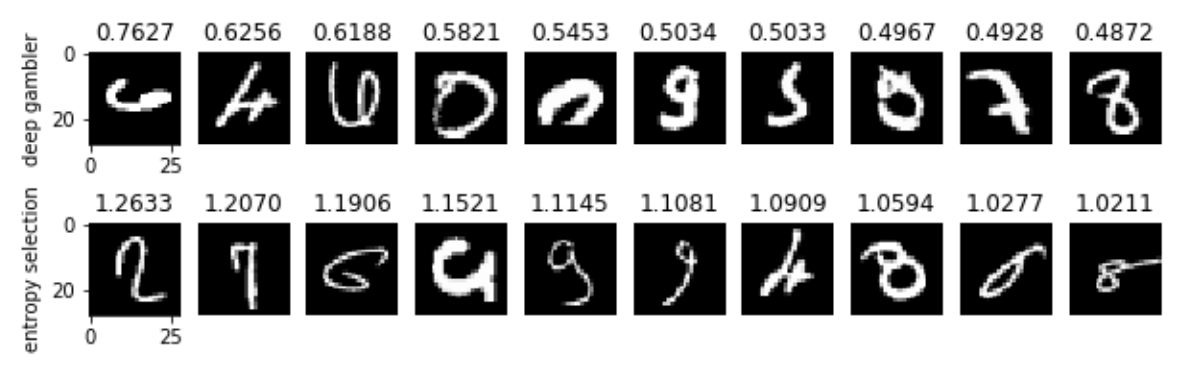

典型的な結果として、DeepGamblers が算出できる棄権スコアが高い順に MNIST のデータを並べると以下のものが得られます。確かに人間が見てもどの数字かが分類できないような数字が選ばれていることが分かります。

棄権スコアの上位10件を並べた結果。上が DeepGamblers の結果で下が比較手法の Entropy Selection の結果です。論文 (https://arxiv.org/abs/1907.00208) より引用。

以降では、このモデルがどのように構築・学習され、先行研究とどのように違うかを解説します。

続きを読むには

(6779文字画像6枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー