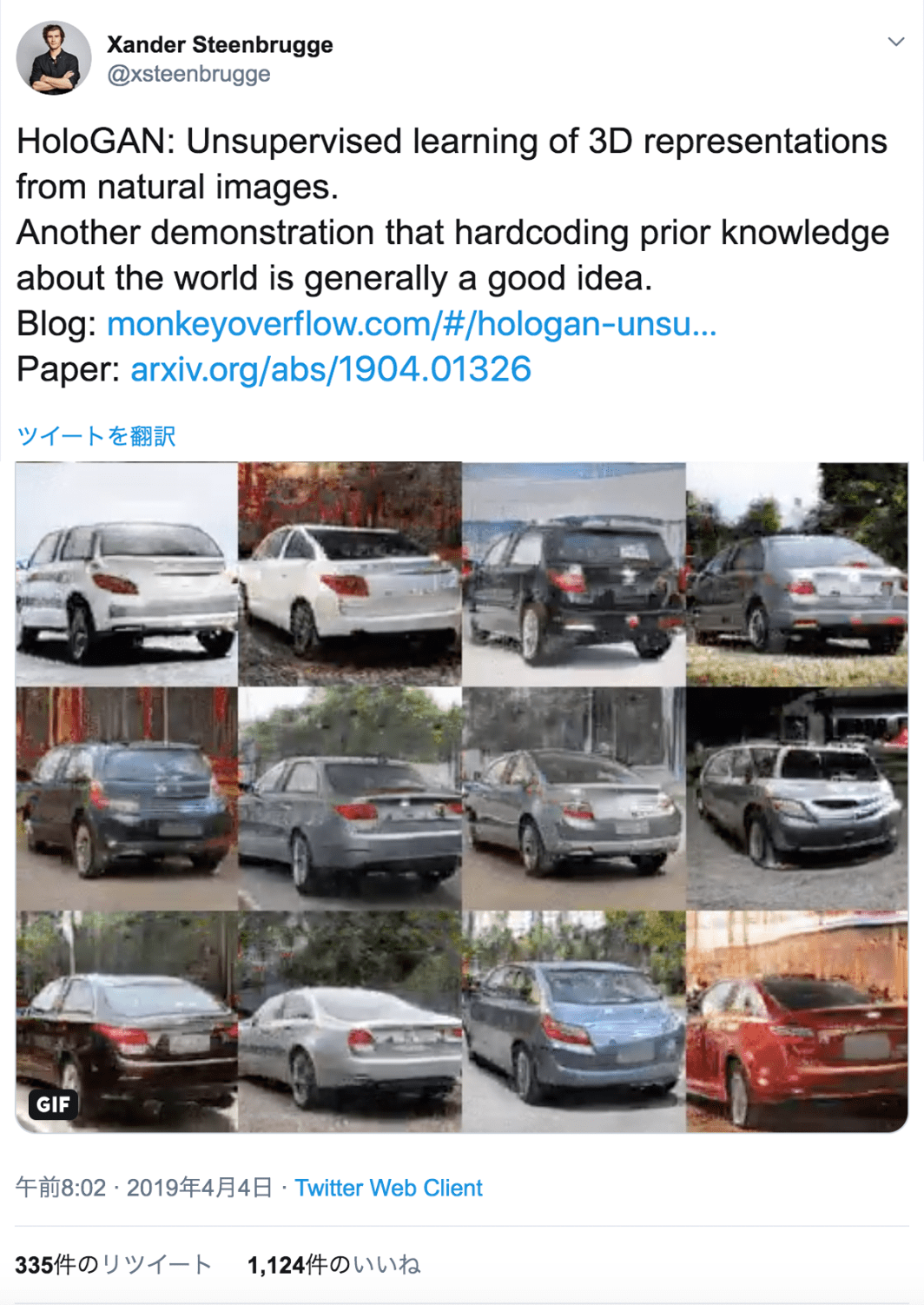

自然画像から3D表現を学習する新しい生成モデルHoloGANが登場

3つの要点

✔️ GANを用いて3D構造を意識した生成

✔️ 2Dカーネルに依存しない方法

✔️ アイデンテティを保持しながら、方位角と仰角に沿ってポーズを滑らかに変化させることができる

HoloGAN: Unsupervised learning of 3D representations from natural images

written by Thu Nguyen-Phuoc, Chuan Li, Lucas Theis, Christian Richardt, Yong-Liang Yang

(Submitted on 2 Apr 2019 (v1), last revised 1 Oct 2019 (this version, v2))

Comments: Published by ICCV 2019. For project page, see this https URL

Subjects: Computer Vision and Pattern Recognition (cs.CV)

はじめに

先日、GANで3D構造を意識した生成を行う論文が発表されました。本稿では、自然画像からの3D表現の教師なし学習を実現する、HoloGANと呼ばれる生成型敵対的ネットワーク(GAN)が提案されています。

GANを用いて3D構造を意識した生成を行う新しい論文が発表されました。

ツイッターでもかなりバズってたのでご存知のかたも多いのではないでしょうか。

本稿では、自然画像からの3D表現の教師なし学習を実現する、HoloGANと呼ばれる生成型敵対的ネットワーク(GAN)が提案されています。

続きを読むには

(2405文字画像10枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー