芸術的な画像と文字の自動合成を可能にする新たなGAN

GANは著しい発展を遂げています。しかし、人間の要求に即座に対応することができる画像合成モデルは、いまだに多くありません。新しく発表された論文では、芸術的な文字変換を即座に行うGANモデル「Controllable Artistic Text Style Transfer via Shape-Matching GAN」が提案されています。このモデルは、イメージと文字の合成度合いを芸術的要素か読みやすさの要素の度合いで、双方向的に手動で調整することができます。

参考論文 : Controllable Artistic Text Style Transfer via Shape-Matching GAN

画像と文字はそれぞれ異なる性質を持っている

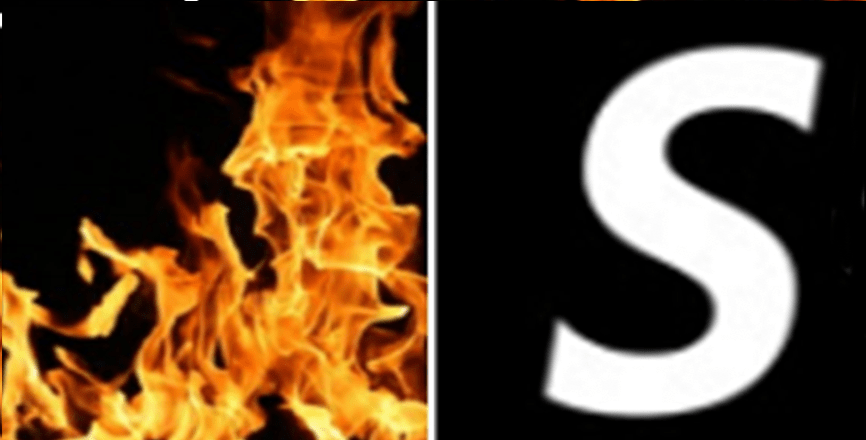

画像と文字はそれぞれ異なる性質を持っています。なぜなら、画像は”芸術的イメージ”を、文字は”読みやすさ”をそれぞれ重視している傾向があるからです。では、画像と文字の合成、例えば”S”という文字に”燃えているような”エフェクトを合成させる作業は自動化させることができるのでしょうか?

この論文では、画像とイメージを合成し、さらに実用性を考え「どの程度文字の原型を残して、イメージの度合いを強くするか」を操作可能なパラメータとして設定可能にします。このパラメータを調整することにより、即座に”文字の変形度合い”を変更することができます。テストでは、複数の画像イメージを一つの文字に合成することにも取り組んでいます。

イメージと文字の合成における難しさ

これまでの研究においても、画像イメージと文字の合成は試みられてきました。しかし従来のモデルでは、今回のように”単一”のイメージ画像を元に”ユーザーが満足行く度合い”での合成を行うには課題がありました。一つは、訓練データとなる十分なソースがないこと。もう一つは、画像の合成度合い(イメージと文字のバランス)は主観的なものであるため、必要に応じてどのような配分で合成すべきか異なるうえ、その度合いを測る指標がないことです。

論文では「スケッチモジュールシステム」と「文字とイメージの合成バランスの調整機能」を実現することで、2つの課題(ソースの確保と即座な調節)を解決しています。

モデル概要

大きく3つのタスクに分けて、画像と文字の合成を行っています。

続きを読むには

(2818文字画像8枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー