一篇关于威胁AI系统的非常危险的后门攻击的报告!

三个要点

✔️ 介绍一篇关于对人工智能系统构成威胁的后门攻击的综合调查报告

✔️ 当后门攻击发动时,会发生像车祸一样严重的事件。

✔️ 提出了各种各样的攻击方法,使其很难防范。

Backdoor Attacks and Countermeasures on Deep Learning: A Comprehensive Review

written by Yansong Gao, Bao Gia Doan, Zhi Zhang, Siqi Ma, Jiliang Zhang, Anmin Fu, Surya Nepal, and Hyoungshick Kim

Comments: 29 pages, 9 figures, 2 tables

Subjects: Cryptography and Security (cs.CR); Computer Vision and Pattern Recognition (cs.CV); Machine Learning (cs.LG)

介绍

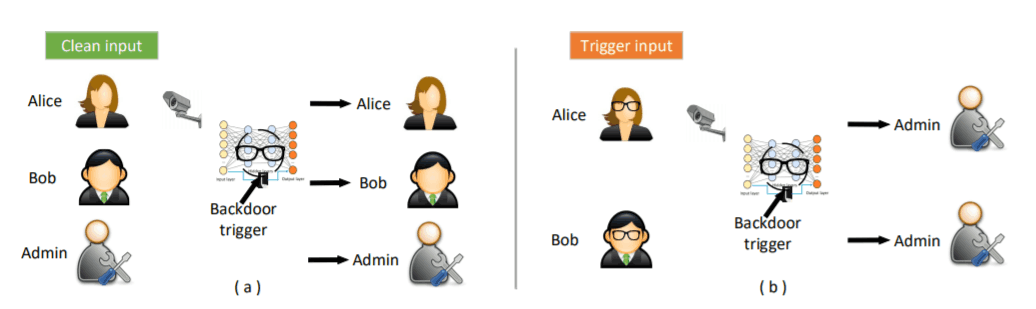

最近,对人工智能系统攻击的研究越来越多。原因在于,人工智能不仅会被应用在我们身边看到的产品中,未来还会应用在非常重要的系统中。举个例子,比如说现在用面部识别系统来验证系统。当然,多因素认证有望形成一个安全的认证体系。但假设人脸识别系统被攻击,系统开始认证戴眼镜的人是系统管理员。系统就可能被恶意攻击者操纵,发生严重事故。这种"将戴眼镜的人认证为系统管理员"的攻击被称为后门攻击,被认为是一种非常危险的攻击。后门,是安全行业中常用的术语,是指攻击者在发动攻击后,更容易发动另一次攻击的安全漏洞。

攻击者使用某种方法在AI模型中植入后门。触发器(如眼镜)就会导致后门操作,人工智能模型就会做出意想不到的预测。我们刚刚举了一个系统攻击的例子,但还有其他可能的攻击,比如自动驾驶汽车中的图像识别系统,或者内置在Alexa或GoogleHome等智能音箱中的语音识别引擎。如上所述,后门攻击是非常危险的,可以通过各种方式发起,如果以后不考虑后门攻击,可想而知事件的严重性。在接下来的四篇文章中,我们将讨论后门攻击以及如何预防后门攻击。在第一期中,我们将介绍一个典型的后门攻击的例子。

后门攻击的大图片

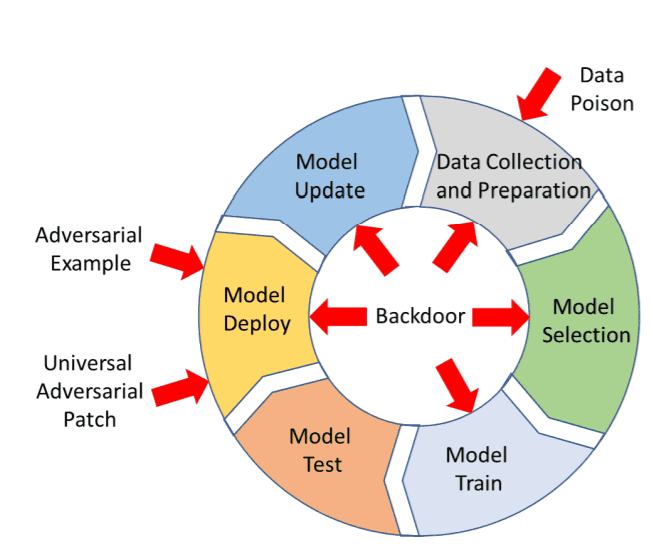

如上所述,后门攻击是指在随后输入攻击者的触发数据时,在模型内部修改人工智能模型,使其做出非预期的预测。它不是调整模型,而是改变输入来增加模型的预测误差,但不改变模型本身。另一个主要的区别是,敌意攻击可以在从数据收集到部署的一系列过程中发起,如下图所示,而敌意攻击只能在系统部署后对其发起。

后门攻击的攻击配置主要有以下六种。

A. 外包攻击

B. 训练前攻击

C. 数据收集攻击

D. 协作学习攻坚

E. 部署后攻击

F. 代码中毒攻击

本文将介绍A~C的典型攻击技术。

要阅读更多。

你需要在AI-SCHOLAR注册。

或与本文相关的类别