你能保护你的数据免受深度学习的影响吗?

3个要点

✔️ 提出一种方法来创建不能被深度学习模型用于训练的$unlearnable$数据。

✔️ 通过噪声使误差最小化,防止个人数据在未经允许的情况下被深度学习模型使用或滥用。

✔️ 展示$unlearnable$数据在各种条件下的有效性。

Unlearnable Examples: Making Personal Data Unexploitable

written by Hanxun Huang, Xingjun Ma, Sarah Monazam Erfani, James Bailey, Yisen Wang

(Submitted on 13 Jan 2021)

Comments: Accepted to ICLR2021 Spotlight

Subjects: Machine Learning (cs.LG); Cryptography and Security (cs.CR); Computer Vision and Pattern Recognition (cs.CV); Machine Learning (stat.ML)

首先

深度学习的成功是由从互联网收集的大量数据集支持的。然而,我们不能保证互联网上的数据会在征得同意的情况下被收集或用于合法目的。

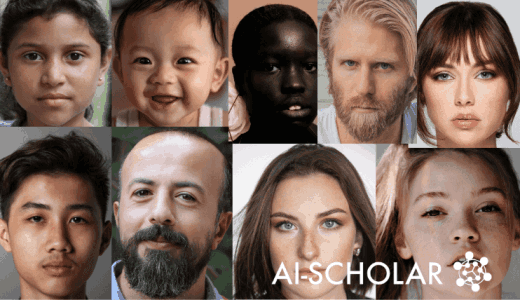

例如,在社交网站上发布的自拍照片可用于创建人脸识别系统,或创建根据人脸照片识别人的个人资料的系统。这样一来,在互联网上发布的个人资料可能会在当事人不知情的情况下被使用,并可能被滥用于非法目的。

为了解决这些问题,本文提出了一种通过深度学习创建"不可学习"($unlearnable$)数据的方法。这涉及到向图像添加噪声(到人类无法识别的程度),使使用它进行训练的深度学习模型无法有效地执行。

它在某些方面与Adversarial Attack相似,但在这种方法中,一个特点是让模型相信没有什么可以学习的,通过添加噪声使损失(误差)最小化。

技巧

确定问题和目标

首先,我们介绍一下问题的设置。

假设的任务是一个使用深度神经网络(DNN)的图像分类任务。

对于$K$类的分类任务,让$D_c$是干净的(没有$不可学习的$数据)训练数据,$D_t$是测试数据,$f_\theta$是在$D_c$上训练的DNN。 (例如,MNIST训练集表示为$D_c$,测试集表示为$D_t$,在$D_c$上训练的一些模型表示为$f_\theta$)。

现在,我们将干净的训练数据$D_c$转换为$不可学习的$数据$D_u$(例如,通过在$D_c$中的一些图像中添加噪声)。 目标是生成$D_u$,使用$D_u$训练的DNN在测试数据$D_t$上表现更差。

更详细地说,给定清洁训练数据$D_c$中的$n$例子,我们可以表达$D_c=\{(x_i,y_i)\}^n_{i=1}$(其中$x \in X \subset R^d$是输入,$y \in Y=\{1,...,K\}$为标签,$K$为总类数)。)

另外,$unlearnable$数据$D_u$表示为$D_u=\{(x^{\prime}_i,y_i)\}^n_{i=1}$。 这里,$x^{\prime}=x+\delta$,$x \in D_c$,$\delta \in \Delta \subset R^d$是不可见(不可识别)的噪声。

在这种情况下,$||\delta||_p \leq \epsilon$($||・||_p$是$L_p$的规范)。

此外,图像分类任务中的DNN模型在$D_c$上学习一个从输入空间到标签空间的映射$f:X→Y$。 在这种情况下,最终的目标可以用下面的公式来表示。

$arg min_\theta E_{(x^{\prime},y) \sim D_u} L(f(x^{\prime}),y)$

其中$L$是常用的分类损失,如交叉熵损失。 如前言所述,目标是产生噪声,使误差最小化(注意是arg min)。

要阅读更多。

你需要在AI-SCHOLAR注册。

或与本文相关的类别

![[谷歌开发] 在机器学习系统中审计隐私保](https://aisholar.s3.ap-northeast-1.amazonaws.com/media/February2024/privacy_auditing-520x300.png)