LLMは意識を持っているのか?

3つの要点

✔️ LLMは意識を持っているのかという疑問について議論した論文

✔️ 意識を持っている・持っていないと言えるための根拠についてひとつずつ解説

✔️ 現状,意識を持っているとは言えないが,今後その可能性が高まることは否定できない

Could a Large Language Model be Conscious?

written by David J. Chalmers

(Submitted on 4 Mar 2023 (v1), last revised 29 Apr 2023 (this version, v2))

Comments: Published on arxiv.

Subjects: Artificial Intelligence (cs.AI); Computation and Language (cs.CL); Machine Learning (cs.LG)

code:

本記事で使用している画像は論文中のもの、紹介スライドのもの、またはそれを参考に作成したものを使用しております。

※今回紹介する論文は,著者David J. ChalmersがNeurIPS 2022の会場で行ったInvited Talkをまとめたものです.トークの内容はこちらから参照できます.

導入

2022年6月,Googleの技術者Blake Lemoineが,GoogleのAI,LaMDAが意識を持っていると主張しました.Googleはこの主張を認めず,LaMDAに意識が芽生えている証拠はないと主張し,彼を解雇することになりました.

しかし,果たしてAIに意識がないことを示す証拠とはどのようなものなのでしょうか?本論文の著者Chalmersはこの事件をきっかけに,AIに意識があるかないかを示すための証拠とはどのようなものかを考え始めました.

意識とは

意識は主観的な体験です.ある存在に意識があるとき,その存在は,ものを見る,感じる,考えるといった主観的な体験をしています.コウモリは超音波で世界を認識します.それがどのような体験であるかは我々人間にはわかりませんが,それでもコウモリは主観的な体験をしているということができ,意識を持っているということができます.一方で,ペットボトルのようなものは主観的な体験を持っていないということができます.

また,意識とは,多くの要素の集合体です.知覚に関連した感覚的体験や,感情に関連した情動的体験,思考や推論に関連した認知的体験,行動に関連したエージェントとしての体験,自分を認識するという自己意識などです.これらは全て意識の要素です.

また,意識は,人間レベルの知能を持っているかとは関係がありません.多くの人は,人間以外の動物にも意識があるという点で認識を共有しています.

意識があることを示すための基準を提示している定義(operational definition)がないのが,意識の問題の難しいところです.人間相手なら言語的記述をもって,意識があることの判断基準とできますし,動物相手なら,振る舞いを持ってその基準とできます.しかし,AIが相手となると,それは難しいのです.普段,AIの性能を評価するときは,我々はベンチマークを使用して評価しますが,意識を計測するためのベンチマークとはどんなものにするべきでしょうか.

そして,そもそも,意識があるかどうかはなぜ重要なのでしょうか.著者は,意識があることによって,特別新しい能力が得られるという保証はないとは言いつつも,推論や注意,自己認識など,特徴的な機能を獲得させる可能性もあると述べています.

また,意識は道徳的・倫理的にも重要です.意識を持っている存在を,我々人間がどう扱うか,にも関わってきます.我々は意識を持ったAIを作るべきなのかという疑問にも繋がってきます.

この節では,意識とは何か,AIに意識を持たせることの意味について,様々な点を紹介しました.この論文で述べられているロードマップは意識を持ったAIを作るための条件を述べたものであり,そうすべきかどうかという問題とは分けて考えるべきであると言います.

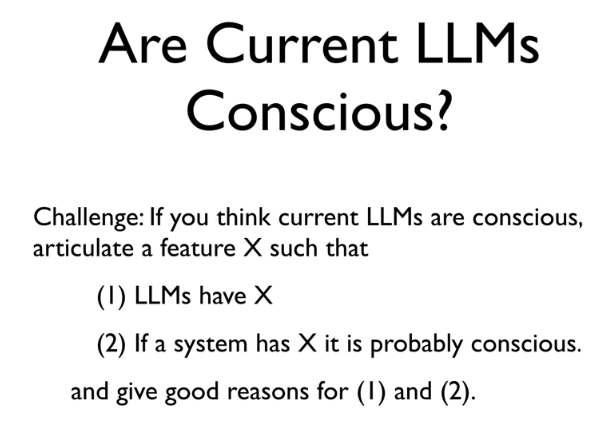

大規模言語モデル(LLM)に意識があると示すための証拠とは?

こちらの写真に示すように,あるシステムがXを持っているとしたら,それは意識を持っていることを示す根拠となり得るようなXを考えてみましょう.その候補として,以下の4つが挙げられています.

X = Self-Report

LaMDAはself-reportの能力があるような振る舞いを見せていました.(Blake LemoineがLaMDAに意識があると主張した根拠の大部分はこの項目に基づいています)

しかし,多くの人が指摘しているように,LaMDAは容易に手のひらを返したような逆の挙動を示すことがあります.これでは,self-reportの項目は現状のLaMDAが意識を持っていることを示す根拠としては弱いでしょう.

また,LaMDAは,意識についての文字情報を大量に学習に用いている点も問題です.

X = Seems-Conscious

LLMが意識を持っているように振る舞うこともXの候補の一つかもしれません.しかし,人は意識を持っていないものに対しても意識があると誤認してしまうという現象も広く知られており,このXは根拠としては弱いでしょう.

X = Conversational Ability

現在のLLMは会話において,一貫した思考や推論を行う能力を示しており,高度な会話能力を有しています.チューリングは,この会話能力を思考の特徴として位置づけていました.今後もこの能力は発展していくことが期待されます.

X = General Intelligence

会話はもっと深い,汎用的な知性を示すサインになりえます.現在のLLMは,ドメインジェネラルな能力を示し始めています.コーディング,詩作,ゲームプレイ,質問回答など様々な能力が実現されています.このドメインジェネラルな情報利用こそが意識を持っている証拠の中心的なものだと考える人がいます.

以上のような項目が挙げられますが,現状ではLLMが意識を持っていると考えるに足る強力な証拠はないと著者は言います.

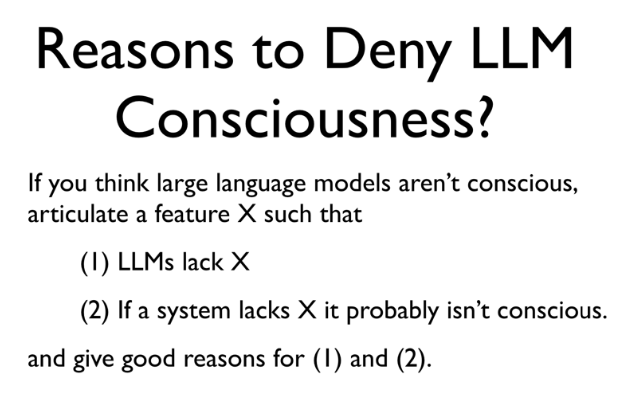

大規模言語モデル(LLM)に意識がないと示すための証拠とは?

逆に,意識がないことを示すための証拠としてどのようなものが考えられるでしょうか.こちらの写真に示すように,あるシステムがXを欠いているとしたら,それは意識を持っていないことを示す根拠となり得るようなXを考えてみましょう.その候補として,以下の6つが挙げられています.

X = Biology

これを,AIが意識を持っていないことの証拠としてしまえば,議論は片付きますが,著者はこの点は議論の対象から外しています.

X = Sense and Embodiment

多くの人は,現在のLLMは知覚的処理を持っていないので,感覚というものを体験できないし,身体を持っていないので,行動することができないという点を挙げます.Stevan Harnadやその他の研究者は,1990年代に,AIが意味や理解,意識を獲得するには,環境にgroundingする(意味と実世界の体験を結びつける)必要があると主張しています.最近でも,多くの研究者がLLMが物事に対するロバストな理解を行うためには,知覚的なgroundingが必要だと主張しています.

一方で,本論文の著者は,意識や理解のために必ずしも感覚や身体は必要ないと主張しています.それらを持たない存在でも意識は持ちうる(それが限られた意識だとしても)としています.

また,最近ではLLMに視覚情報を扱える機能を持たせたり(DeepmindのFlamingo)とか,実世界やバーチャル世界で行動を行わせたり(GoogleのSayCan)など,言語以外を扱えるように機能を拡張させることができており,将来のLLMはSense and Embodimentの点を克服できるでしょう.

X = World-Models and Self-Models

LLMは統計的なテキスト処理を行っているだけであり,我々が持っているような世界のモデルから意味や理解を得るという処理は行えていないという主張が多くの人によってなされています.

これに対して,著者は,訓練時と実行時の処理を分けて考えることが重要だと述べています.LLMは単語予測の誤差を最小化するように最適化されていますが,だからと言ってLLMは単語予測以外の処理ができないということは意味してはいません.単語予測の誤差最小化のためには,他の様々な処理も必要とされ,その中には世界モデル的な処理も含まれているかもしれないのです.ちょうど,生物進化の自然淘汰において,適応度が最大化されるように進化が生じた結果として,ものを見るとか飛ぶとか世界モデルを獲得するとかといった様々な機能が獲得されたのと同じことです.

Self-modelsに関して,現在のLLMは自らの処理や推論に一貫性がありません.Self-modelsは自らを意識するということにとって重要な点であり,それは意識の要素としても重要です.

X = Recurrent Processing

意識に関する多くの理論では,再帰的な処理が重要であると言われています.現状のLLMはフィードフォーワード処理に基づいているため,時間を超えて保持される内部状態のような記憶の処理を持っていません.

一方で,意識に再帰的処理は必要ではないのではないかという考え方もあります.

X = Global Workspace

現在,認知神経科学で主導的な意識の理論として言われているのが,global workspace theoryです.能力に限界があるワークスペースがあって,他の無意識的なモジュールから情報を集約してきて,このワークスペースに入ったものが意識にのぼるという考え方です.

現在,LLMを様々なモダリティに拡張した研究が複数提案されていて,それらのモデルにおいては,モダリティごとの情報を統合する空間として低次元の空間が用いられています.これはまさにglobal workspaceに相当しているように考えられます.すでにこのようなモデルを意識と絡めて議論している人も出てきています.

X = Unified Agency

現状のLLMは,一人の統合した人格としての振る舞いを示すことはできていません.状況によってあらゆる人格を使い分けます.多くの人は,統一された人格が意識にとって重要であると主張しているため,その点で,現在のLLMが意識を持っていないことの根拠として使用されます.

一方で,反対意見もあります.人格が複数ある人もいますし,LLMは複数の人格エージェントのエコシステムだと考えることもできるからです.

建設的な議論をすると,LLMに一つの人格だけを持たせることも技術的には可能でしょう.

以上で指摘したXについて,部分的にではあれ,実際にLLMに導入しようとする事例はすでに存在しており,今後数十年でこれらのXをロバストな形で取り入れたシステムが実際に登場することは十分あり得るでしょう.

まとめ

今後十年で人間レベルの知能ではないにしても,マウスレベルの知能に達することは十分に考えられ,そこまで行けば,AIが意識を持つ可能性はあるかもしれないと著者は言います.意識を持たせるべきかどうかには多くの課題や異論がありますが,上記で挙げられた課題を克服することが,意識のあるAIを実現させるための道筋となるでしょう.最後に問題となるのは,これらの課題が全て克服されたとして,全ての人がAIに意識があると認めるのだろうか?認めない人がいるのならば,何が欠けているのだろうか?という点です.

著者は最後に,もう一度,今回の論文で,AIに意識を持たせるべきだと主張しているわけではないと,断りを入れています.ここに示した課題のロードマップは,AIに意識を持たせようとするならば取り組まなければならない点であり,逆に,AIに意識を持たせたくない場合には避けるべき点なのです.重要なのは,意図せずに意識を持ったAIを作ってしまわないように,これらの点に注意を払っておくべきだということだと述べています.

今回は,昨今進歩が目覚ましい大規模言語モデルに意識は芽生えるのかという,興味深い疑問を扱った論文をご紹介しました.AIに意識を持たせるべきか否かという点は,今後活発に議論されることになるでしょうし,我々個人でも立場を明確にしておくことが求められるでしょう.今回の記事がそのための第一歩になっていれば幸いです.

この記事に関するカテゴリー