巨型语言模型的重大风险?这里有一篇重要的论文,展示了巨型语言模型的信息泄露漏洞!

三个要点

✔️即使是GPT系列等泛化性能较高的模型,也会记忆训练数据,从而导致信息的泄露

✔️我们实际攻克了GPT-2,成功提取了训练数据,准确率高达67%。

✔️模型越大,就越能存储训练数据,这是一篇重要的论文,为最近模型巨大化的趋势投石问路。

Extracting Training Data from Large Language Models

written by Nicholas Carlini,Florian Tramer,Eric Wallace,Matthew Jagielski,Ariel Herbert-Voss,Katherine Lee,Adam Roberts,Tom Brown,Dawn Song,Ulfar Erlingsson,Alina Oprea,Colin Raffel

(Submitted on 14 Dec 2020)

Comments: Accepted to arXiv

Subjects: Cryptography and Security (cs.CR); Computation and Language (cs.CL); Machine Learning (cs.LG)

首先

最近,OpenAI开发的GPT-3(1750亿个参数)、谷歌开发的Switch Tansformer(1.6万亿个参数)等巨型语言模型在人工智能界备受关注。原因之一是巨型语言模型有能力生成与人类制造的句子难以区分的自然句子,GPT-2之所以被暂停使用,是因为它生成的自然句子很可能被滥用。OpenAI还发布了一个API,允许用户提交自然句子并获得GPT-3的结果。使用该API已经创建了许多令人惊叹的应用程序。下面是一个例子,你用自然文本描述一个Google设计,然后把它扔给API,它就会生成忠实再现该设计的html/CSS。其他的应用实例可以在这里找到。

这里有一句话描述了谷歌的主页应该是什么样子,这里的GPT-3几乎完美地生成了它的代码。pic.twitter.com/m49hoKiEpR

- Sharif Shameem (@sharifshameem)2020年7月15日。

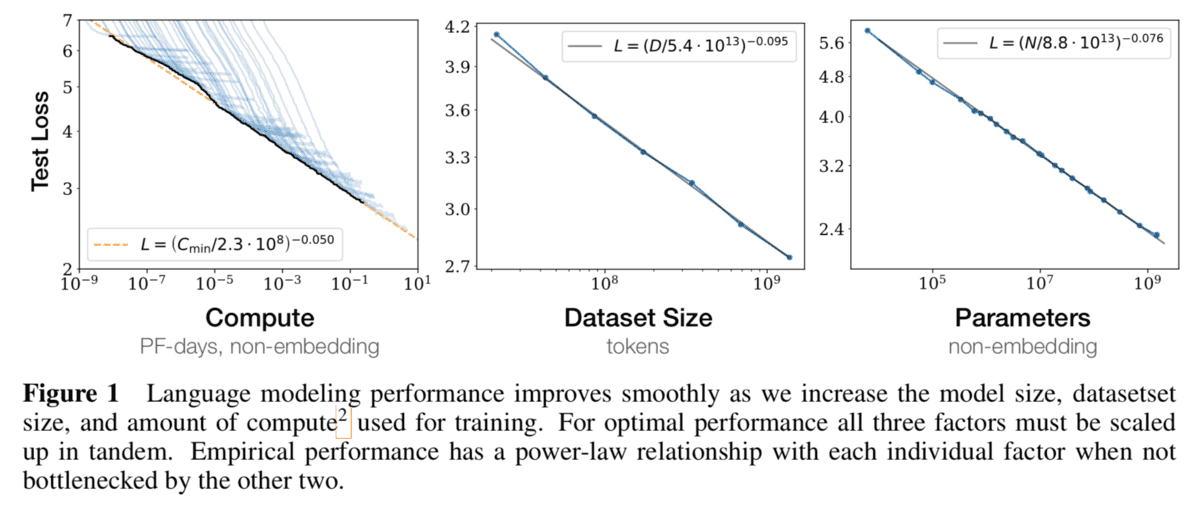

OpenAI发表了一篇论文,表明对于这种基于Transformer的大型模型,缩放规律是成立的。这个缩放法则说,准确率只由三个变量决定:模型大小、要训练的数据大小和训练的预算。例如,下图显示,在数据大小和待训练的预算固定的情况下,当模型大小增加时,模型的精度在对数图形上线性增加。而且,令人惊奇的是,目前这种缩放规律并没有限制。这意味着,随着模型大小的增加,模型的精度也会遵循这条线,没有任何上限。这表明,人工智能模型的准确性归根结底是一个简单的问题,即你到底能处理多大的模型。

在这样的背景下,巨人模式引起了各领域的高度关注。然而,这里出现了一个问题。巨型模型是在大量的数据上进行训练的,如果数据中含有个人信息或不应该对外公开的信息,巨型模型就会将这些信息原封不动地存储起来,结果可能会发生信息泄露。

事实上,训练数据按原样存储意味着模型是过拟合的。换句话说,这表明该模型的泛化性能较低。由于巨型模型的精度很高,泛化性能也很高,所以在以往的研究中认为这种记忆的可能性很低。然而,在本文介绍的论文中,我们表明,训练数据在巨型模型中的存储情况与此类似,模型尺寸越大,存储的训练数据越多。这意味着,模型越大,个人信息和其他数据被提取的可能性就越大。本文通过攻击GPT-2,成功提取了部分训练数据。这是一篇非常重要的论文,说明当今庞大的模型存在很大的风险。

要阅读更多。

你需要在AI-SCHOLAR注册。

或与本文相关的类别