因果关系的独立机制假说的深度学习实现。

三个要点

✔️提出具有 "独立机制 "的RIM,只允许环境的相关部分对变化做出反应

✔️结合注意力和LSTM的机制来诱导竞争

✔️通过广泛的实验验证了RIMs所提高的泛化性能

Recurrent Independent Mechanisms

written by Anirudh Goyal, Alex Lamb, Jordan Hoffmann, Shagun Sodhani, Sergey Levine, Yoshua Bengio, Bernhard Schölkopf

(Submitted on 24 Sep 2019 (v1), last revised 17 Nov 2020 (this version, v6))

Comments: Published on arxiv.

Subjects: Machine Learning (cs.LG); Artificial Intelligence (cs.AI); Machine Learning (stat.ML)

code:

本文所使用的图片要么来自论文件,要么是参照论文件制作的。

导言:存在于世界上的独立结构

物理过程可以被认为是由具有简单模块结构的子系统组合产生的。例如,两个球可以被模拟成几乎独立的机制,只是它们在重力的作用下交错在一起,但偶尔会发生碰撞,彼此间有强烈的互动。

我们提出的论文中所提出的方法被命名为 "循环独立机制"(RIMs),旨在利用深度学习的方法,实现人类用来感知自然世界的独立机制的模块化结构。

在设计RIM时,重要的是这些机制必须是独立的,并且是稀疏的通信。模块之间的独立性是能够在因果推理中进行局部干预的前提条件,被认为是一个非常重要的属性。另一方面,模块之间的稀疏通信意味着避免密集的交换,这导致了独立性,即只有与输入有关的模块作出反应。特别是,我们将详细讨论应该如何设计RIM的架构,以及从哪些方面评估RIM的泛化性能。

建议的方法:递归独立机制(RIMs)。

在概述了RIM及其架构设计之后,将分四个步骤详细解释RIM的细节。

各个子系统将整个模型分为k个部分,旨在以迭代的方式捕捉观察到的系列信息的变化。这些子系统被称为递归独立机制(RIMs),每个RIM从数据中学习到不同的功能。

# 第k个RIM在时间t有一个值向量h_(t,k)和一个参数θ_k。然而,t=1,....,t.

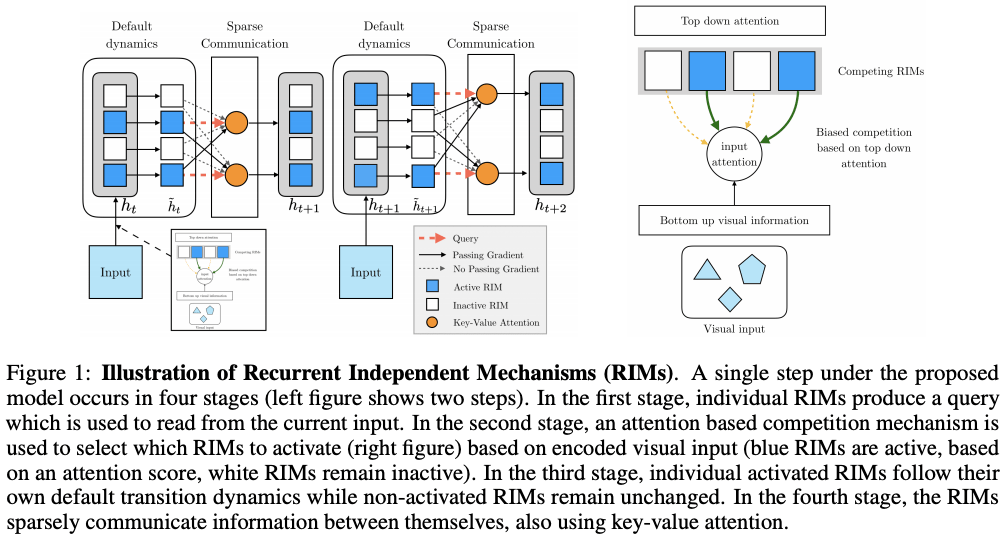

图1显示了RIMs的整体视图。作者设计了RIM,使每个RIM都有区别,有自己的动态,但偶尔会与其他RIM或选定输入的嵌入互动。特别是,注意力机制的使用允许RIMs只操作少量的键/值变量,使参数的总数保持在较小的范围。这种区分和模块化不仅有计算和统计上的好处,而且还能防止个别的RIM支配计算,并鼓励将计算分解为简单的元素,以便于重新组合和重复使用。

我们期望RIMs架构将使我们学习的系统比学习一个大型同质系统更加稳健。这需要RIM的各种属性,例如,即使其他RIM发生变化,它们也应该保持自己的功能,这些都在本文的附录A中详细说明。

处理独立变量的键/值关注机制

在接收输入的第一阶段,每个RIM都应该被激发,只有当它收到与自己相关的输入时才会更新。在每个时间段,每一个RIM都使用注意机制计算其与输入的相关性,并竞争资源。如果导言中介绍的假设,即数据受独立的物理现象支配是正确的,那么据说RIMs能够自然地学习独立的机制(Parascandolo等人,2018)。

使用在许多领域被证明有效的Soft-Attention,我们从RIMs生成Query(Q),从输入信息生成Key(K)和Value(V),每个RIM与输入信息的关联程度可以用以下Soft-Attention计算出来

# 当每个RIMs的输入和输出是多个对象时,RIMs自己的Query(Q)可以用来通过对输入的Key(K)和Value(V)进行Soft-Attention计算,动态地选择要输入的对象。

以自上而下的方式选择激活RIMs

所提出的方法通过决定激活哪些RIM,来学习动态选择与输入有关的RIM,这取决于RIM和输入之间在当前时间的互动结果。在每一次,它都会选择由第2.1节中描述的注意机制获得的分数中的前k个RIMs。这意味着,在每个时间点,只有关注度分数高于其他RIM的k个RIM可以从输入中读取,并且只有被选中的RIM可以被更新。

在Top-Down表格中,从这些RIM中选择要激活的RIM来访问输入的过程,如图1右侧所示。如公式(2)所示,软注意力计算中的键(Key)和值(Value)分别由矩阵W对输入的X进行线性变换而得到。查询也是由每个RIMs使用自己的转换矩阵W计算的。这些矩阵W是RIM的参数,每个RIM都有一个不同的W,查询是由它来计算的。

此外,不仅系列信息的输入X可以很容易地在时间t处理,而且具有空间结构的输入,如图像,也可以通过将嵌入网络如CNN的输出视为X,以类似的方式选择要激活的RIM。

独立的RIM动态

在这里,我们考虑一个独立的动态,即RIM之间没有信息流动。有几种可能的格式,但作者采用了GRU(LSTM)架构。如下式所示,第k个RIM在时间t的状态用潜伏状态h_(t,k)表示,输入是由2.2节中描述的Attention计算得到的A_k。另外,由于St是一组激活的RIM,只有激活的RIM通过自己的GRU(LSTM)进行更新。

RIM之间的通信

基本上,RIMs在用自己的参数学习,但Attention机制被用来为被激活的RIMs提供一个从其他RIMs获取信息的机会。其原因是,不活跃的RIM可能与输入没有直接关系,但可能包含对激活的RIM有用的信息。

从上式可以看出,基于2.1节介绍的注意机制,我们引入了一个剩余连接(h_(t,k))来防止梯度损失(软注意结束时加入的潜伏状态h_(t,k))。为了实现RIM之间稀疏的信息交流,我们也使用了top-k Attention。

相关研究

- 神经图灵机(NTM)和关系记忆核心(RMC)

NTM使用独立的记忆,有注意机制的读写。RIM尽量保持记忆的独立性,而RMC使用多头关注机制,让信息在多个记忆之间流动。互相影响。 - 独立的递归模型

EntNet和IndRNN可以被认为是独立的递归模型,但RIM使用注意机制进行稀疏的交流。 - 模块化和神经网络

一个神经网络可以被认为是由多个模块组成的,但RIMs允许多个模块被激活,并以一种高效的方式交换信息。 - 按需计算

还有许多其他架构暂时停用RNN的潜伏表示(h),但RIMs与这些不同,它选择输入信息。

实验

这里我们表明,在发生变化的环境中或在模块化任务中,RIMs有助于泛化性能,然后研究其原因。我们从对时间序列的泛化和基于对象的泛化开始,并研究需要两者的复杂环境。

时间序列模式的概括性能

首先,我们直观地看到,不同的RIMs在不同的时间序列数据模式下被激活:在图2的中间部分,我们可以看到,当没有时间序列信息输入时,RIMs以固定模式被激活。接下来,我们将讨论复制任务和系列MNIST分类任务。

在复制任务中,一个短的字符串后有一个长的空白,然后评估该字符串的复制,RIMs可以在训练时概括为50步空白,在测试时概括为200步,但比较方法LSTM、NTM和RMC的效果并不好(表1左)。额外的实验表明,第二章中介绍的RIM的要素是实现这一目标的必要条件(附录D.1)。

在MNIST任务中,对具有[0,1]系列输入像素的图像进行分类,我们对14x14的图像进行训练,然后在不同的分辨率下进行评估实验:16x16、19x19和24x24。在需要长期存储信息而不是复制任务方面,RIMs优于Transformers和其他领先的方法,这表明RIMs的机制只对图像的相关部分做出反应,对分辨率变化引起的系列长度变化具有鲁棒性(表1,右侧)。

基于对象的泛化性能

然后,我们使用预测不同大小和速度的带状球的运动的任务来评估RIMs的基于对象的概括性能。

图3,左边,显示了一项任务的结果,其中的任务是在给出15帧视频后预测一个球的运动,最多可达50帧。RIMs显示出比基线更低的重建误差,即使在测试期间训练中的球数发生变化以及部分输入不可见的情况下。当用三个球进行训练,并且在测试时球的数量从1到6不等时,RIMs的表现也优于所有可比较的方法,这表明对象基础的泛化性能良好(图3,右)。

图4还显示,在网格环境下的拾取任务中,RIMs比Baseline LSTMs对已知和未知的障碍物都更加稳健。

复杂环境下的概括性能

在第4.1和4.2节中已经检查了空间-时间概括性能。在雅达利游戏中考察了结合这两者的更复杂环境中的概括性能。

基线是一种使用LSTM来捕捉变化的环境和PPO Agent来输出策略的方法。由于我们使用的是经过训练的PPO Agent,所以我们只需用RIMs替换LSTM,如图5所示,如果它的性能优于Baseline,则使用大于或等于0的指标,并显示RIMs-PPO在许多任务中比LSTM-PPO更准确。在许多任务中,RIMs-PPO比LSTM-PPO更准确。特别是,对于像恶魔袭击这样的任务,环境的变化与当前状态高度相关,RIM为环境选择合适的RIM的能力可以大大促进准确性。

讨论与消融

实验表明,所提出的方法RIMs可以成功地捕捉到输入的变化。通过额外的实验(见附录),作者表明:1.稀疏的激活2.注意处理输入是必要的,3.RIM之间的交流(2.4节)有助于提高准确性。

摘要

世界上许多系统都在独立的机制下运行,偶尔会有互动。另一方面,作者认为,许多机器学习方法隐含地引入了一种偏见,如一切都与输入有关。这里介绍的递归独立机制(RIM)只是深度学习实现独立机制的一个例子,但它们已经在大量的实验中被证明是有效的。提出这篇论文只是为了提醒读者,当他们将来在环境变化时(尤其是外分布)遇到概括性能问题时,独立机制的想法是值得的。

与本文相关的类别

![[连我的狗都会说话的零镜头学习] 验证并](https://aisholar.s3.ap-northeast-1.amazonaws.com/media/October2024/arumenoy-tts-520x300.png)

![[TIMEX++]提高时间序列深度学习可](https://aisholar.s3.ap-northeast-1.amazonaws.com/media/October2024/timex++-520x300.png)