Contrastive LearningとクラスタリングでSOTA!? (画像の表現学習2020夏特集3)

3つの要点

✔️ Contrastive Learningの難点ネガティブサンプリングをクラスタリングで回避

✔️ EMアルゴリズムとクラスタリングを組み合わせた手法PCL

✔️ クラスタリングの一貫性を目的とした学習で更に性能を向上した手法SwAV

Prototypical Contrastive Learning of Unsupervised Representations (PCL)

written by Junnan Li, Pan Zhou, Caiming Xiong, Richard Socher, Steven C.H. Hoi

(Submitted on 11 May 2020 (v1), last revised 28 Jul 2020 (this version, v4)])

Comments: Published by arXiv

Subjects: Computer Vision and Pattern Recognition (cs.CV); Machine Learning (cs.LG)

Paper Official Code COMM Code

Unsupervised Learning of Visual Features by Contrasting Cluster Assignments (SwAV)

written by Mathilde Caron, Ishan Misra, Julien Mairal, Priya Goyal, Piotr Bojanowski, Armand Joulin

(Submitted on 11 May 2020 (v1), last revised 28 Jul 2020 (this version, v4)])

Comments: Accepted at NeurIPS 2020

Subjects: Computer Vision and Pattern Recognition (cs.CV)

Paper Official Code COMM Code

ライター持ち込み特集企画「画像の表現学習2020夏」と題して、教師なし学習による各種手法をご紹介しています。

その1. ドメイン知識なし教師なし学習を実現したImage GPT、画像生成もすごい!

その2. Contrastive Learningの2大手法SimCLR・MoCo、それぞれの進化

その3. Contrastive LearningとクラスタリングでSOTA!?

その4. Contrastive Learningへの問い「What Makes?」

その5. 汎用性・実用性ともに優れたDeepMindの教師なし学習手法

二度に渡るAIの冬を乗り越え、大量の画像データセットImageNetで表現力を得ることで、2012年に画像のAIが大きく花開きました。しかし、これには人による画像のラベル付けに大きなコストが必要でした。これに対して、2018年に自然言語処理でフェイクニュースの懸念になるほど大きな社会的インパクトを与えたBERTは、莫大なデータをそのまま利用できることも大きな特徴です。

Contrastive Learning(対照学習)とは、コストのかかるラベル付けの代わりにデータ同士を比較する仕組みを使い、膨大なデータをそのまま学習できる教師なし学習の一つです。画像への応用で成果を上げてきており、すでにImageNet学習済みモデルの性能を超え、BERTのようにこれからのインパクトが画像分野で期待されています。

前回の記事では、このContrastive Learningについて、またその2大手法SimCLR・MoCoについて見てきました。

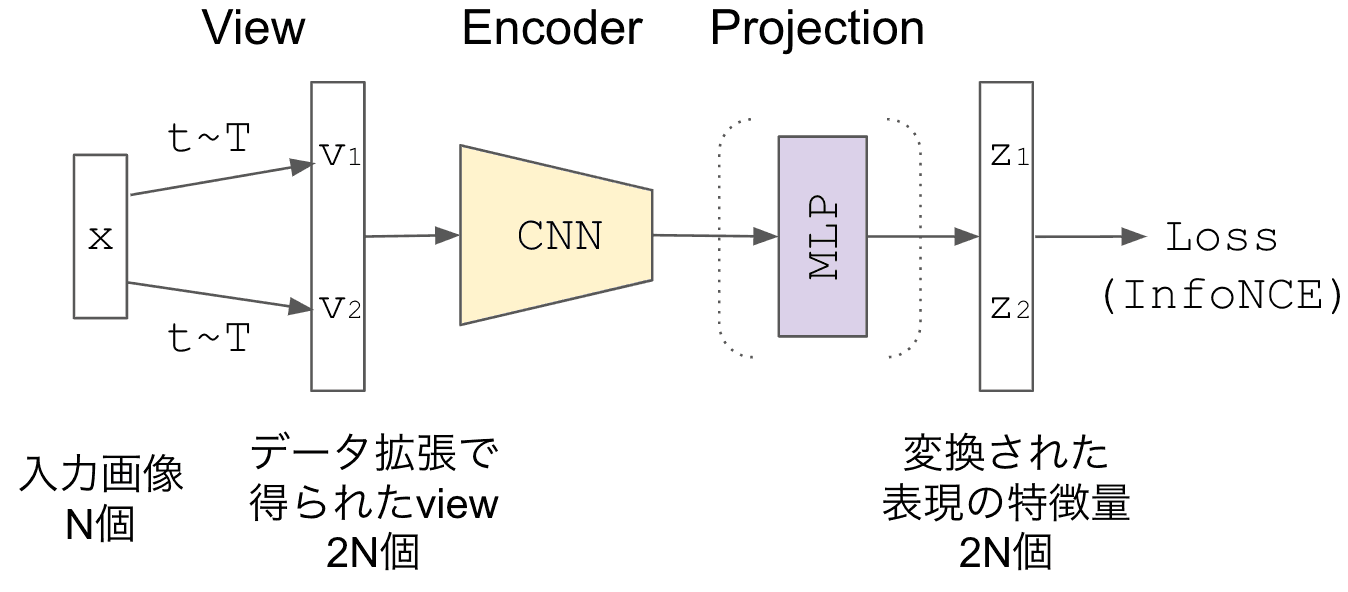

Constrastive Learning学習全体の様子 (ライター作成)

Constrastive Learning学習全体の様子 (ライター作成)

- SimCLRはストレートな実装で高い性能だが、ネガティブサンプルの数を増やすためバッチサイズが巨大になっていた。

- MoCoはその欠点を補うため、Memoryメカニズムでオンザフライにネガティブサンプルをキューイングする解決を図った。

MoCoのような解決方法以外に、クラスタリングで代表サンプル「プロトタイプ」を用意して、その代表を大量なネガティブサンプルの代わりにする方法があります。

今回はそのクラスタリングを活用した手法にフォーカスしたいと思います。

- EMアルゴリズムの枠組みで「クラスタリング」「最適化」を繰り返す堅実な手法PCL。

- クラスタリングの一貫性をタスクに置き換えることで性能を向上したSwAV。

続きを読むには

(7727文字画像18枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー