【Materials Informatics】個別残差学習により深層学習のポテンシャルを引き出すことに成功!

3つの要点

✔️ 個別残差学習(IRNet)によって深層学習の勾配消失・爆発問題を改善

✔️ 物質の化学組成などからその物質の性質を予測する深層学習モデルにIRNetを適用

✔️ 勾配消失・爆発問題の回避により、データ量が一定以上で層の数が多いほど、単純に予測性能が向上

Enabling deeper learning on big data for materials informatics applications

written by Dipendra Jha, Vishu Gupta, Logan Ward, Zijiang Yang, Christopher Wolverton, Ian Foster, Wei-keng Liao, Alok Choudhary & Ankit Agrawal

(Submitted on 19 February 2021)

Comments: Accepted by Scientific Reports (2021) 11:4244

Subjects: Artificial Intelligence (cs.AI); Machine Learning (cs.LG)

深層学習のマテリアルズ・インフォマティクスへの適用を目指して…

近年、材料研究者の間で、機械学習モデルを活用して所望の性質を持つ未知の物質を探索するマテリアルズ・インフォマティクス(MI)が注目を集めています。このMIでは、実際の手動の実験で得られたデータや、DFT計算によって算出された膨大な計算結果をデータセットとします。

(このDFT計算とは、固体材料科学の分野でよく使用される「密度汎関数理論(DFT)に基づいた第一原理計算」というものです。量子力学・量子化学をベースにして、理論計算によって物質の状態や性質に関する知見を得るというものです。材料科学分野以外の人には馴染みがないと思いますが、MIの分野ではよく出てくるものなので軽く知っておくと良いと思います)

機械学習を使用することで、例えば物質の化学組成や化学構造(Input)と物質の性質(Output)との間に、効率的に相関性を見つけられます。これにより、これこれこういう性質を持つ物質を作りたければ、こういう組成でこういう構造の物質を作ればよいと分かります。MIにおいて、従来の機械学習モデルであるランダムフォレスト、サポートベクターマシン、カーネル回帰などはよく用いられますが、深層学習の利用はまだ限定的です。

深層学習におけるニューラルネットワーク(NN)の層の数が多いほど、優れた予測性能が期待できますが、勾配消失・勾配爆発問題が起きると予測性能が低下することが知られています。勾配消失・勾配爆発問題は、活性化関数の変更や重み初期値設定などの方法で改善されてきましたが、層の深い複雑なNNにおいては依然問題になることが多いです。

そこで本論文では、物質のビッグデータを用いた深層学習でより優れた精度とロバストネスを得るために、深層学習モデルそのものを改良することに焦点を置いています。本論文では物質の性質を予測するために、ベクトルベースの物質の各特徴量をインプットとして利用する、10層から最大48層のディープNN(DNN)を構成します。その構成においては、「Individual Residual learning (IRNet) = 個別残差学習」を使用します。

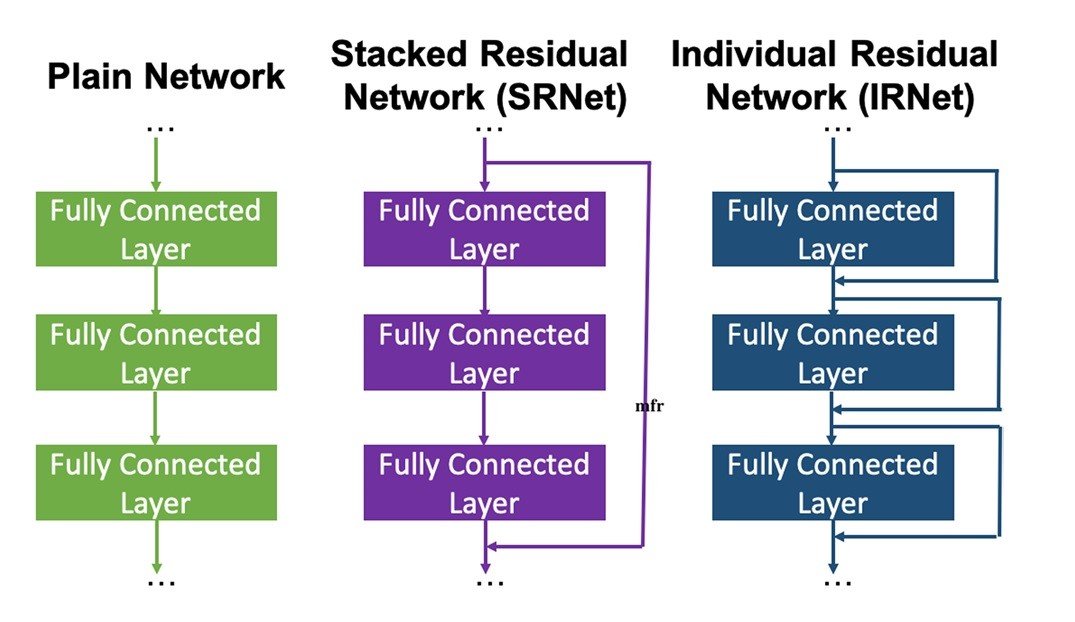

残差学習では、DNNのいくつかの層ごとにスキップコネクションを接続し、勾配消失・勾配爆発問題を回避し、学習と収束を容易にします。従来、この方法はテキストや画像の分類に使用されてきましたが、本研究では物質の性質予測に使用するベクトルベースの回帰問題に適用します。さらに、従来の残差学習ではいくつかの層ごとにスキップコネクションが配置されていましたが、本研究では、個別の各層ごとにスキップコネクションを配置することで、勾配問題のさらなる改善と予測性能のさらなる向上を目指します。

データセット

物質のインプットとしては、以下のデータベースの計算データを利用しました。

- OQMD (Open Quantum Materials Database) → 341443個の化学組成とDFT計算によって得た物性(生成エンタルピー、バンドギャップ、一原子あたりのエネルギー、単位体積あたりのエネルギーなど)を使用。さらに、OQMD-SCから435582個の化合物の組成と結晶構造を使用。

- AFLOWLIB (Automatic Flow of Materials Discovery Library) → 234299個の化合物の組成、生成エネルギー、体積、密度、一原子あたりのエネルギー、バンドギャップを使用。

- MP (Materials Project) → 83989個の無機化合物の組成、バンドギャップ、密度、体積、一原子あたりのエネルギー、外殻のエネルギー、磁化を使用。

- JARVIS (Joint Automated Repository for Various Integrated Simulations) → 19994個の化合物の組成と生成エネルギー、バンドギャップエネルギー、体積弾性率、せん断弾性率を使用。(Matminerを通してダウンロード)

- Matminer (An open source materials data mining toolkit) → 10956個の半導体化合物のバンドギャップを使用。

モデル構築

本研究では、物質の記述子をインプットとして用いて、フルコネクションのNNを使用します。フルコネクションされた各層の後には、バッチ正規化とReLU活性関数による処理を行います。

しかし、フルコネクションのNNは膨大なパラメータを含むため、各層にスキップコネクションを接続して個別残差学習を行うことで、勾配の流れを良くし、GPUメモリ内での学習・収束を容易にしました。このIRNetで、物質の特徴量をもとに、「生成エンタルピー」(その物質が生成する反応に伴い発生する熱のこと、ある条件でのその物質の生成しやすさが分かる)と呼ばれる物性値を予測しました。特徴量は、145個の化学組成に由来する情報と、126個の結晶構造などの化学的構造に由来する情報から構成されています。

データセットは9 : 1に分割し、それぞれTraining用とValidation用としました。

また、比較用の学習モデルとして、ショートカットを一切含まない「Plain network」と、現在使用されているいくつかの層ごとにスキップコネクションを配置した「SRNet(Stacked residual network)」でも実験を行いました。

最適なハイパーパラメータの決定には、「Adam」をオプティマイザーに用い、ミニバッチサイズは32、学習率は0.0001、平均絶対誤差を損失関数としました。そして、最後の回帰層には活性化関数は配置していません。

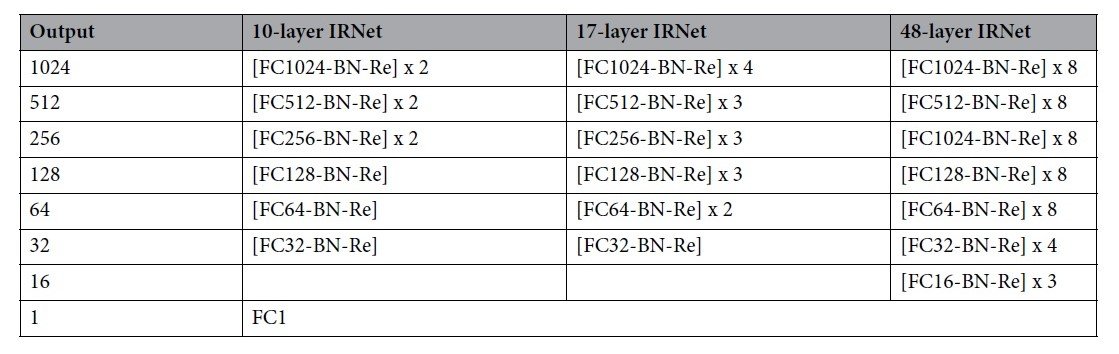

IRNetは10層、17層、48層の3種類で構築しました。その構成は以下のようになります。

(FC : Fully connected layer, BN : Batch normalization, Re : ReLU activation function)

結果・考察

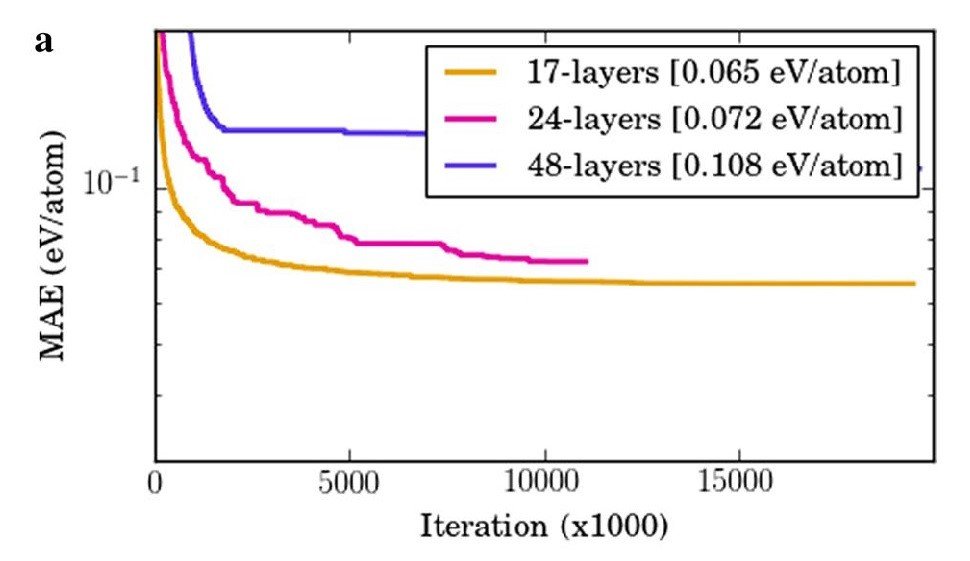

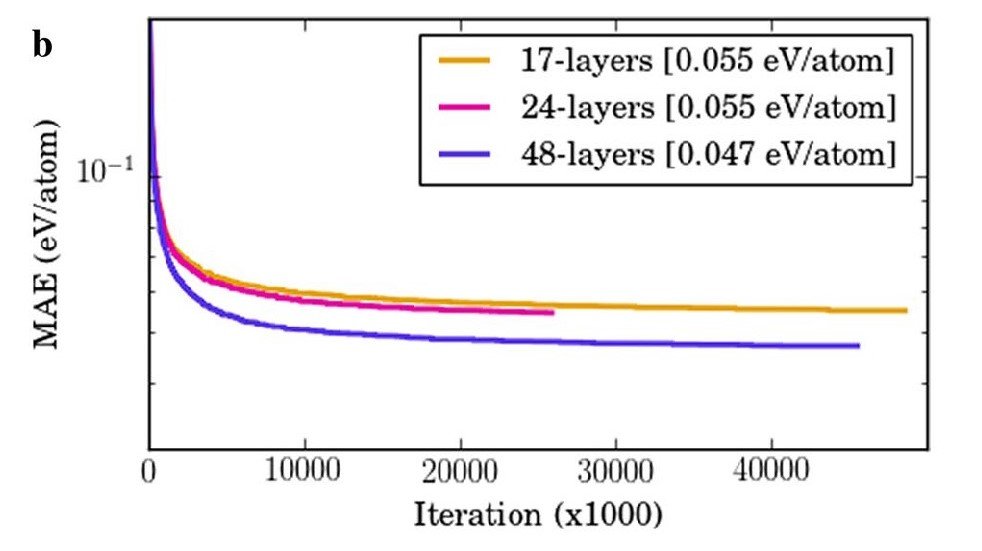

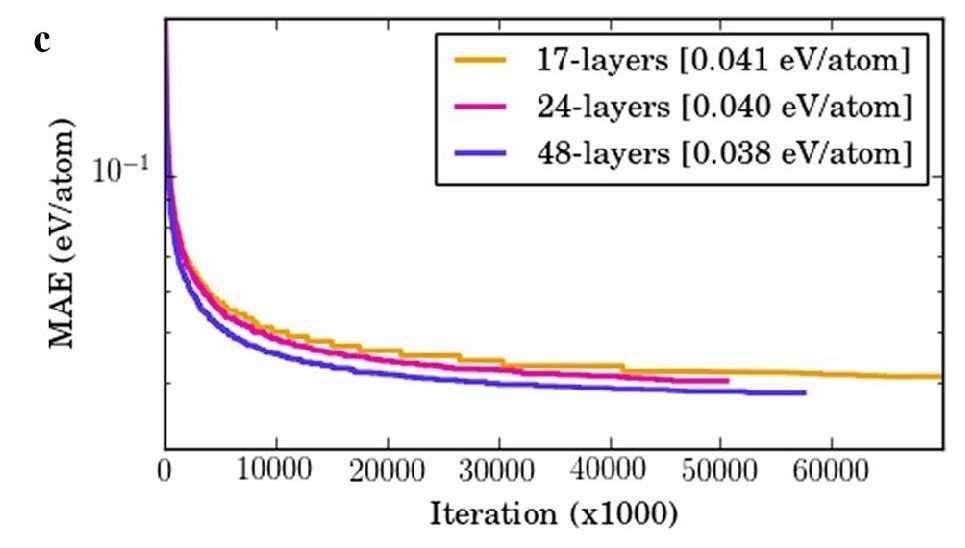

各ネットワーク(Plain, SRNet, IRNet)で物質の生成エンタルピーを予測する学習を行った結果を以下に示します。

a) Plainネットワークを使用すると、バッチ正規化を行い、ReLUを使用しているにも関わらず、層が深くなるほど平均絶対誤差(MAE)が大きくなりました。

これは勾配消失・爆発問題が影響しています。

b) しかし、SRNetではPlainとは逆に、層が深くなるほどMAEが小さくなりました。

c) さらに、IRNetではSRNetを上回る性能が確認されました。

よって、残差学習を用いて、スキップコネクションを細かく設置することで、勾配消失・勾配爆発を効果的に回避できると考えられます。

また、従来の機械学習アルゴリズム(線形回帰、SGD回帰、ElasticNet、AdaBoost、リッジ回帰、RBFSVM、決定木、ランダムフォレストなど)と予測性能を比較したところ、一番性能の良かったランダムフォレストでもMAE : 0.072 eV/atomでした。48層のIRNetは、MAE : 0.0382 eV/atomだったので、IRNetは従来の機械学習モデルよりも、予測誤差を47%以下にまで減らすことができたと言えます。

ところで、物質の性質を予測する上で、「化学組成」と「物質の化学的構造(結晶構造, etc.)」は重要な特徴量になります。そこで、様々なデータベースを使用して、「化学組成」に関する特徴量を与えた場合と、「化学的構造」に関する特徴量を与えた場合で、様々な物性値の予測性能がどう変化するかを調査しました。

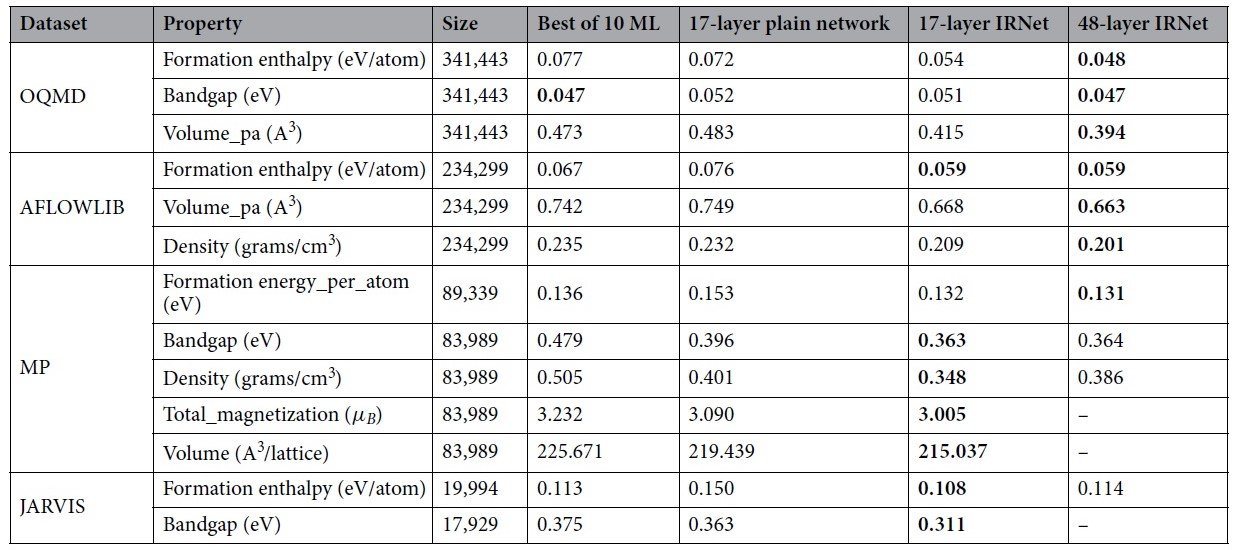

まず、特徴量が「化学組成」の場合の結果が以下です。

Plainネット、IRNet、従来の様々な機械学習手法の中で一番パフォーマンスが良かったもの、のMAEを比較しています。太字はベストパフォーマンスを示します。

どのような物性値・データセットでも、17層のIRNetは、Plainネットや従来手法よりも性能が高いため、深層学習の「強力さ」と「スキップコネクションを組み込むことの重要性」が分かります。基本的に17層よりも深い48層の方が優れていますが、データセットサイズの小さいMPやJARVISを使用した場合は、17層の方が優れた結果となりました。これは、48層だとデータ数に比べてパラメータが多すぎ、過学習してしまうためと考えられます。

よって、深層学習の層の深さを決める際には、データ数を考慮する必要があると言えます。また、より大きなビッグデータを使用することで、深層学習のポテンシャルが引き出されると言えます。

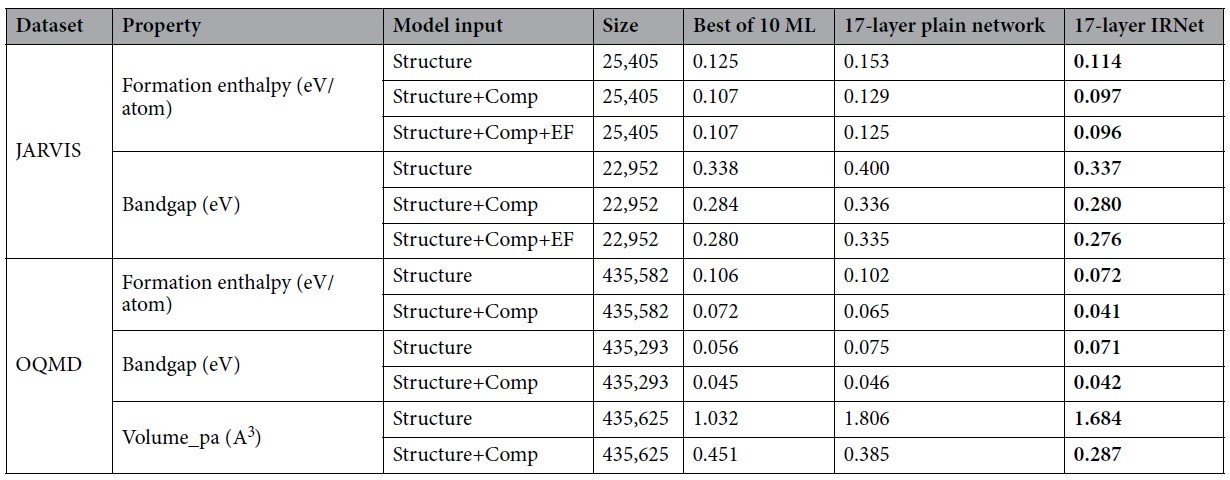

次に、特徴量が「化学的構造」と、「化学組成」+「化学的構造」の場合の結果が以下です。

Plainネット、IRNet、従来の様々な機械学習手法の中で一番パフォーマンスが良かったもの、のMAEを比較しています。太字はベストパフォーマンスを示します。EFとはその物質に使用される元素の種類に由来する特徴量だと考えられます。

化学的構造(Structure)のみだと性能はあまり良くありませんが、化学的構造に化学組成(Comp)を加えることで、劇的に性能が向上しています。

また、データセットサイズの小さいJARVISを使用した際には、Plainネットは従来法に劣っていることが分かります。しかし、IRNetでは従来法よりも性能が向上していることから、IRNetは物質の特徴量から、その物質の性能を捉える能力に長けていると考えられます。

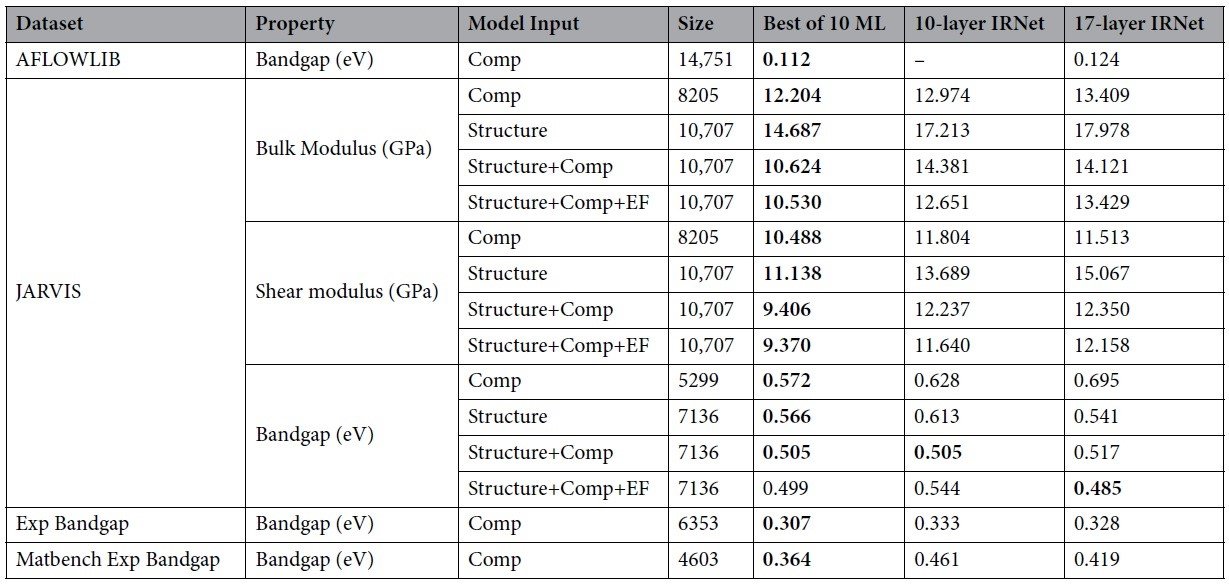

さらに、データセットサイズが上記の実験で使用したものよりもさらに小さい場合の結果を以下に示します。

データセットサイズが小さい場合には、IRNetは従来手法に性能で劣っていることが分かります

やはり、深層学習およびIRNetで物性の予測を行うには、データセットサイズが十分に大きいビッグデータが必要であると言えます。

まとめ

本論文では、深いNNにスキップコネクションを細かく設定したIRNetによって、勾配消失・爆発問題を効果的に回避する手法を提案しました。このIRNetをマテリアルズ・インフォマティクスにおける物質の物性予測に利用したところ、従来は難しかった深層学習が適用可能であることが示されました。さらにIRNetによる学習では、データセットのサイズが十分大きく、層が深いほど、物性予測の誤差が小さいことが分かりました。

今後、IRNetのような深層学習が活用されることで、より膨大な数の候補物質のスクリーニングが、より短時間で可能になると期待できます。

この記事に関するカテゴリー

.jpg)