素敵な声のあの人はどんな顔 !?MIT声から顔を予測するモデルを発表

MITが音声から人物の顔の画像を生成する新たな画像解析モデルについての論文を発表しました。実際にどのようなクオリティの予測まで可能なのでしょうか。

声から顔を予測するSpeech2faceモデルとは?

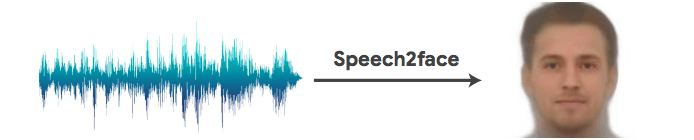

提案された「Speech2Face」は、”音声のみから顔を予測し、画像を自動生成”することができるモデルです。

発話と外観には相関関係があるといわれており、年齢、性別、口の形、顔の骨の構造など、すべてが音声に影響を与えると考えられています。また、言語、アクセント、スピードなどは国、地域、文化などのアイデンティティを反映しています。

これらの音と顔の相関関係をYoutubeなどの動画から人物が話している様子を”顔”と”声”に分けて学習データとし、声から正確に顔が予測できるようにモデルを訓練します。

話者の年齢、性別、人種などの複数の属性を短い話セグメントを通して推測し、その後話者の顔を再構築することができます。

例えば以下のような、一見関連がなさそうな音声データから外観を推測することが可能になります。

従来のモデルとSpeech2Faceの新規性

これまでも、音声データを元に性別や年齢などの人物を特定する研究や、音声を元に画像を生成する提案はいくつかありました。しかしそれらの多くは与えられた画像から適切なものを選び出すだけで、画像を生成するというアイデアは再現不可能でした。

“音声データのみ”を元に異なるデータ型である”顔の画像”を生成する研究は今回が初めてと言えます。

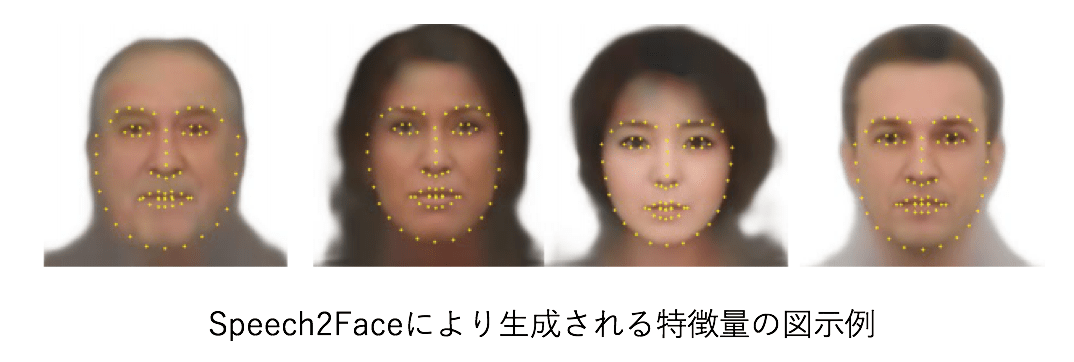

本モデルの重要なアイデアとして計算過程では、”顔全体を予測するための計算”を行う訳ではなく、下記のように”顔の各パーツの特徴量の相関係数を計算し再現する”ことで予測を行なっています。

これにより、顔の各パーツに特徴を精密に表現することができ、”似ている”人物像を作り上げることができます(パーツが似ている人を作るイメージ)。

続きを読むには

(3038文字画像9枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー