モデルの性能比較に学習はどれだけ必要か?

3つの要点

✔️ モデルの学習途中で最終的な性能を予測する手法を提案

✔️ 学習曲線の一部を用いて、モデルの最終性能を比較・ランク付けする

✔️ NASを最大100倍高速化

Learning to Rank Learning Curves

written by Martin Wistuba, Tejaswini Pedapati

(Submitted on 5 Jun 2020)

Comments: Accepted at ICML 2020

Subjects: Machine Learning (cs.LG); Computer Vision and Pattern Recognition (cs.CV); Machine Learning (stat.ML)

はじめに

NAS(ネットワークアーキテクチャ探索)やHPO(ハイパーパラメータ最適化)では、多くの異なる機械学習モデルを学習させ、最適な構造やハイパーパラメータを発見します。こうしたAutoMLの大きな課題は、モデル構造などの探索過程において、実際にモデルを学習させることに大きな計算コストがかかることです。そのため、アーキテクチャの良し悪しを高速で評価する手法の確立は、NASを始めとしたAutoMLにおける重要な研究テーマであると言えます。

本記事で紹介する論文では、性能の低いアーキテクチャの学習を早期に中断し、学習コストを削減する手法が提案されました。実験では、性能の低下を微小に抑えながらも、NASを最大100倍も高速化させられることが実証されています。

事前準備

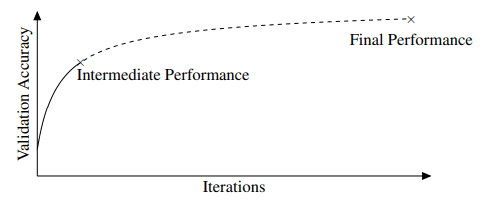

学習早期の段階でモデルの最終的な性能を予測する既存手法として、学習曲線の外挿法(補外法)が挙げられます。これは以下の図の通り、学習曲線が途中まで得られた状態(図のIntermediate Performanceの時点)から、最終的な性能を予測します。

こうした外挿法は、実際に大量の学習曲線がサンプルとなるため、大きな計算コストがかかってしまいます。論文で提案された手法であるLCRankNetでは、このようにモデルの最終的な性能を予測することはしません。

そもそも、NASのアーキテクチャ探索過程で重要となるのは、あるモデルが別のモデルと比べてどれだけ優れているかという、相対的な性能です。そのモデルがどれだけの性能を発揮するかという、絶対的な性能は必須ではありません。そのためLCRankNetでは、モデルの最終的な性能を予測して、その大小でモデルの優劣を比較するのではなく、どちらのモデルが優れているのかを直接予測します。

用語

手法の説明における表記のうち重要な点について先に述べておきます。

以下の解説では、学習曲線全体(学習が最後まで完了した場合に得られる)を$y_1,...,y_L$と表します。このとき、$y_i$はモデルの性能(分類精度など)を表し、一定間隔(数エポック毎など)で決定されます。

また、部分的な学習曲線(学習途中の場合に得られる)は、$y_1,...,y_l$として表します。

続きを読むには

(5447文字画像10枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー