最新のAI技術に大きく関わる!日本の技術力

2020年は多くのAI技術が発表され、社会実装されたものや実装のための開発が行われるなどのAIの年であったことは間違いありません。最新のAI論文は論文のままでは止まらず、世界中いろんな企業が社会還元可能性を模索し、ビジネスチャンスを狙っています。

そこで大きく社会実装で関わってくるのが「エッジ」です。多くの方がエッジAIと言う言葉を聞くことが2020年以降多くなったと思います。エッジAI型の家電を使用することでさまざまな恩恵が受けられるとなれば、生活は豊かになりますよね!

ここには大きな課題があります!クラウドであれば大きなモデルを動かすこともできるでしょう。しかしエッジで処理するとなると実装できる大きさに限界があり、さらに実装するためのコストまで大きくかかるとなると、社会実装は難しくなることが予想されます。

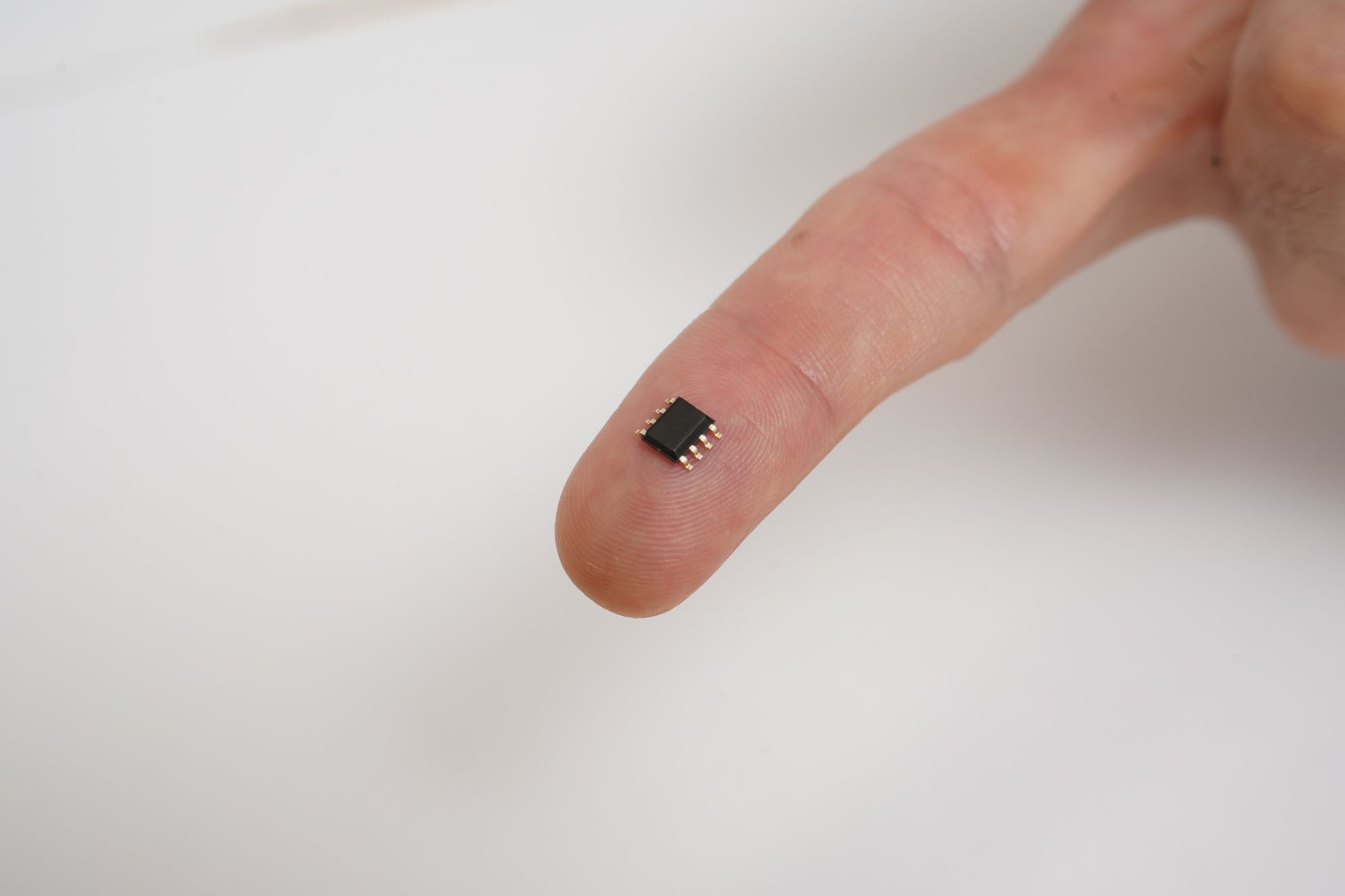

そんな中、GAFAでもできていなかったAI技術を支える指先に乗せられるほど超小型のエッジAIアルゴリズム「メモリー・セービング・ツリー(Memory Saving Tree:MST)」を開発したエッジAIスタートアップの株式会社エイシング(AISing Ltd.)代表取締役/CEO 出澤 純一さんに今回開発された技術についてお話をお聞きしました。

技術的な部分はよくわからない方はこちらを読んでいただくとわかりやすいです。

企業紹介

エイシングは2016年に設立されたAIベンチャーです。

エイシングが開発した、自社独自のAIアルゴリズムであるDBT(Deep Binary Tree)は、Deep Learningのような既存のAIアルゴリズムでは不可能だった、エッジでの学習や調整のいらない逐次学習を可能とした事で、数多くのスタートアップアワードを受賞致しました。

経済産業省の育成プログラムであるJ-Startupにおいて、日本のユニコーン企業(時価総額1,000億円以上の未上場企業)候補92社に選出いただきました。

事業フェーズとしてはこれまでに数億円の調達を完了し、国内・国外の大手企業様とのアライアンス締結を進めており、上場に向けて事業を推進しています。

エイシングはエッジAIのスペシャリストとして、産業に大きな変革をもたらします。

メモリー・セービング・ツリー(Memory Saving Tree:MST)とは

指先に乗せられるほど超省メモリー化を実現した新規の機械学習アルゴリズムとなっています。

MST搭載マイコンイメージ

これは弊社がずっと開発しているAiiR(AI in Real-time)シリーズっていう、フラッグシップ技術であるディープ・バイナリー・ツリー(Deep・Binary・Tree:DBT)という技術の特性も引き継いでいます。

ー同じ特性とはなんですか?

同じ特性というのは逐次学習可能型の機械学習というやつで、いわゆる追加学習ができます。

この学習技術に関して世界的に誰もやってないわけじゃないのですが、逐次学習不可能型機械学習とかの方が結局精度がいいので、逐次学習で成長させられるって言っても、元々の精度が全然劣るので、この分野はどちらかというと盛り上がっていなかった機械学習技術です。

ーオンライン(逐次学習可能)でわざわざ学習しなくても、そもそもオフライン(逐次学習不可能)で精度が高いから注目されて来なかったということですね。

ただ逆に我々はここの部分で弊社DBTがご評価いただけているのも、この逐次学習可能型で逐次学習不可能型とほぼ同等精度以上、どっこいどっこいぐらいの精度まで持っていく技術を開発できたことが、創業のきっかけになった技術になっています。

ただ、課題があったんですね。DBTも軽量実装なんですけど、軽量ってそれをどこの基準に置くかによって変わってきて、例えばRaspberry Pi※1とか、そのぐらいの数十MBぐらいはメモリーを使用するみたいな軽量実装は実現できてたんですよ。

※1 2012年にイギリスのラズベリーパイ財団によって、教育目的で開発されたワンボードコンピュータです。$30程度の低価格と、便利なライブラリ、そして世界中の人が多くの作例をインターネットで共有した事により、一躍IoT時代の代表的なプラットフォーム

ランダムフォレストとかだと100MBとか、下手するとディープラーニングとかは軽量な学習済みモデルでも計算パワーがかかってしまうんですよ。CPUとかの計算スペックとメモリの問題があって実装が難しいわけです。現状も難しいと思います。

それを今回の新技術というのは、今までのそういうDBTとか、弊社の逐次学習可能型機械学習が実現していた精度とほぼほぼ同等で、メモリを数100分の1から数1000の1とかのキロバイトオーダーにした!というか実現してしまったというところが、今回のやっぱり名前の通りの売りのポイントとなる技術になります。

ーキロですか!?キロ...

今回の技術で何が変わりますか、適用範囲といったところはどこですか?

今まで弊社のDBTの既存技術も他のランダムフォレストとかディープラーニングも、いわゆる計算パワーはいるし、メモリがそれなりに消費されます。なので、Raspberry Pi Zeroとかになってきちゃうと、結構実装が難しくなってきちゃうっていう問題があると思うんですね。

例えば、ディープラーニングを乗せようとしたら、メモリ条件はクリアしたけど、FPGAとかGPUとかがやっぱ必要で、数ミリ秒以内に全部計算を終えなきゃいけないので、結局ハードウェアスペックが高くなるのでAIチップを作りましょうってなるんですよ。そうなるとGAFAとか、ファーウェイなどのレベル感での技術戦略と一緒の話になっちゃうので独自で開発するのは難しいですよね。

ーランダムフォレストなら並列計算は薄いにしろ、大丈夫な気がするんですが

確かにランダムフォレストは並列計算が可能ですが、CPUで計算コストが満たせてもメモリがやっぱり数十~百MBになっちゃって、ローエンドのいわゆるスマホとかよりももっと小さいセンサーデバイスとかには結局乗らないんですよ。

ー逆にローエンドなセンサーとかのほうが高知能化したいですよね。

そういったところにも知能化したいよねってニーズあるはずなんですけど、そもそもハードウェアの制限でのせられなかったっていうところに広く乗せられるようになったというのが今回の一番のビジネス的なポイントかなと。

ー根本的にAI?弊社の範囲はもっとローエンドで乗るわけないじゃんって領域に適応範囲が広がったっていうポイントがあるんですね!

そうなんですよ。要は従来既存のハードウェアでいけちゃうっていうところです。

例えばお客さんの製品のエアコンとか加湿清浄とかそういうところに乗っているようなマイコンでも、性能的には乗せられちゃうよっていうのが今回のポイントですね。

勘違いされる方もいるかもしれませんが、小さいものに適応できるのではなくて、小さいものにも適応できるってことです。またArmさんの最も小さいCortexM0シリーズにも実装できることは確認しているのでそうなると世界の8~9割程度のものに乗っちゃうって感じですね。

例えばCPUスペックが高いものに実装すれば、計算スペックの余力を残して、実装可能なので、CPUスペックが低いものではミリ秒ぐらいで処理していたものが、こっちではもうμ秒で動きますよってことなんですよ。

ー元々高性能なものは、さらに高性能にできる可能性が出てくるってことですよね!

この技術を開発するのにどんな強みがありましたか?

弊社の強みはディープラーニング、CNNとかRNNとかのような新しいアルゴリズを作っちゃうようなガチンコのアルゴリズム研究者がいまして、加えて数学・統計、組み込み実装とか、いろんな多岐にわたる専門のプロフェッショナルが集まり、皆で複合的・多角的な研究開発をしているというのが強みですね。それがAlgorithm Development Group(ADG)っていうのを、2020年1月7に立ち上げまして、そこでもう今コロナになっちゃったんで隔週とかでみんなでWeb上に集まってああだこうだ議論をするみたいな感じで研究開発しています。原動力は圧倒的な負けず嫌いであるってことですね!

この技術を開発するのに至った経緯?

笑い話みたいで本当の話なんですけど、

3年前にDBTをエッジAIってワードがなかったので、我々はEmbeddedAI(組み込みAI)ということで売り出してたんですね。当時はディープラーニングが流行っていて、お前らの技術は何なんなんだみたいな感じだったんですよ。ある企業様に呼ばれて、「組み込みだから、256で乗るよね?」って言われたんで、「乗ります乗ります」って答えたんですよ。その時はMBだと思っていたんですよ。「256MBは余裕です!、いや違うKBだよみたいな」っていう話があってですね。「1000分の1じゃないすか!いやそれは無理ですよ」そういう話があったんですよ。

組み込み実装の技術に関してもちょっと弊社の強みなので、ちょっと悔しかったんですよね。それから、これを解決してやろうかみたいな話で、1年半ぐらいか2年弱ぐらい、研究開発をして開発に至ったって感じですね。だいたい1年から1年半ぐらいのペースで新しいアルゴリズムを結果的に作れているっていう所まで来ています。

逐次学習可能型だからこその問題点はないんですか?

ー逐次学習で勝手に学習して、性能が上がるのは嬉しいですが、逆に性能に悪い影響とかっていう部分はないんですか?

そこにも弊社は強みを持ってるんですよ!

CNNからRNNなどの全てアルゴリズム全部C言語でメモリ管理からEmbeddedも含めて考えながら、スクラッチで作り込むことができます。ただそれだけでもやっぱ駄目なんですよ。学習済みモデルを丸々従来制御と置き換えちゃうと、質問のような問題が起きちゃうわけですよね。私もそうですが元々は機械制御のプロなんですね。弊社は組み込み・AI・制御の複合領域を得意としているので、そうすると実はその質問のような問題に対する解があるんですよ。

実はそれこそがオムロンさんとかでも実際に実装して共同プレスも出させていただけている理由だと思っています。弊社のノウハウとかで、実は従来の品質保証というか従来制御の安全対策で、実装可能なんですよ。

簡単に言っちゃうと、従来の制御に+αで乗っけるノウハウがあるので、これ以上悪さしないようにできるよってことですね!良くはなるけど悪くはならない。そのノウハウを持っているということなんですよ。実はここら辺に関してはAIと機械制御の部分の複合領域って相当穴場で、ここは世界的にも誰もやってないんですね。そこに注力してきたからこその知財とか技術的な優位性というのができているって感じです。

AIは知っているが制御は知らない。制御は知っているがAIは知らないって関係性で実装してしまうためにコンフリクションを起こすんですよね。従来の制御をとりあえず、AIに任せましょうって形を取るので失敗してしまうんですよ。「制御のここの部分を」などの制御屋さんの痒い所がわかっているのでやっていけているという感じですね。

ー制御とAIと言う複合領域を網羅できているからこその優位性ってことですね

実際はそんな大したことではなくて、リテラシーの問題と世間のリテラシーとかの問題での差で、ギャップでノウハウになっているっていう認識で、時間が経てばこれが当たり前になるような気がしていますね。

MST説明動画

この記事に関するカテゴリー