ますます巧妙化するAIへの攻撃!?AIへの攻撃はあなたの知らないところで行われている!

3つの要点

✔️ AIシステムにとって脅威となるバックドア攻撃の網羅的なサーベイ論文の紹介

✔️ バックドア攻撃が仕掛けられると、自動車事故のような深刻なインシデントが発生する

✔️ 様々な攻撃手法が提案されており、これらを防ぐのは非常に難しい

Backdoor Attacks and Countermeasures on Deep Learning: A Comprehensive Review

written by Yansong Gao, Bao Gia Doan, Zhi Zhang, Siqi Ma, Jiliang Zhang, Anmin Fu, Surya Nepal, Hyoungshick Kim

(Submitted on 21 Jul 2020 (v1), last revised 2 Aug 2020 (this version, v3))

Comments: Accepted at arXiv

Subjects: Cryptography and Security (cs.CR); Computer Vision and Pattern Recognition (cs.CV); Machine Learning (cs.LG)

はじめに

今回の記事では、前回の記事に引き続き様々なバックドア攻撃について紹介していきます。バックドア攻撃とは何かがそもそもわからないと、理解することが難しいと思われますので、前回の記事を読んでから、今回の記事を読むことをお勧めいたします。

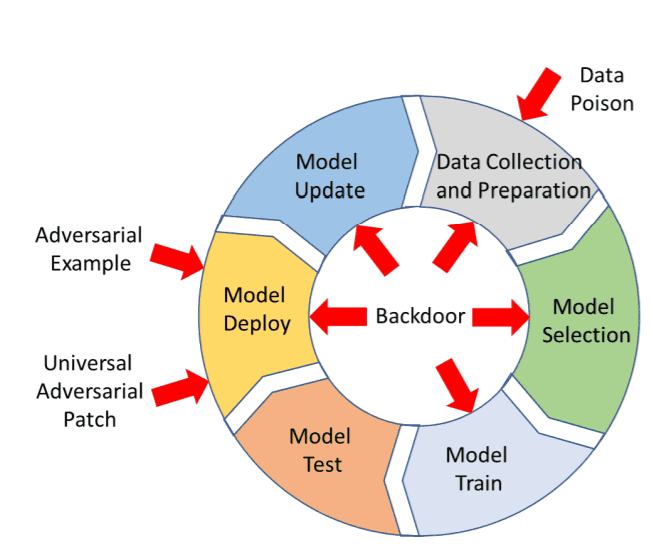

バックドア攻撃の全体像

こちらの図は、前回の記事にも載せた図です。バックドア攻撃はよく知られたAdversarial Attackとは異なり、モデルのデプロイ時にのみ攻撃を行うものではなく、データ収集や学習などにも適用される攻撃です。これを見れば、バックドア攻撃の適用範囲の広さを分かって頂けるかと思います。

バックドア攻撃には、大きく分けて以下の6つの攻撃設定があります。

A. Outsourcing Attack

B. Pretrained Attack

C. Data Collection Attack

D. Collaborative Learning Attack

E. Post-Deployment Attack

F. Code Poisoning Attack

今回の記事では、D~Fの代表的な攻撃手法を紹介します。

各攻撃の紹介

この章では、まず各攻撃の概要を説明した後に、各攻撃の代表的な手法を紹介します。

続きを読むには

(5700文字画像18枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー