fMRIと機械学習を用いて、脳活動から心の中でイメージした内容の画像化に成功

fMRIによって視覚化した人間の脳の活動を機械学習で分析することで、脳内にあるイメージを実際に再現できるかもしれないと、ATR(株式会社国際電気通信基礎技術研究所)と京都大学の研究者によって提案されました。論文の中では、実際に頭に思い浮かべたイメージを機械学習を用いて画像に出力することに成功したと報告されています。

「人工知能」で脳画像をデコードする

機械学習を使った論文が近年増加傾向にありますが、特にfMRIと組み合わせて使われる論文の増加が著しく、人間の脳活動の複雑な変化をとらえる方法として fMRI 画像に対する機械学習の応用が注目されています。PubMedの検索結果では 2005 年では 5 本だったものが この約10年で 50倍に近くにも増えています。

理由としてデータ記憶装置の低コスト化が進んで解析環境を安価に整えることが可能になっていることや、 統計解析の フリーソフトであるRが多くの機械学習のアルゴリズムを実装するようになったこと、機械学習のアルゴリズムを比較的簡便に使えるようになってきていることなどが関係していると考えられます。

2000 年代から画像データの一種である神経画像データから情報を取り出す新しい手段として機械学習の手法が用いられるようになり、60 個の具象名詞に対する fMRI データから,数千個の他の具象名詞に対する神経活動を非常に高い精度で予測することや、機械学習の応用として,SVM を用いて fMRI 画像から嘘をついている時の脳活動を捉えられる事が報告されました。

このように、単に脳のどの部分の活動が上昇しているとか変化しているという情報だけではなく、脳の複数の部位の体積や活動の変化の組み合わせをパターン認識して、その変化に潜んでいる意味を情報として取り出すことが可能になりました。このようなfMRI等により計測されるヒトの脳活動パターンを機械学習によるパターン認識で解析することで心の状態を解読する技術は「脳情報デコーディング」と呼ばれています。(最近はブレインデコーディングと呼ばれることも多いです。)

しかし、脳活動からその時に見ている物体を解読するという従来の方法では、あらかじめ脳活動を計測して機械学習モデルをトレーニングした少数の物体カテゴリーしか対象にできないという制約がありました。

一方、DNNは、脳の基本素子であるニューロンやシナプスにヒントを得て作られた人工ニューラルネットワークの一種で、近年ではヒトと同レベルの物体認識精度を達成することに成功しています。入力画像を階層的に処理することで、各階層において段階的な複雑さを有する視覚特徴が獲得されていることが知られています。

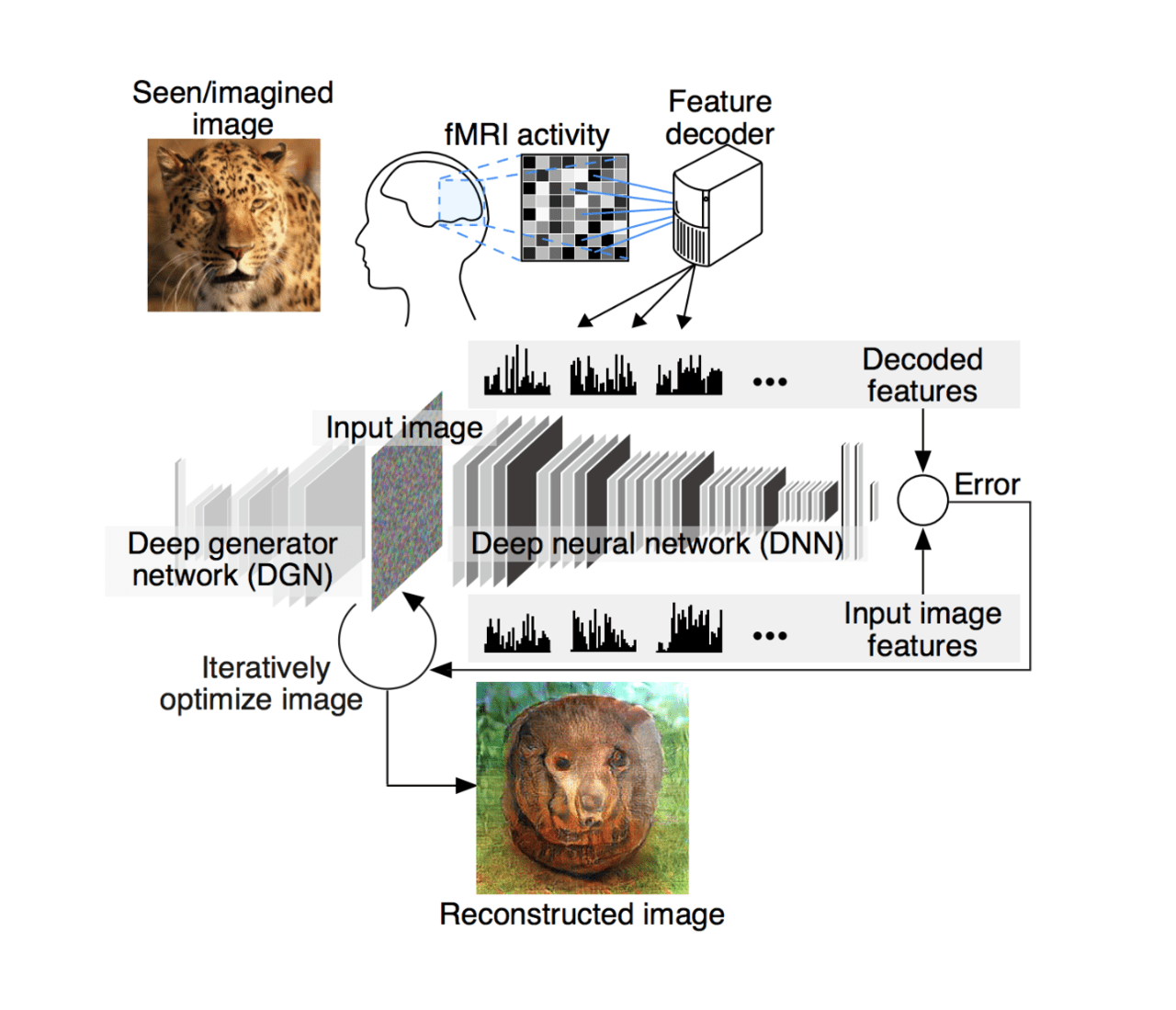

今回の研究では、脳とDNNの情報表現の類似性を利用することで、モデルの学習に用いていない物体カテゴリーを含む任意の物体カテゴリー情報を脳活動から予測する技術の開発を行ったとのことです。(図1)

図1

脳活動から、その人が見ている画像を機械学習を用いて再構成、心の中でイメージした内容の画像化に成功

まず、視覚野で神経活動が活発になっている部位をfMRIで測定し、画像の視覚特徴パターンを予測するよう学習したデコーダを用いて、得られた信号データをDNN(深層ニューラルネットワーク) の信号パターンへ変換します。DNNは入力されたデータからおおまかなイメージを予想し、その予想したイメージをDGN(深層生成ネットワーク)で最適化して画像を再構築しました。

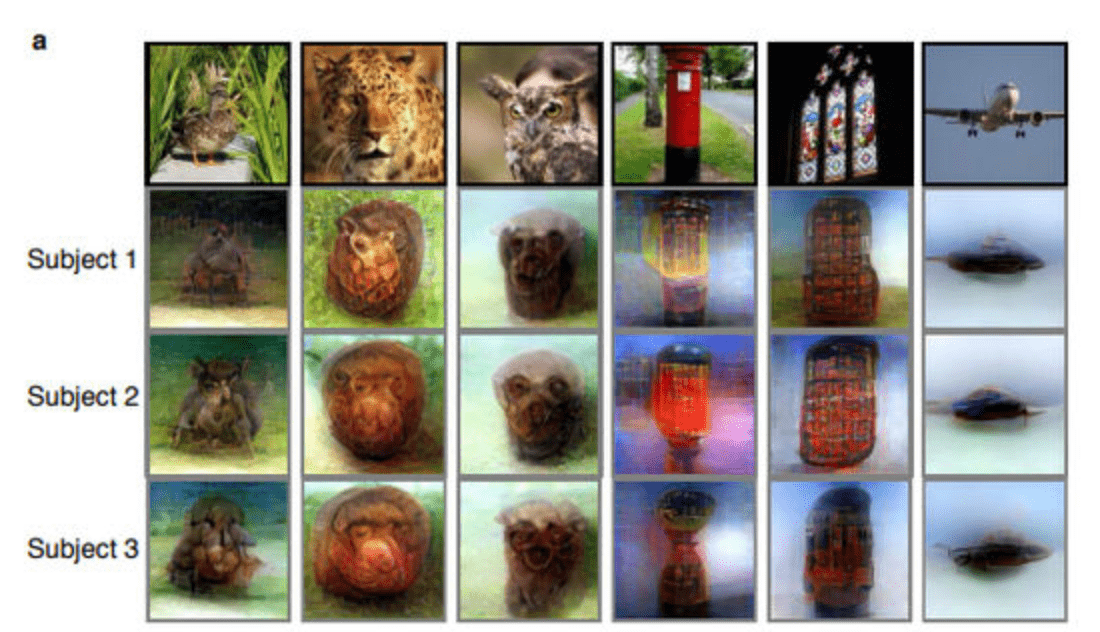

生き物や人工物が写っている写真を被験者に見せながら、脳の活動をリアルタイムで測定し、そこからイメージを再構築しますが、実際に見た画像(一番上の段)と、3人の被験者からそれぞれ出力されたイメージ(下3段)を並べたのが以下の画像。3人の被験者には大まかな違いがあるものの、同じ画像を見た場合におおむね同じようなイメージが出力できています。

生き物や人工物が写っている写真を被験者に見せながら、脳の活動をリアルタイムで測定し、そこからイメージを再構築しますが、実際に見た画像(一番上の段)と、3人の被験者からそれぞれ出力されたイメージ(下3段)を並べたのが以下の画像。3人の被験者には大まかな違いがあるものの、同じ画像を見た場合におおむね同じようなイメージが出力できています。

以下のムービーでは、左に実際に見た写真が、右には被験者の脳内活動から出力されてイメージが最適化される様子が映し出されています。

心の中のイメージも画像に転換可能

また、心の中でイメージした内容を画像化することにも成功しました。手法は上記と同じです。

実際に画像を見ている時と想像している時で、視覚的な体験としては類似性があります。脳活動にも何らかの類似性があるだろうと仮定し、実際に画像を見た時の脳活動データで機械学習プログラムに学習させた後、そのプログラムで、想像している時の脳活動パターンを解析するという方法をとりました。

上述では、見ている画像を再構成するというものでしたが、今度は一度見た画像を記憶してもらい、画像を見ていない状態から心の中でイメージする脳活動だけで画像を再構成するというものです。被験者には、関連付いている単語と画像をペアで記憶させ、その後、単語を提示し画像を想起させました。

以下の映像では、その結果を確認する事ができます。左に記憶した画像、右に再構成した画像です

同時に研究チームは、元画像と生成したイメージとの合致率が、プログラムで判断するよりも人間の目で判断したほうが高いことに気づき、複数のDNNの階層を組み合わせることにより、人間の主観的なイメージをより細かく再構成できるのではないかと期待しています。

脳×機械融合知能誕生?

人工ニューラルネットワークは脳の構造にヒントを得て作られた数理モデルですが、近年では脳のモデルとしてよりも汎用的な機械学習手法として利用されてきました。 今回の成果によって、再び、人工ニューラルネットワークが実際の脳と対応づけられることとなりそうです。 なお、現在ATRでは実際の脳と機械を融合する新たな知能システム(「脳×機械融合知能」)の実現を目指し研究を進めているとのことです。

この記事に関するカテゴリー