![[材料信息学]通过个体剩余学习成功地挖掘了深度学习的潜力!](https://aisholar.s3.ap-northeast-1.amazonaws.com/media/June2021/individual_residual_learning-min.png)

[材料信息学]通过个体剩余学习成功地挖掘了深度学习的潜力!

三个要点

✔️通过个体残留学习(IRNet)改善深度学习中的梯度消失和爆炸问题

✔️将IRNet应用于深度学习模型,根据物质的化学成分等来预测其属性。

✔️避免梯度消失/爆炸问题只是在数据量超过一定水平且层数较多时提高预测性能。

Enabling deeper learning on big data for materials informatics applications

Written by Dipendra Jha, Vishu Gupta, Logan Ward, Zijiang Yang, Christopher Wolverton, Ian Foster, Wei-keng Liao, Alok Choudhary & Ankit Agrawal

(Submitted on 19 February 2021)

Comments: Accepted by Scientific Reports (2021) 11:4244

Subjects: Artificial Intelligence (cs.AI); Machine Learning (cs.LG)

争取将深度学习应用于材料信息学...

近年来,材料信息学(MI)引起了材料研究人员的广泛关注,它利用机器学习模型来搜索具有理想性能的未知材料。在这个MI中,从实际手工实验和DFT计算中获得的数据MI使用实际人工实验获得的数据和DFT计算得出的大量计算结果作为其数据集。

这种DFT计算被称为 "基于密度泛函理论(DFT)的第一原理计算",在固态材料科学领域经常使用)。它以量子力学和量子化学为基础,通过理论计算来获得有关材料状态和属性的知识。材料科学领域以外的人可能不熟悉它,但它是在MI领域经常出现的东西,所以轻而易举地知道它是好的)

例如,通过使用机器学习,我们可以有效地找到物质的化学成分和结构(输入)与物质的属性(输出)之间的关联。这使我们能够理解,如果我们想制造一种具有这样那样性质的物质,我们应该制造一种具有这样那样成分和结构的物质。在MI中,经常使用传统的机器学习模型,如随机森林、支持向量机和核回归,但深度学习的使用仍然有限。

众所周知,在深度学习中,神经网络(NN)的层数越多,预测性能就越好,但当梯度消失/梯度爆炸问题发生时,预测性能就会下降。通过改变激活函数和设置初始权重,梯度消失和梯度爆炸的问题得到了改善,但在具有深层的复杂NN中仍然是一个问题。

因此,在本文中,我们专注于改进深度学习模型本身,以便在使用物质大数据的深度学习中获得更好的准确性和稳健性。在本文中,我们构建了一个具有10至48层的深度NN(DNN),它使用基于矢量的物质的每个特征作为输入来预测物质的属性。在其构造中,我们使用了 "个体剩余学习(IRNet)=个体剩余学习"。

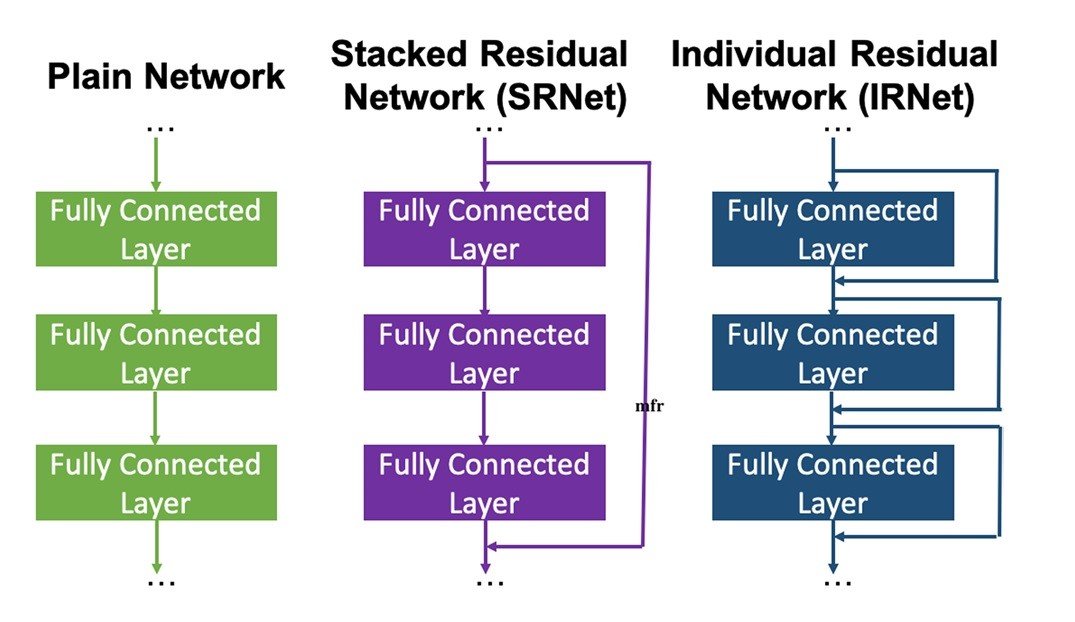

在残差学习中,跳过的连接被连接到DNN的几层中的每一层,以避免梯度消失和梯度爆炸的问题,并促进训练和收敛。传统上,这种方法被用于文本和图像分类,但在这项工作中,我们将其应用于基于向量的回归问题,用于预测材料特性。此外,传统的残差学习是在每隔几层放置跳过连接,而在这项工作中,我们在每一个单独的层放置跳过连接,以进一步改善梯度问题,进一步提高预测性能。

数据集

作为物质的输入,我们使用了以下数据库的计算数据。

- OQMD(开放量子材料数据库)→341443采用DFT计算得到的化学成分和物理性质(形成焓、带隙、每原子能量、每单位体积能量等)。此外,还使用了OQMD-SC的435582个化合物的成分和晶体结构。

- AFLOWLIB(自动流动的材料发现库)→使用234299化合物的组成、形成能量、体积、密度、每原子能量和带隙。

- MP(材料项目)→使用83989种无机化合物的组成、带隙、密度、体积、每个原子的能量、外壳的能量和磁化。

- JARVIS(各种综合模拟的联合自动化存储库)→使用19994种化合物的成分和形成能量、带隙能量、体积和剪切模量。(通过Matminer下载)

- Matminer(一个开源的材料数据挖掘工具包)→使用10956种半导体化合物的带隙。

模型建设

在这项工作中,我们使用了一个以材料描述符为输入的全连接NN。每个全连接层之后都要进行批量归一化,并用ReLU活动函数进行处理。

然而,由于全连接的NN包含大量的参数,我们将跳过的连接连接到每一层进行单独的残差学习,以改善梯度流并促进GPU内存的训练和收敛。有了这个IRNet,我们根据物质的特征预测了一种叫做 "形成焓 "的物理特性(产生该物质的反应所产生的热量,它告诉我们在一定条件下产生该物质有多容易)。这些特征值包括145条来自化学成分的信息和126条来自化学结构(如晶体结构)的信息。

数据集被分为9:1,一个用于训练,一个用于验证。

我们还试验了 "普通网络",它不包含任何捷径,以及 "SRNet(堆叠的剩余网络)",它在目前使用的几层中的每一层都放置了跳转连接,作为训练模型进行比较。

为了确定最佳超参数,我们使用 "Adam "作为优化器,迷你批次大小为32,学习率为0.0001,平均绝对误差为损失函数。而在最后一个回归层,激活函数为未放置。

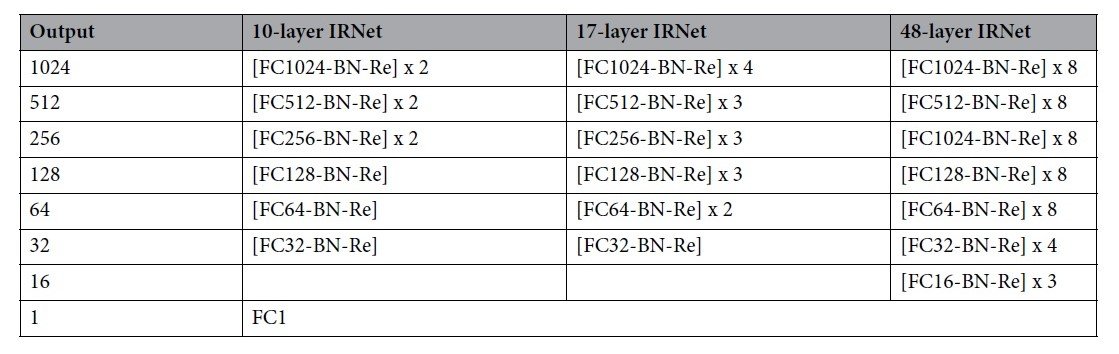

IRNet是由10层、17层和48层组成的。其配置如下。

(FC:全连接层,BN:批量归一化,Re:ReLU激活函数)

结果和讨论

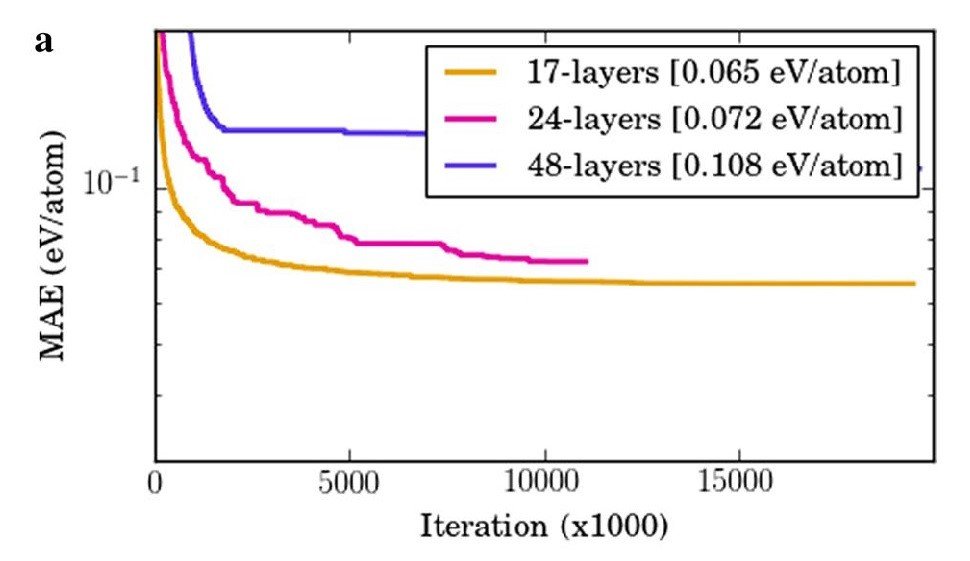

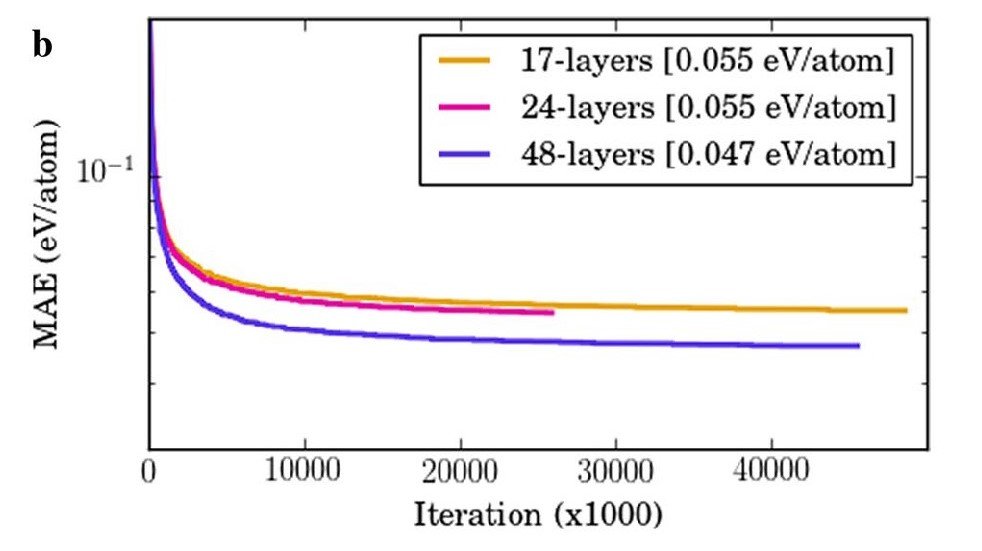

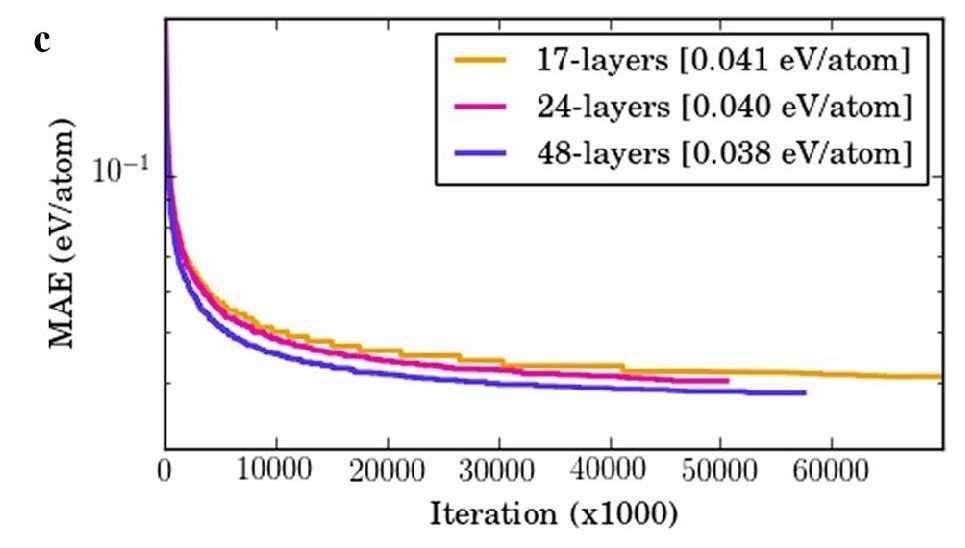

训练每个网络(Plain、SRNet和IRNet)以预测物质的形成焓的结果显示如下。

a) 使用Plain网络,尽管进行了批量归一化并使用了ReLU,但层数越深,就越是如此。平均绝对误差(MAE)变得更大。

这是由于梯度消失和爆炸问题造成的。

b) 然而,在SRNet中,与Plain相反,层越深,MAE越小。

c) 此外,IRNet在性能上优于SRNet。

因此,我们认为,通过使用残差学习和精细地放置跳过连接,可以有效地避免梯度消失和梯度爆炸。

我们还将预测性能与传统的机器学习算法(线性回归、SGD回归、ElasticNet、AdaBoost、岭回归、RBFSVM、决策树、随机森林等)进行了比较,发现性能最好的随机森林的MAE : 0.072 eV/atom。具有48层的IRNet的MAE为0.0382 eV/atom,这意味着与传统的机器学习模型相比,IRNet能够将预测误差降低到47%以下。

顺便说一下,"化学成分 "和 "化学结构(晶体结构等)"是预测材料特性的重要特征。因此,我们通过使用各种数据库研究了当与 "化学成分 "和 "化学结构 "有关的特征时,各种物理性质的预测性能如何变化。

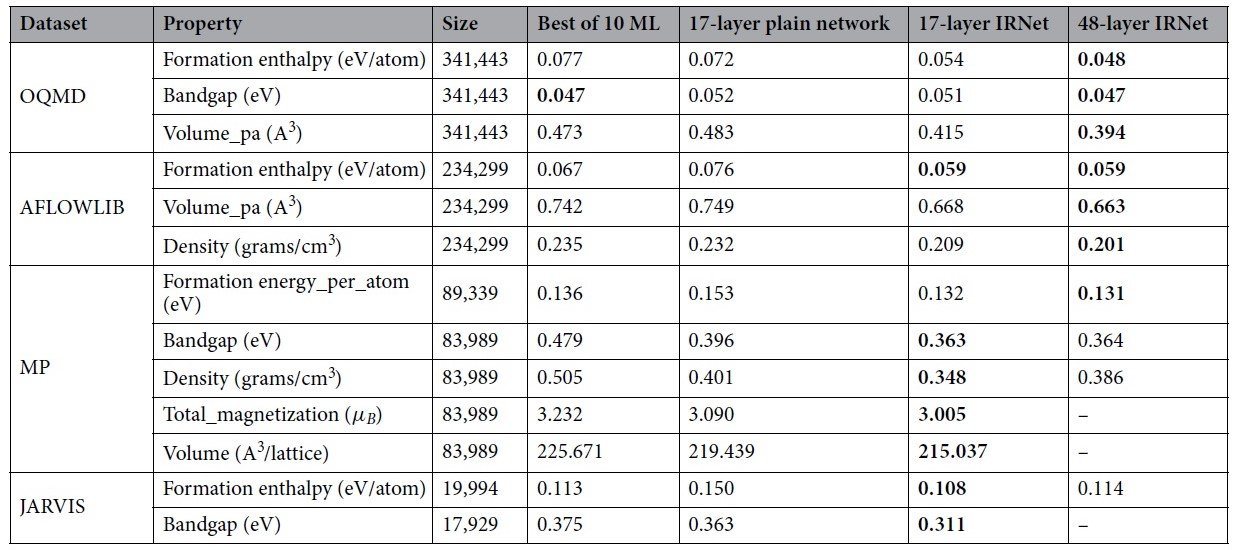

首先,特征值为 "化学成分 "的情况的结果如下。

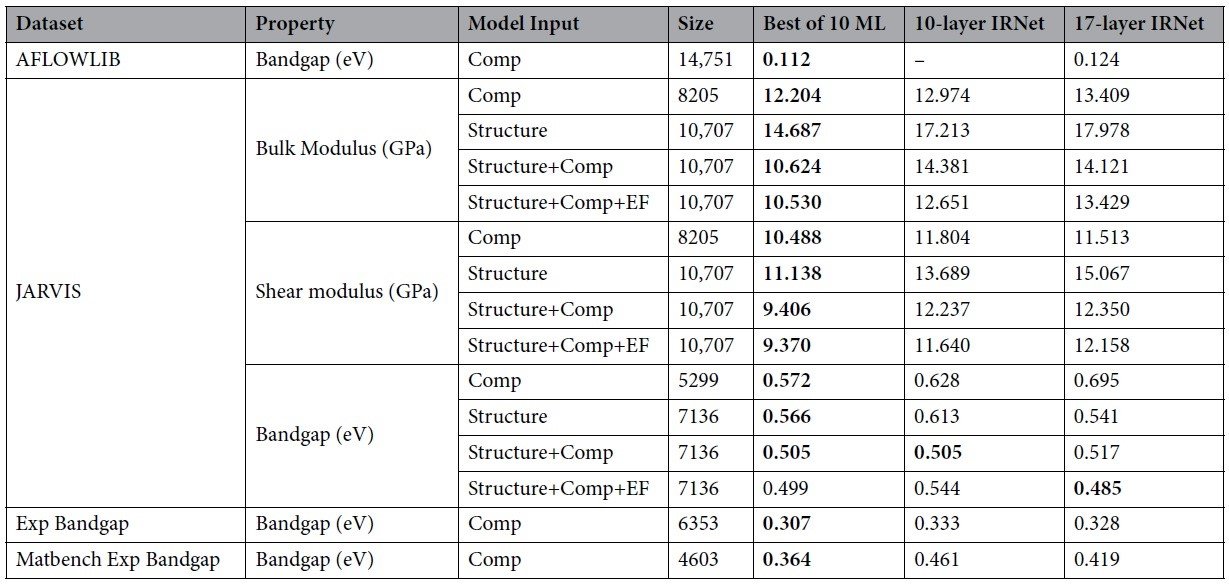

我们比较了PlainNet、IRNet和各种传统机器学习方法中表现最好的MAE。黑体字表示最佳性能。

对于任何属性值和数据集,具有17层的IRNet比PlainNet和传统方法表现更好,这显示了深度学习的 "力量 "和纳入跳过连接的重要性。基本上,较深的48层比17层好,但当使用MP和JARVIS的数据集规模较小时,17层的表现要好。这可能是因为48层与数据数量相比有太多的参数而过度训练。

因此,我们可以说,在决定深度学习层的深度时,应该考虑到数据的数量。也可以说,通过使用更大的大数据,深度学习的潜力可以被挖掘出来。

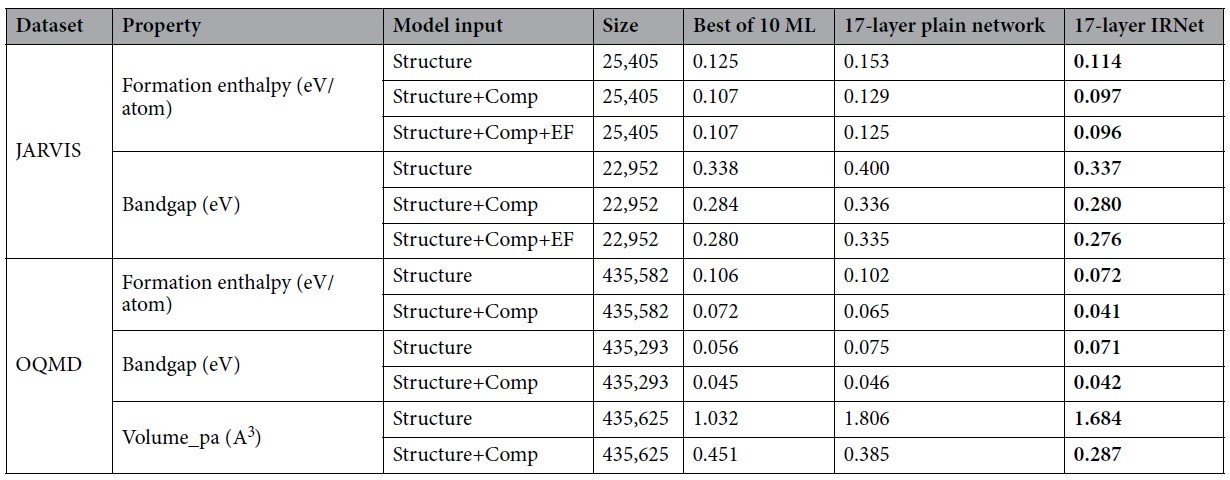

接下来,对于特征为 "化学结构 "和 "化学成分 "+"化学结构 "的情况,结果如下。

我们比较了PlainNet、IRNet和各种传统机器学习方法中表现最好的MAE。黑体表示最佳性能;EF被认为是来自材料中使用的元素类型的特征。

单独的化学结构(Structure)的性能不是很好,但在化学结构中加入化学成分(Comp)就会大大改善性能。

我们还发现,在使用数据集规模较小的JARVIS时,PlainNet比传统方法要差。然而,IRNet的性能优于传统方法,表明IRNet有更好的能力从物质的特征中捕捉其性能。

此外,我们在下面展示了数据集规模比上述实验中使用的数据集还要小时的结果。

当数据集规模较小时,我们可以看到IRNet在性能上不如传统方法。

毕竟,为了使用深度学习和IRNet来预测物理特性,我们需要有足够大的数据集规模的大数据。

摘要

在本文中,我们提出了一种方法,通过在深度NN中使用带有微调跳过连接的IRNet,有效地避免梯度消失/爆炸问题。该IRNet用于IRNet被应用于材料信息学中的材料物理性能预测,并表明深度学习可以应用于预测。此外,我们发现,数据集规模越大,层数越深,预测物理特性的误差就越小。

在未来,像IRNet这样的深度学习的使用有望使我们在更短的时间内筛选大量的候选物质成为可能。

与本文相关的类别

.jpg)

![[材料信息学]CGCNN-转移学习模型在](https://aisholar.s3.ap-northeast-1.amazonaws.com/media/September2021/物性値のデータ不足に対応3-min-520x300.png)