Facebook AI、ビデオ内の人物を3Dインタラクティブオブジェクトに変える動画合成ツールを発表。

FacebookAIが 新しい論文を発表しました。 ビデオからキャラクターを抽出し、それを、任意の新しいシーンで合成できるビデオ合成ツールを提案しています。

論文:Vid2Game: Controllable Characters Extracted from Real-World Video

リアルでダイナミックな動画合成が可能に

Facebookが 新しい動画合成ツールを発表しました。ビデオシーケンスからキャラクタの動きを学習し、ユーザが指定したモーションシーケンスに基づいてそのキャラクタの新しいビデオをレンダリングすることが可能です。

本稿ではおおきく2つのタスクがあります。

1つ目はPose2Pose(P2P)ネットワークで、制御信号の入力ストリームに基づいて、自己回帰的に特定のポーズを操作するというものです。2つ目はPose2Frame(P2F)ネットワークです。これは、抽出された入力ポーズ(キャラクター)をフォトリアリスティックに環境に組み込み、高解像度のリアルな合成ビデオフレームを生成することができます。どちらのネットワークにも、高品質のパフォーマンスを可能にする複数の新機能が含まれています。

テスト時に、ユーザは背景を任意に変更することができ、その中でキャラクタは制御シーケンスに従って動きます。

見ての通り、このリアニメーションは、ジョイスティックやキーボードからの信号など、どんな「低次元」信号でも制御でき、抽出されたキャラクターを動的な背景に配置するのに十分なロバスト性を備えていることが確認できます。

どのように機能するのか

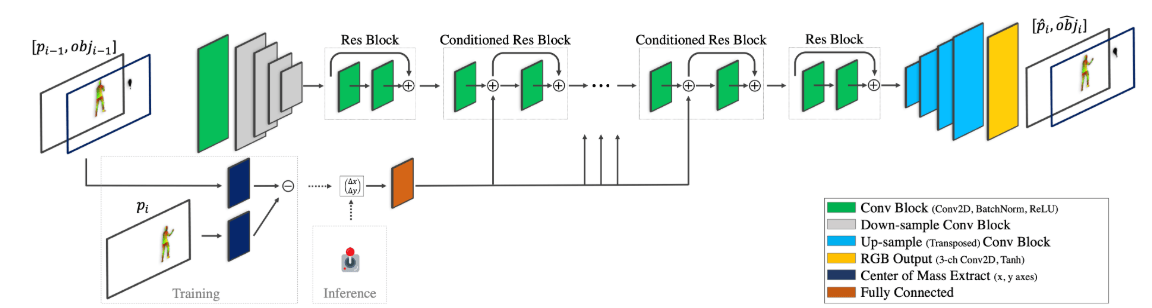

Pose2Poseネットワーク

上記が2つのネットワークの概要です。最初に、一つ以上のキャラクタを含む入力ビデオが、特定のドメイン(例えば、ダンス)のために訓練されたPose2Poseネットワークに供給されます。”キャラクター”と”それらの動き”は分離され、後者がキャラクターの重心の軌道として取られます。これらのポーズデータを使用して、Pose2Frameは、影、保持アイテム、反射などのシーン内のキャラクタに依存する変化と、キャラクタに依存しない変化を分離し、任意の背景と線形にブレンドされた一対の出力を返します。

このシステムは現実的で動的な仮想オブジェクトを生成することができるので、ゲーム分野、VR、およびARにおいて広い展望が期待できます。現実的なグラフィックを備えたビデオゲームだけではなく、リアルでパーソナライズされたゲームへの道を開くのではないでしょうか。

この記事に関するカテゴリー