RGB画像からの6次元物体検出が可能に

3つの要点

✔️ 単一のRGB画像からの6次元物体検出(3次元座標+3軸方向推定)

✔️ 蓄積された潜在表現から誤差を算出する手法

✔️ 出力はできるが、精度に置いて良好な結果は残せていない

Implicit 3D Orientation Learning for 6D Object Detection from RGB Images

written by Martin Sundermeyer, Zoltan-Csaba Marton, Maximilian Durner, Manuel Brucker, Rudolph Triebel

(Submitted on 4 Feb 2019 (v1), last revised 17 Jul 2019 (this version, v2))

Comments: Published by ECCV. Code available at: this https URL

Subjects: Computer Vision and Pattern Recognition (cs.CV)

はじめに

今回紹介するのは、6Dのラベル付き教師データなしに、6次元物体検出を高速に行う事ができるという画期的な手法です。6次元情報が分かると主にロボット操作やVRなどに有用です。論文ではアノテーションや深度センサいらずで簡単に学習、さらにリアルタイム処理を実現しており実用的な内容になっています。

移動ロボット操作やVRのような応用のためのコンピュータビジョンシステムで最も重要とされる構成要素の一つが、6次元情報です。

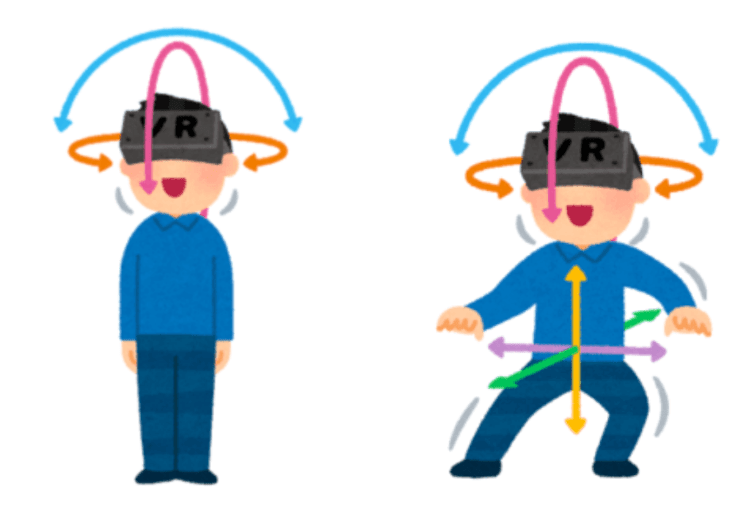

基本的な物体検出というと、画像中のxy座標だけを扱いますが、それだけではロボットが物を扱ったりできません。3次元空間の座標xyzに加え、X軸・Y軸・Z軸方向の移動という3つの動きを加えた6つの動きに対応できるのが6次元になります。6つの自由度、6DoFという風にも呼び、3次元において剛体が取り得る動きの自由度とも考えれます。この6次元情報が扱えるとロボットアーム(ロボットが物を掴む)などに有用です。

下の図で言うと左3 次元、右が6次元です。

【出典】いらすとや

続きを読むには

(2653文字画像4枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー