AIを騙せるか?持つだけで”人間”として識別されなくなるデジタル迷彩がついに開発される

情報の時代といわれる現代では、セキュリティは非常に重要です。 では、AIを騙そうとした時、AIは自分で身を守ることができるのでしょうか?先日発表された、防犯カメラなどでも見られる人物認識AIを騙す新技術が話題になっています。

参考論文 : 「Fooling automated surveillance cameras: adversarial patches to attack person detection」

持つだけで”人間”として識別されなくなるデジタル迷彩

deep learningなどによる画像認識技術が発展していく一方で、あえてニューラルネットワークに誤分類をさせる技術 ” Adversarial attacks”も同時に近年高い注目を集めています。”Adversarial attacks”とは、ニューラルネットワークモデルに意図的に誤作動を起こさせるための手法です。精度の高い識別モデルであっても入力画像を人間の目には映らない程度にわずかに変化させるだけで、モデルに誤分類させることが可能です。

ニューラルネットワークモデルの評価はテストデータを実際に適用してみることにより行いますが、それらテストデータセットの中にはわざと間違った方向へモデルを導く、すなはちモデルを騙そうとするデータは当然ながら入っていません。この評価方法は、モデルが外部から攻撃を受けないという条件であれば、大丈夫であると仮定しています。しかし、モデルを意図的に騙そうとするデータがあった場合でも、本当に大丈夫と言えるのでしょうか?

本研究では、あえてAIの誤認識を導くための画像”パッチ”をバーチャル上だけでなく、現物として作製(プリントアウト)します。つまり、このパッチを身につけていれば、監視カメラで撮られても記録に「映らなく」なります。

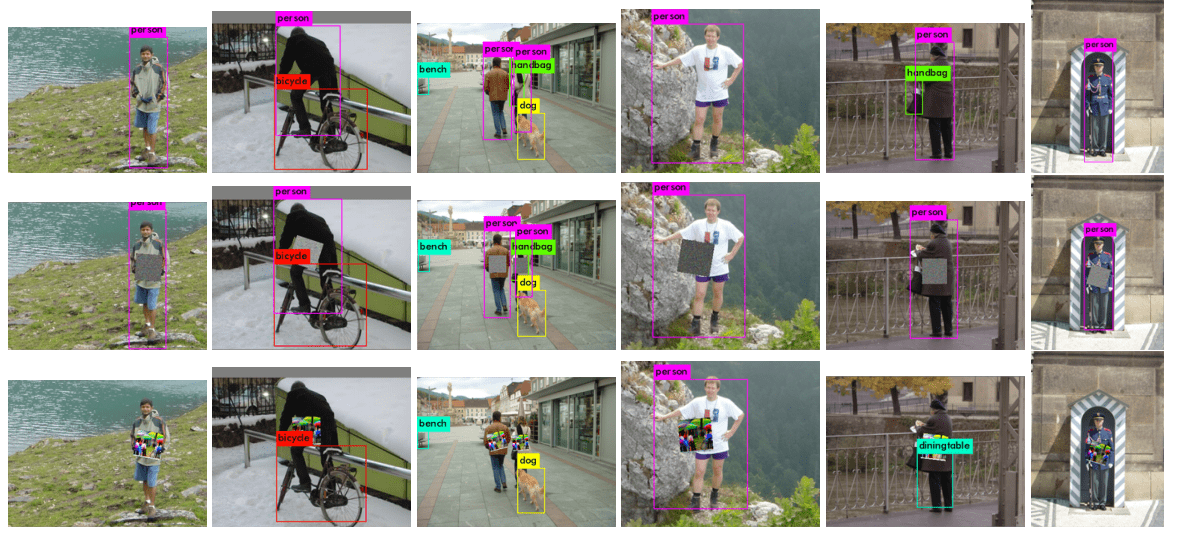

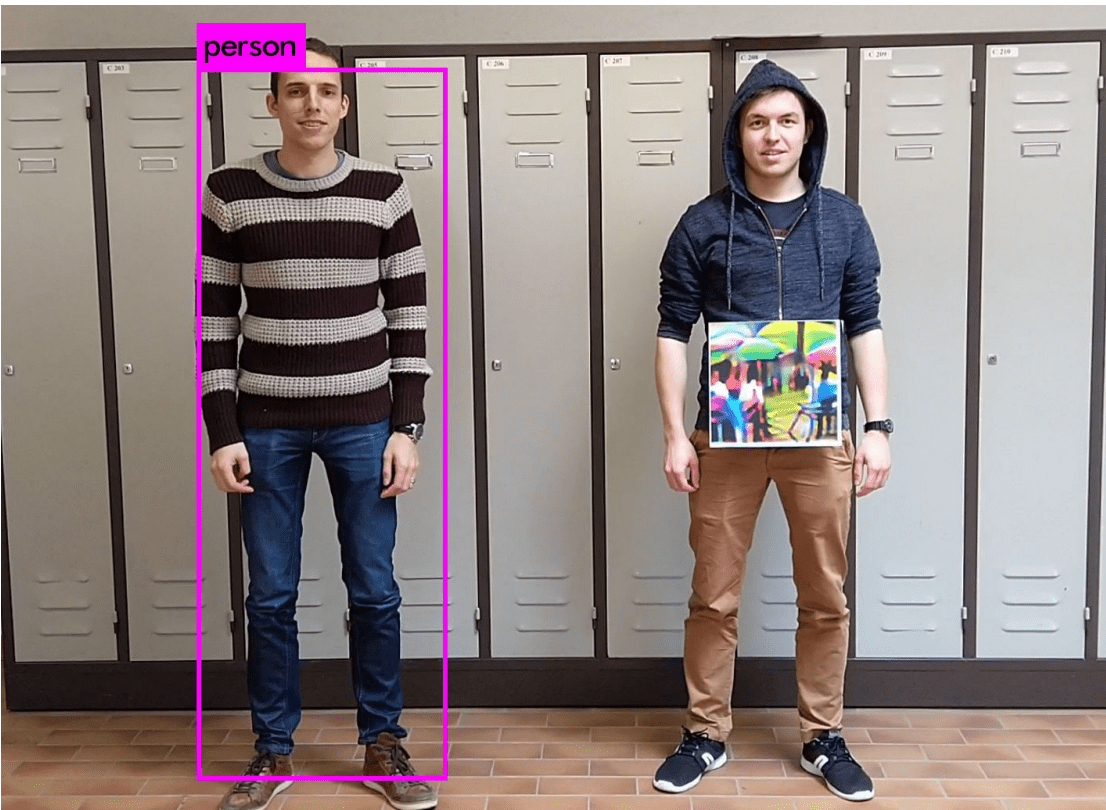

[写真1]パッチによる人物識別回避のイメージ図

[写真1]パッチによる人物識別回避のイメージ図

関連研究

これまでも、AIを妨害する試みは何度も行われきました。最初のAdversarial attacksは、入力画像のピクセル数をわずかに変化させることにより、分類モデルを騙す手法を取っていました。他にも、パッチを生成し、識別機を騙すための学習を行うモデルなどあります。

これらの研究から、人物認識機能などを持つカメラなどの識別機能をごまかすことが理論上可能であることはわかっていましたが、従来の手法で識別機能を騙すには、標識など指定された種類の物体である必要がありました。

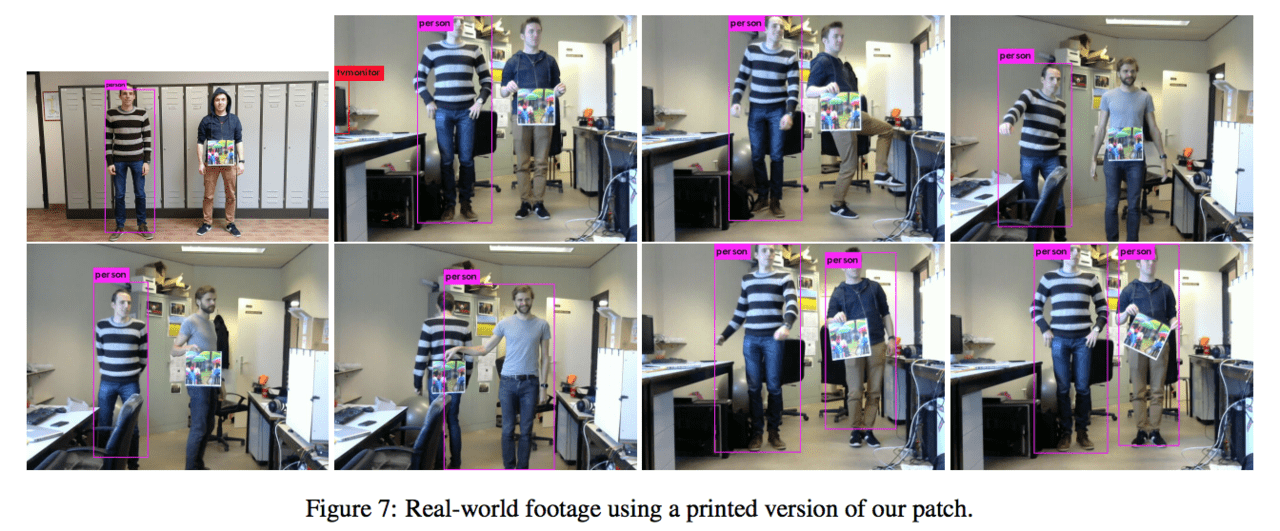

一方、この手法では、防犯カメラなどのAIによる人物識別機能を騙し、”人間を認識できなくなるパッチ”を作成することをゴールとします。さらに凄いのは、バーチャル上だけではなく、現実世界でも40cm四方にパッチをプリントアウトし、これを持つだけで、隠れ蓑として人間識別機から逃れることを実現しているところです。

複雑で何億通りもの身体的特徴を持つ”人間”を認識させなくする技術と、それをバーチャル上だけでなく現実に印刷する試みは世界でも初めてです。

[写真2]実物のパネル(パッチ)を前に置くことで人物認識を逃れる

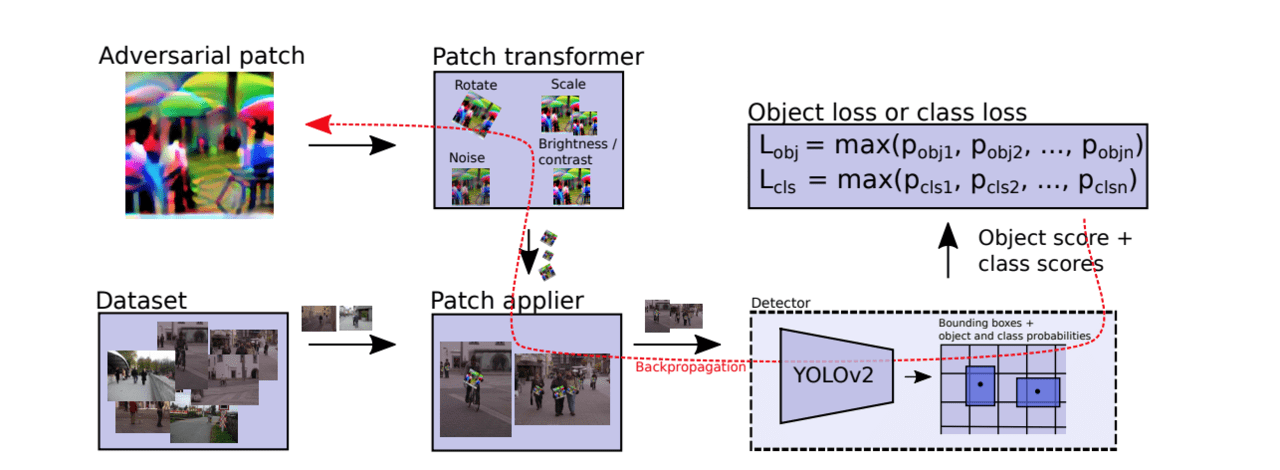

妨害パッチの製作の仕方

YOLOv2(画像認識システム)を対象とした妨害システムを設計していきます。これまでの研究から、現実世界の物体によるAIシステムの妨害(adversarial attack)が可能であることはわかっており、例えば過去の研究では、道路標識の画像に対してパッチを上乗せすることにより、AIによる画像認識を誤分類させることに成功しています。本研究ではこの手法を人間に汎用化させることを目標とします。

人間は道路標識とは異なり、非常に様々な身体的特徴を持っており、統一的にそれらの認識を妨害できるシステムを作成することが実現するにあたっての課題と言えるでしょう。人間を隠す妨害パッチを製作するにあたって、大きく3つの指標が必要になってきます。

1.人間の体を隠す妨害パッチの色合いの再現性

2.色の散らばり具合を調整することによるノイズの抑制

3.識別機によって発見される割合

1については、バーチャル上で生成された色と印刷された色には誤差や再現性の限界が生じることがあります。そのため、ピクセル数と印刷時の色合いを比較し、最小化の計算を行います。

2については、色合いの散らばりが大きくなればなるほど印刷時に誤差が発生しやすくなるため、隣り合うピクセルのRGB数の分散の最小化を計算します。

そして中でも最も重要なのが3です。ここでは、教師なしAIを用いた最適化学習により、”識別率ができるだけ低くなるような”パッチの作製を試みます。以下が3のシステムの模式図です。

モデルの概要として、まずデータセットをパッチ最適化に入力し、これを実際に識別機にかけることでその識別確率を計算し、それを最小化するため誤差逆伝播法により最適化を行います。この最適化の手順を膨大なデータセットに対して繰り返すことにより、識別機から識別を逃れることができる可能性が最大のパッチを生成することができます。

結果

生成したパッチを様々な形で持ち、YOLOv2を搭載した人物認識機能カメラに写しました。結果、上写真から分かるように8枚中6枚は、印刷された妨害パッチと共に写っている人が認識されていません。

その他にも、様々な写真に対して同様の実験を行いました。ランダムな画像に対して識別確率を検証した結果、クリーン(無加工)の状態では100[%]を誇っていたYOLOv2の識別率を、パッチによる妨害を行うことにより26.46[%]まで下げることに成功しました。

今後の展望

この種の妨害に対しては、実験と同じタイプの識別機が使われたセキュリティシステムはとても脆弱である可能性があります。著者は、この技術と洋服を組み合わせることにより、機械には識別できないTシャツを作り出すことも可能であると述べています。将来的には、この技術をより強力なものにしたいと言っており、他のニューラルネットワークへの移行も可能にしたいそう。

ライター個人の意見としては、本技術によってセキリュティの弱点が発覚することにより、さらなるAIシステムの強化が研究開発されることを期待しています。

この記事に関するカテゴリー