継続学習+言語処理の最先端!Compositionalityを用いたSequence-to-Sequenceモデル!

3つの要点

✔️ 継続学習と言語処理の融合

✔️ 構文と意味を分離することで破滅的忘却を防止

✔️ 既存手法と比較し圧倒的な性能

Compositional Language Continual Learning

written by Yuanpeng Li Liang Zhao Kenneth Church Mohamed Elhoseiny

(Submitted on 26 Sep 2019 (modified: 11 Mar 2020))

Comments: accepted by ICLR 2020 Conference

Subjects: Machine Learning (cs.LG); Machine Learning (stat.ML)

はじめに

機械学習における課題の一つとして、破滅的忘却(Catastrophic Forgetting)と呼ばれる問題があります。これは、学習済みのモデルをさらに別のデータを用いて学習させた時、過去に学習したタスクに対する性能が大きく低下してしまう現象を指します。

この破滅的忘却を回避することは継続学習(Continual Learning)の重大な目標であり、これまでもラベル予測タスクなどをはじめ研究が進んでいます(過去記事参照)。またこの継続学習においては、これまでに学習した知識を新たに学習した知識と組み合わせること(Transfer Learning)も、重要な目標となります。

本論文で提案された手法は、これまでの継続学習ではあまり焦点を当てられなかった言語学習、Sequence-to-Sequenceタスクを解決することに重点を置いています。

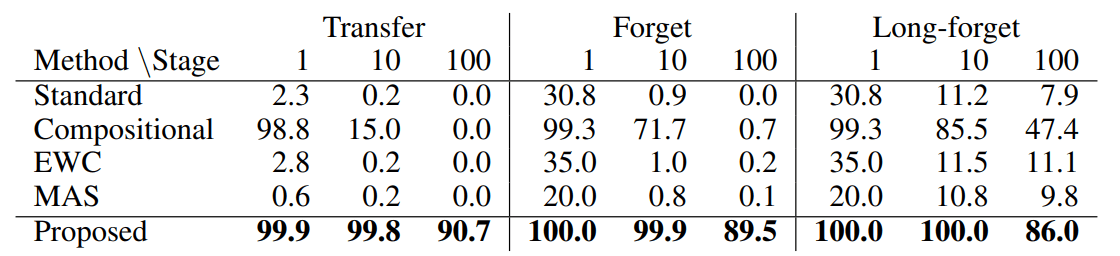

既存手法と提案手法の比較。

その成果は凄まじく、既存手法と比べ圧倒的に高い性能を誇っており、今後の継続学習+言語処理において非常に価値が高い手法であると言えます

続きを読むには

(4675文字画像49枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー