ラットの会話を深層学習で解読するシステム「DeepSqueak」が開発される

ラットは超音波発声(USV)という人間の耳を超えた周波数でお互いのコミュニケーションを図っていますが、そんなネズミの不可解なコミュニケーションを、ディープラーニングを使って理解しようというプロジェクト、「DeepSqueak」についての論文が2019年1月に発表されました。このプロジェクトでは超音波発声(UVS)を音声分析図というビジュアルなものに変換し、それを深層学習を用いて解析します。

論文:DeepSqueak: a deep learning-based system for detection and analysis of ultrasonic vocalizations

ラットによる生体実験は科学研究の象徴です。マウスやラットは生理学及び遺伝子構成がヒトに近いため、癌から糖尿病、そしてアルツハイマー病まで、あらゆる生体実験に用いられています。

そんなラットは、頭が良く、人間には聞こえない声で互いのコミュニケーションを図っています。チュウチュウという鳴き声は人間にも聞こえますが、実際には超音波発声(USV)という人間の耳を超えた周波数でやり取りをしています。そして彼らのコミュニケーションを理解することは無数の研究に有用なデータ層を加えることができます。

しかし、これまで研究者たちは、ラットがレバーを押して依存性物質を受け取るなどのあいまいな物理的手がかりに手作業で解析しようとしてきました。

また、これらの発声を検出するための既存のコンピュータプログラムも存在しますが、ノイズを拾い、データを分析するのが遅く、どちらの手法も時間がかかるだけでなく、人為的なミスや誤解を招きやすいのが課題でした。

数学的に説明するのではなくビジュアル化して表示する

そんなネズミの不可解なコミュニケーションを、ディープラーニングを使って利用して理解しようというプロジェクト「DeepSqueak」をワシントン大学の研究者らが進めていましたが、このプロジェクトについての論文が2019年1月に「Neuropsychopharmacology」に掲載されました。

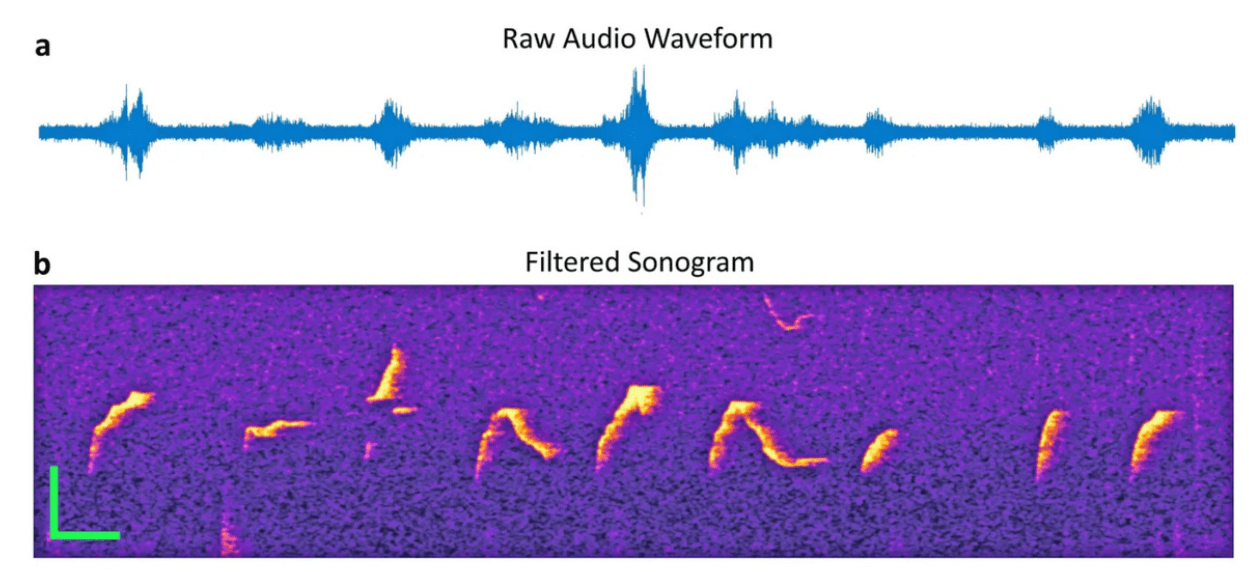

このプロジェクトは超音波発声を音声分析図というビジュアルなものに変換し、それを深層学習を用いて解析するという方法です。

自立走行車が正面の道路の視界からビジュアルデータを取り込んで査定するのと同様、「DeepSqueak」は、ラットの鳴き声の記録をソノグラム画像(音波分析図)に変換し、マシンビジョンを使用して分析します。その後、DeepSqueakは波形を元にそれぞれの音のグループをカテゴライズします。

ネズミの超音波派生(USV)には20パターンほどの発声があることを発見

Neumaier研究室の研究員であるCoffey氏によると、ラットが最大のうれしさを表現するのは、砂糖などの餌が与えられた時や仲間と戯れて遊んでいる時や仲間同士で遊んでいる時だそう。

しかし反対に、メスのラットを近くで見ると、あたかも求愛歌を歌っているかのように、発声がより複雑になるとのこと 。しかも、相手の姿が見えず匂いだけがする場合に、その複雑さはさらに増すのだそう。この所見は、オスのマウスは求愛の段階ごとに異なる歌を持っていることを示唆しています。

さらに、中毒性の薬を前にした場合は、ネガティブとポジティブな感情を持つ発声が同時に起こるそう。薬は欲しいが危険であることを察知していることが予測できます。

今回のプロジェクト「DeepSqueak」の研究で開発されたツールはこれらの鳴き声を、最大で40倍速く分析できるようになり、より繊細に解析できるようになります。DeepSqueakによってげっ歯類の行動や動機についての理解を深めることで、それぞれの研究において、人間に対するさまざまな治療法の研究に役立てもらうことを願っていると、開発者たちは述べています。

また、この研究は発声研究の分野に取り組む人にとっても役立つかもしれません。

このDeepSqueakは、Coffey氏のGitHubアカウントから無料でダウンロードすることができるので気になる方は試してみて下さい。

この記事に関するカテゴリー