BCI分野におけるディープラーニングの活用

目次

(1) BCIの歴史

(2) 医療分野で先行

(3) BCI×AI

(4) ニューラルネットワークを使った脳波の読み方

人間が生きることは、さまざまな信号や情報を最適な形に翻訳することの連続です。音を聞くことは空気中の振動を音声に変換することで可能になり、目で見ることは電磁波を映像に変換することで可能になります。

そんな人間にかかわるさまざまな信号の中でも、ここ数年、特に注目を集めているのが脳波を受信・解析して活用しようという「脳コンピューターインターフェース(BCI)」の領域です。

ブレイン・マシン・インターフェース(Brain-machine Interface : BMI)は、脳波等の検出・あるいは逆に脳への刺激などといった手法により、脳とコンピュータなどとのインタフェースをとる機器等の総称である。接続先がコンピュータである場合にはブレイン・コンピュータ・インタフェース(Brain-computer Interface : BCI)とも呼ばれる。

(BMI)は脳波などの脳活動を利用して機械を操作したり、カメラ映像などを脳への直接刺激によって感覚器を介さずに入力することを可能にする。 信号源および操作対象である”脳”と”機械”を繋ぐ存在、脳波を読み取る脳波センサーや脳波を解析するプログラムなどを総称してBMIと呼ぶ。脳信号の読み取りでは、脳の神経ネットワークに流れる微弱な電流から出る脳波や脳活動による血流量変化など、脳の活動に伴う信号を検知・解析する事によって人の思念を読み取る

BCIの歴史

医療界では、1960年代からすでにBCIの研究が行われて、初期の段階では、電極を埋め込んだヘッドセットを頭部に装着するといった大掛かりなものでした。そこから、10年程度の時を経て普及したのが、脳内チップでした。70年代後半になると「視覚障害の人に視感覚を与える治療」に活用されはじめ、80年代後半では、パーキンソン病やうつ病、などにも効果が期待できるBCIが報告されるようになります。外部スイッチによりチップが脳に電気刺激を与える方法は、現在では保険適用の一般的な治療として知られ、日本においてもDBSの治療を行なっている施設は30施設以上存在します。

さらに、BCIの進化は続き2000年代初頭には、DBSに代表されるような「外部から脳内のチップに電気刺激を与える」以外の技術が登場しました。

アメリカのサイバーキネティックス社は、2004年ごろからブラウン大学との共同で臨床試験をスタートし、四肢麻痺の患者が考えるだけで「メールボックスの開封」、「照明のON/OFF」、「ロボットアームの動作」を行えることを確認しました。2012年にも同様の試験が行われ、患者の脳波をキャッチしたロボットアームがジュースを口に運び、世界中にインパクトを与えました。

開発は医療分野で先行

BCIが現在多く適用されているのは、医療分野です。

脳と機械の連動については、医療の世界ではBMI(Brain-Machine Interface)として早い段階から研究されていて、四肢麻痺患者の運動・リハビリ支援、ALS(筋萎縮性側索硬化症)患者の意志伝達手段に使用する事が目的です。※BCIは、このBMIとほぼ同義で扱われる場合が多い。

コンピューターとつながった義足などを思考で制御することは、体の一部が麻痺して動かなくなってしまった人々にとって大きな希望となり得ます。例えば2016年に10億円の資金を調達したVR企業のMindMazeでは、体の一部が麻痺してしまった人が筋肉を正しく制御する方法を再び学習できるようにするためのVRアプリケーションを開発しています。アプリケーション上ではユーザーの思考をVR空間上のアバターの動作に変換することで、VR空間のアバターを自在に操りながら実際の体の動かし方を取り戻していく、というアプローチが研究されています。

また、米国のDARPA(国防高等研究計画局)は1970年代から熱心にBMIを研究しています。2016年には同局が支援するピッツバーグ大学の研究チームが四肢麻痺の患者の脳に極小チップを埋め込み、ケーブルを介してロボットアームと接続する実験を行いました。実験は成功し、患者はロボットアームの指先にある触覚センサーを通じて触感を感知する事ができました。

BCI×AI

2017年に入り、再びBCIが脚光を浴びるようになってきました。

2017年3月にイーロン・マスクはコンピューターと脳をつなぐための神経系UI開発企業「Neuralink」を設立しました。登記上は「医療研究」の会社となっており、CIにおける医薬品の改善やデバイスの接続方法などの課題に取り組んでいますが、真の目的は人類とAIの融合にある事を明らかにし、思考をコンピュータにダウンロードしたり、コンピュータから思考をアップロードしたりできるようにして、人間の脳を拡張させるこ事を目指します。そのおよそ1カ月後にはFacebookが開発者会議「F8」で、脳波による無言タイピングに対応していく計画を発表します。

またBrain Treeの創業者Bryan Johnsonも、Kernelと共にBCIの分野に参入しています。同社は、神経科学者と技術者によってできたチームで、脳を探索することが今世紀の最も緊急かつ重要な課題であると考えます。kernelの短期的な目標は、脳の記憶をコンピュータチップに変換することですが現在すでに約80%の成功を収めていると主張しています。

奇しくもテクノロジー業界のリーダーたちが足並みを揃える格好となったこともあり、一部ではBCIが人工知能(AI)に続くキーテクノロジーになるのではないかと注目されていますが、そんな中、このBCIとディープラーニングを用いることで、脳波の変化を読み取る事で人間が「何をしようとしているか?」や「何を考えているか?」を予測しようという試みが複数存在します。

ニューラルネットワークを使った脳波の読み方

BCIはデータ解析技術を集めて初めて達成されるもので、まず、データをセンサーにより正確に取得するという作業からになります。そして集められたデータはブラインド信号源分離などによって解析され、機械学習の手法によってデバイスへの動作命令を出力します。

ディープラーニング関係の情報をまとめるブログFloydHubが、実際に脳波を読み取る方法をザックリ解説しているので紹介していきます。https://blog.floydhub.com/reading-minds-with-deep-learning/

脳波を読み取るには脳波に関するデータが必要ということで、12人分の手作業時の脳波測定値を記録したデータセットが使用されています。

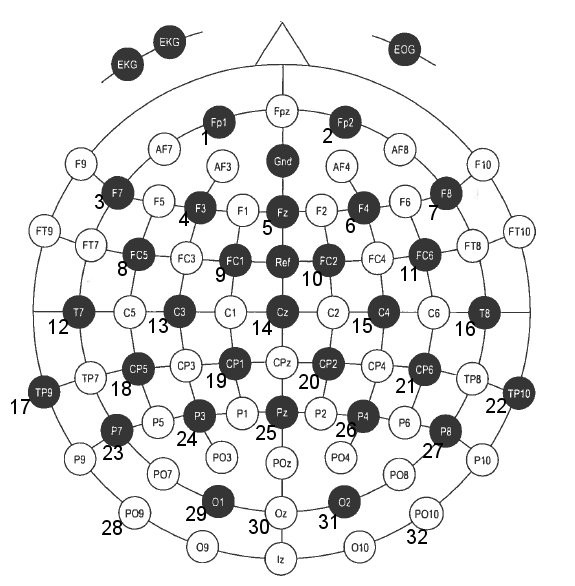

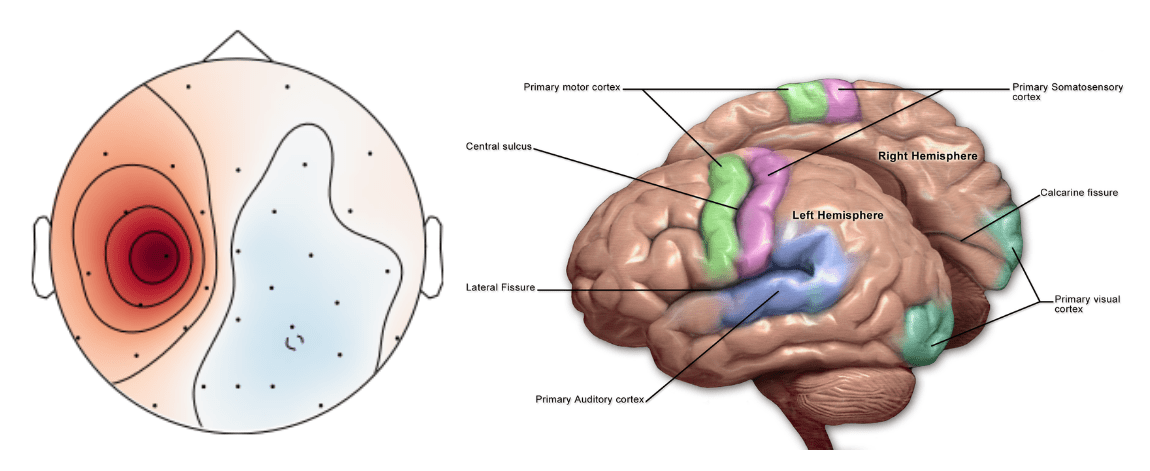

このデータセットでは脳波が上記の脳波図における32カ所から読み取られており、被験者は「光が点灯するとオブジェクトを持ち上げる動作を開始する」ように指示されており、その後下記の5つの動作を行います。

「オブジェクトに触れる」

「指をオブジェクト上に置く」

「オブジェクトを持ち上げる」

「オブジェクトを置く」

「オブジェクトを離す」

データーの調査

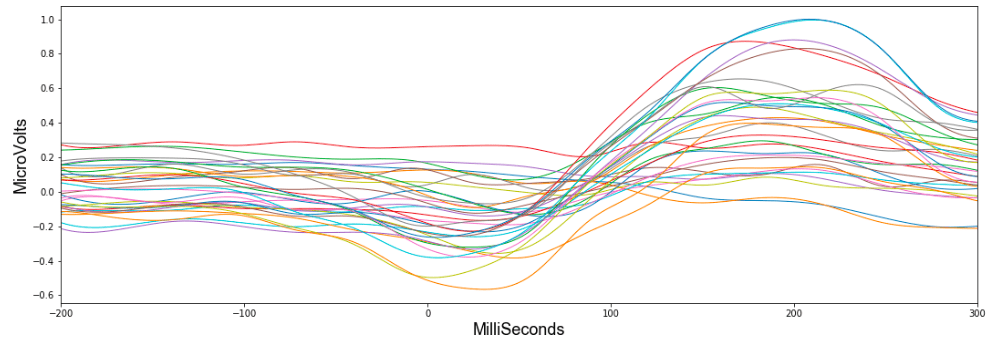

この中の、被験者が「光が点灯するとオブジェクトを持ち上げる動作を開始する」瞬間の脳波の変化を示したのが以下のグラフです。

32本の線はそれぞれ脳波図における32カ所の測定位置で測定された値を示しており、手を動かし始める200ミリ秒前から動かし始めてからの300ミリ秒後までの間に、脳波測定値の32個の値がどのように変化したかを示しています。

そして、上記の32個の値すべてを平均すると、下記のように一定のパターンを見つける事ができます。

しかし、他の5つの動作(オブジェクトに触れる・指をオブジェクト上に置く・オブジェクトを持ち上げる・オブジェクトを置く・オブジェクトを離す)においては、脳波の変化パターンがあまり明確ではなく、脳波形だけを見て「実際にどのような動作が実行されたか」を予測することは困難だったそうです。

しかし、これとは別に、PythonライブラリのMNE(EEG結果の解析用に構築されたもの)を使用した場合、オブジェクトに触れたり持ち上げたりする瞬間に、「脳波の変化が脳のどの部位で起きているのか?」を視覚化することが可能だそう。

左、持ち上げの間に被験者の脳が最も活発であった場所。 右:人間の脳の図、緑色の領域は運動野を表します。

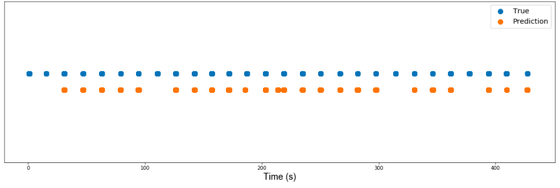

これらのデータをディープラーニング向けライブラリのPyTorchを用いて畳み込みニューラルネットワークに学習させたところ、AUCが94%となる精度のモデルを作ることに成功しました。これをわかりやすく図で示したのが以下の画像です。データセットでは被験者が28回オブジェクトを持ち上げるのですが、実際に被験者が動作を実行したときを青点で示し、モデルが動作が実行されたと予測したタイミングをオレンジ点で示しています。これによると、モデルは28回の動作のうち23回を正しく予測することに成功しています。

なお、神経科学に関心を持つ人がディープラーニングを用いて脳波から人間の実際の動作を特定しようとしても、用いられるニューラルネットワークが一体どのように動作しているのかがわからないという問題がありますが、FloydHubは「ディープラーニングがどのようなに動作しているのかを常に知っておく必要はない」と述べ、これは「物理法則を知る前にホイールを使ったり、電子について知る前に電気を使うことと同じだ」と述べます。

FloydHubが作成したモデルは以下のGitHubページ上でも公開されているので、データとモデルで遊びたい場合はのぞいてみて下さい

https://github.com/SamLynnEvans/EEG-grasp-and-lift

この記事に関するカテゴリー