Adversarial Attackへの防御の鍵は活性化関数?新たな活性化関数k-WTAの登場!

3つの要点

✔️活性化関数をk-WTAと呼ばれるものに変更するだけでAdversarial Attackに強くなることを示した

✔️ k-WTAは入力に対して不連続であるため、ネットワークを騙す摂動が計算しにくい

✔️パラメータ空間においては、不連続性が小さいため、ネットワークの学習は従来通り可能

ENHANCING ADVERSARIAL DEFENSE BY k-WINNERS- TAKE-ALL

written by Chang Xiao, Peilin Zhong, Changxi Zheng

(Submitted on 26 Sep 2019 (modified: 11 Mar 2020))

Comments: accepted by ICLR 2020 Conference

Subjects: Machine Learning (cs.LG); Machine Learning (stat.ML)

はじめに

近年、深層学習モデルは様々な場面において使用されており、これからますます活発に使用されるようになると予想されています。

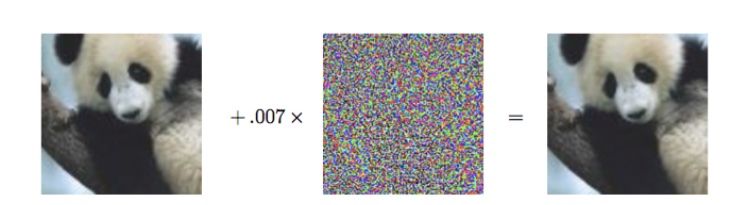

高精度で知られる深層学習モデルですが、入力に小さな摂動を加えるだけで深層学習モデルを騙すことが出来ることが知られています。この攻撃はAdversarial Attackと呼ばれており、活発に研究されている分野の一つです。

上記の左右の二枚の画像は人間にはパンダにしか見えませんが、小さな摂動を加えることで、右の画像を深層学習モデルはテナガザルと誤認識してしまいます。このようにAdversarial Attackは人間にはわからない程度の摂動でモデルを騙すことが可能です。

もう少し具体的な攻撃例として、自動運転車の画像認識システムに対して、攻撃が行われたとします。自動運転の画像認識システムは人や道路を認識しながら走行しています。この攻撃によって、道路を人と誤認識させることも可能です。そうなった場合、自動運転車は非常に危険な走行を行うことが予想されます。この例のように、AIモデルが世の中で広く使用されるようになった時に、Adversarial Attackの脅威は非常に大きくなります。そのため、研究者たちはこの攻撃に対してロバストなモデルを構築しようと様々な研究を行っています。

今回紹介する研究は活性化関数をk-WTAと呼ばれるものに変更するだけでAdversarial Attackに強いモデルを作ることが出来ることを示した研究です。k-WTAは入力に対して不連続であるため、攻撃者はモデルを騙す摂動を計算することが困難となります。

続きを読むには

(4063文字画像15枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー