AIシステムへの現実的な攻撃手法?効率的かつ高精度な攻撃手法ZO-NGDの登場!

3つの要点

✔️その1 AIシステムの内部パラメータがわからない状況(black-box)でも、高精度にAIシステムを騙すことが可能

✔️その2 2次の微分情報を推定する手法(ZO-NGD)により、従来手法より効率よくadversarial exampleを生成可能

✔️その3 ZO-NGDによって生成したadversarial exampleは他のモデルにも転用可能

Towards Query-Efficient Black-Box Adversary with Zeroth-Order Natural Gradient Descent

written by Pu Zhao, Pin-Yu Chen, Siyue Wang, Xue Lin

(Submitted on 18 Feb 2020)

Comments: accepted by AAAI 2020

Subjects: Machine Learning (cs.LG); Cryptography and Security (cs.CR); Computer Vision and Pattern Recognition (cs.CV); Machine Learning (stat.ML)

はじめに

近年、深層学習の台頭により画像認識をはじめ、自然言語処理や音声処理の性能は大幅に向上しました。これからますます、深層学習を用いたサービスが世の中で使用されるようになるでしょう。

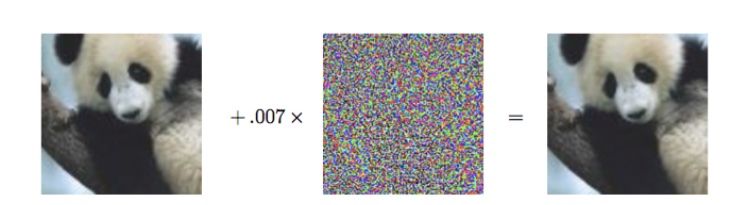

しかし、真に深層学習モデルを適用していくにはいくつかの課題が存在します。その中の一つに、深層学習モデルは簡単に騙せるという課題があり、これに関する研究はホットな分野となっています。この深層学習モデルを騙す攻撃のことをAdversarial attackと呼びます。以下の図はこの攻撃を表したものです。

上記の図には左右に二枚の画像があり、そのどちらも人間の目にはパンダにしか見えません。しかし、左の画像に真ん中のノイズのようなものを加えた右の画像に対して、モデルはテナガザルだと誤認識してしまいます。このように、人間にはわからない微小な変化を加えることで、モデルを騙すことができます。

このAdversarial attackには二つの設定があります。一つは攻撃対象のAIシステムの内部パラメータが全て分かっているWhite boxという設定、一つはAIシステムの内部パラメータにはアクセスできないというBlack boxという設定です。

Black boxの例として、Google Cloud Vision APIなどが挙げられます。これらに画像を入力すると、情報として返ってくるのは、画像認識の予測結果(予測分布)だけです。現実世界では、このような場合が多く、Black boxの設定はAIシステムへの攻撃の現実的な設定です。

今回紹介する研究では、上述したBlack boxの設定において、高精度かつ高効率に攻撃を行う手法ZO-NGDを提案しています。高効率に攻撃を行えるというのは、なるべく少ないクエリで攻撃を行えるということです。これは、APIの使用費または相手に気づかれにくいという点において、非常に重要な要素となります。

続きを読むには

(4486文字画像13枚)AI-SCHOLARに

登録いただく必要があります。

この記事に関するカテゴリー