设置限制特征的门,使一个过滤器负责一类

三个要点

✔️控制特定类别的过滤器。

✔️在不损失精度的情况下,提高过滤器的可解释性。

✔️适用于物体位置和敌对样品。

Training Interpretable Convolutional Neural Networks by Differentiating Class-specific Filters

written by Haoyu Liang, Zhihao Ouyang, Yuyuan Zeng, Hang Su, Zihao He, Shu-Tao Xia, Jun Zhu, Bo Zhang

(Submitted on 16 Jul 2020)

Comments: Accepted at arXiv

Subjects: Computer Vision and Pattern Recognition (cs.CV); Machine Learning (cs.LG)

Paper Coming soon COMM Code

介绍

卷积神经网络(CNN)在视觉任务中表现出很多高准确度。然而,即使是如此强大的CNN,也很难解释。如果我们讨论人类和人工智能在解释上的差异,以及对它们的需求,虽然有很多不同的想法,但我们最好能够解释它们。差异是人类新的认识,如果能得到解释,那么显然更好。一旦获得这些,就可以确认其在自动驾驶和医疗诊断中的可靠性。

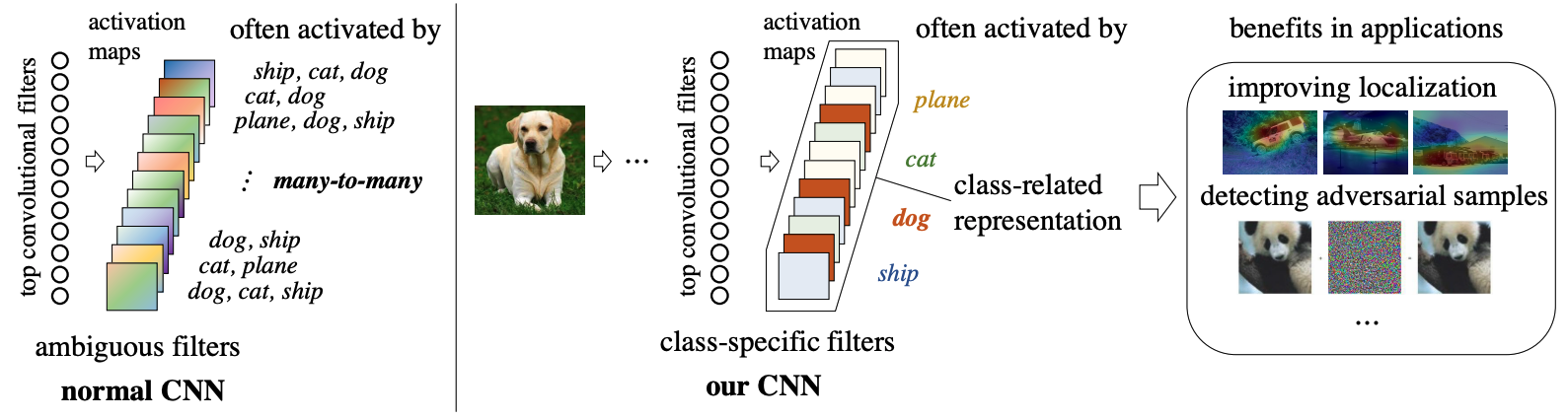

阻碍这种可解释性潜力的原因之一是过滤器类纠缠。纠缠这个词听起来并不熟悉,但如果你看下图,你可以把它和我在这里介绍的论文进行对比,你可以直观地看到它是如何改善解释的。

左边是传统的CNN。一个过滤器可见,与船、猫、狗等对应的各种事物,对于船、猫、狗来说,是很难解释的。如右图提议的,每一类都有一个过滤器,比如猫和狗,这样更容易解释。我这次要介绍的论文是关于提高可解释性的,每个类别使用一个过滤器。其实,这个想法可能是有道理的。在之前的工作中,他们发现不同过滤器之间存在冗余特征,在CVPR 2019中提出了专门过滤器学习的可能性。

要阅读更多。

你需要在AI-SCHOLAR注册。

或与本文相关的类别