トランスフォーマーはコンピュータビジョンのためにあるのか?

3つの要点

✔️ いくつかの画像やアーキテクチャの摂動を加えたViTモデルとその亜種の広範な研究

✔️ SOTA ResNet モデルとの比較

✔️ より良い学習技術の理解とビジョントランスフォーマーの応用

Understanding Robustness of Transformers for Image Classification

written by Yicheng Liu, Jinghuai Zhang, Liangji Fang, Qinhong Jiang, Bolei Zhou

(Submitted on 26 Mar 2021)

Comments: Accepted to arXiv.

Subjects: Computer Vision and Pattern Recognition (cs.CV); Artificial Intelligence (cs.AI); Machine Learning (cs.LG)

code:

はじめに

長い間畳み込みニューラルネットワーク(CNN)は、コンピュータビジョンの有力なモデルとして使われてきました。最近では、Vision Transformer(ViT)が、アテンションベースのモデルが、最先端のCNNと同等かそれ以上の性能を発揮できることでも話題になりました。ViTは純粋にトランスフォーマーをベースにしたネットワークであり、コンピュータビジョンで最も広く使われているディープニューラルネットワークのひとつであるResNetsの性能を上回っています。CNNが10年以上にわたって君臨してきた後、ビジョンの研究成果をトランスフォーマーに向けることは大きな飛躍です。

本論文では、いくつかの画像摂動を用いて、ViTのバリエーション性能を研究します。また、同様の学習条件でViTの性能をResNetsと比較します。このようにして、ビジョントランスフォーマーがどのように機能するかをより深く理解し、その応用と改善のための潜在的な道筋を決定するのに役立つことを目指しています。

ViT Transformerとバリエーション

ViTトランスフォーマーは、オリジナルのトランスフォーマーモデルと非常によく似ています。複数のブロックを使用しており、それぞれがmulti-self-attention層とフィードフォワード層で構成されています。唯一の違いは、最初の画像処理層にあります。画像はいくつかの重なり合わないパッチに分割され、それらは学習された線形層を使って平坦化され、変換されます。例えば、384×384の画像は、16×16のパッチに分割され、それぞれが24×24=576の寸法に平坦化されます。また、特別なCLSトークンが入力シーケンスに付加され、その表現が最終的な分類に使用されます。(詳しくはこちらの記事をご覧ください。)

入力摂動に対するロバスト性

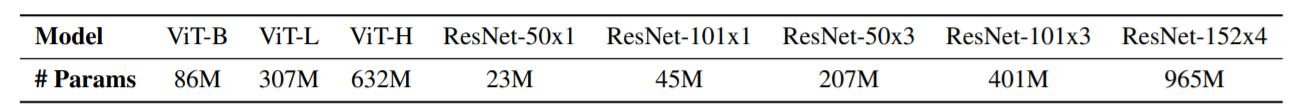

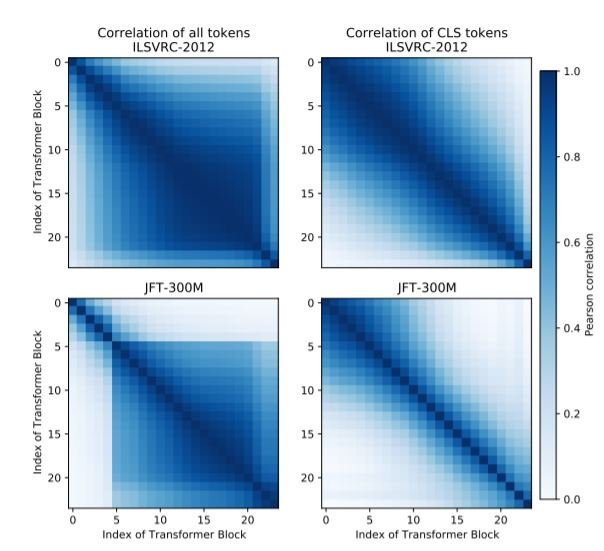

すべてのモデルはILSVRC-2012,ImageNet-21k,JFT-300Mのいずれかのデータセットで事前学習された後に、ILSVRC-2012でfine-tuningされています。そして、ImageNet-C、ImageNet-R、ImageNet-Aという3つの特殊なベンチマークを用いて、モデルのロバスト性をテストしました。

ImageNet-Cベンチマークは自然な画像の摂動に対するViTのロバスト性を評価するために使用されています。画像の乱れには、noise・blur・weather・digital corruptionsなど、合計15種類があります。それぞれの乱れには5段階の深刻度があり、5x15=75のカテゴリーがあります。ViTは、同サイズのResNetsと比較して、小さいデータセットではロバスト性が低いことがわかりました。しかし、データセットのサイズが大きくなると(IMageNet-21k、JFT-300M)、よりロバストになることが分かりました。この傾向は、3つのデータセット(C、R、A)すべてに当てはまります。もう一つの興味深い発見はViTの場合、データセットが小さい時にモデルサイズを大きくしても必ずしも性能が向上しないということです。

ImageNet-Rベンチマークは、ImageNetクラスのレンディション(アート、漫画、絵画、折り紙...)で構成されています。モデルの性能はImageNet-Cベンチマークよりも悪いが、モデルサイズと事前学習データセットサイズの傾向はよく似ています。ViTでは、モデルサイズとトレーニングインスタンスの大きさの利点が明確になっています。

ImageNet-Aモデルは、(ResNetsを使って作成された)MLモデルの性能を著しく低下させる、修正されていない実世界の自然発生する例題で構成されています。ViTはResNetsとは異なるアーキテクチャを持っていますが、同様の敵対的な画像では難航することがわかりました。

敵対的摂動

ほとんどのDNNは、入力画像に特別に細工された小さな摂動を与えると、大きな悪影響を受けます。高速勾配サイン法(FGSM)と投影勾配降下法(PGD)の2つの標準的な手法を用い、それぞれ8回の反復を行い、PGDのステップサイズは1/8階調としました。その結果、敵対的なパターンは、ResNetとViTの間で移行しないことが分かりました。つまり、ResNetで有効なパターンはViTでは機能せず、その逆も同様です。また、ResNetと同様に、パッチサイズが小さい(16x16)ViTモデルは、空間的な攻撃(平行移動や回転)に強いのに対し、パッチサイズが大きいViTモデルは、空間的な攻撃に弱いことが分かりました。

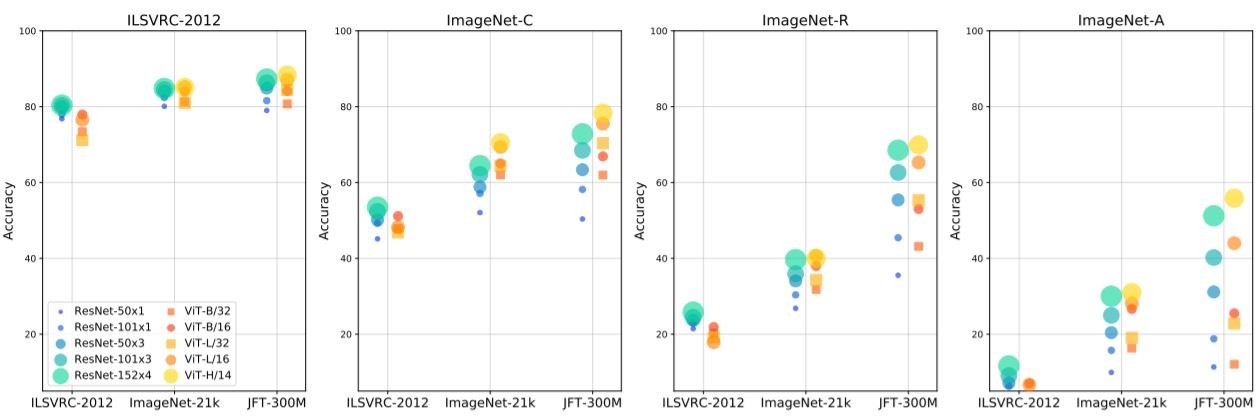

テクスチャバイアス

CNNは画像分類にテクスチャーを使うことが知られている(人間は形状を使う)。テクスチャの偏りを減らすことで、見知らぬ画像の歪みに強いモデルができることがわかっている。そこで、テクスチャーや形状が異なる画像を用意して、ViTのテクスチャーバイアスをテストした。その結果、すべての場合において、パッチの大きいViTモデルの方が優れた性能を発揮することがわかりました。

モデルの外乱に対するロバスト性

学習データの変化による影響を評価するだけでなく、ViTモデルの情報の流れを把握することも試みた。その結果を以下の3つのサブセクションで説明します。

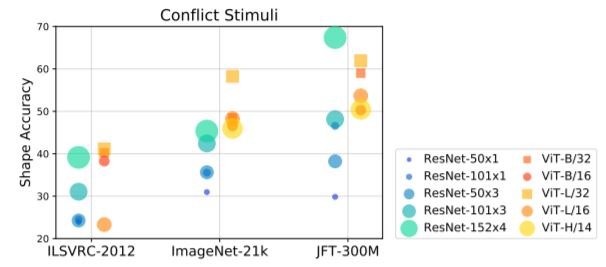

レイヤーの相関関係

左側の2つの図は,2つのデータセットについて,ViT-L/16変換器の異なるブロックの表現の相関を示している.後半の層の表現は、他の層との相関が高く、わずかな変化しかないことがわかります。ResNetsでは、ダウンサンプリング層が、モデルを異なる空間解像度を持つグループに分離することがわかります。右側の2つの図は、異なるブロックの後のCLSトークンの表現の相関を示しています。右側の2つの図は、異なるブロックの後のCLSトークンの表現の相関を示しています。この分析から、後半のレイヤーでは、全体としての表現の更新はほとんどなく、CLSトークンのための情報を集約することに集中していることがわかります。

Lesion研究

異なるブロックで作られた表現は高い相関性を持っているため、一部のブロックは冗長で不要なのではないかと考えられています。

そこで、ViTのさまざまな変換ブロックから、多頭の自己注意層、フィードフォワード層、またはその両方を取り除く実験を行いました。下の図を見ると、ブロックの数が増えれば増えるほど、変換器の精度は比例して低下することがわかります。大規模なデータセット(JFT-300M)で学習したモデルは、層の削除に対するロバスト性が低いことがわかった。また、MLPのフィードフォワード層を削除しても、自己注意層を削除した場合よりもモデルへの影響が少なく、自己注意の相対的な重要性が浮き彫りになりました。

Attentionの制限

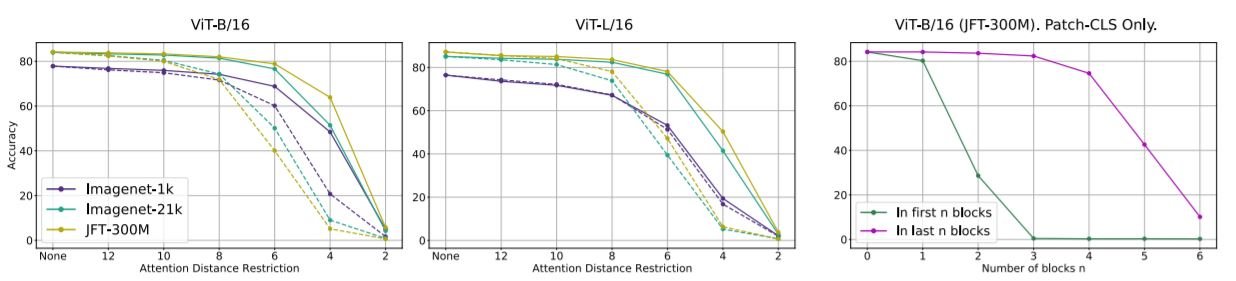

次に、ViTモデルが長距離の注意にどれだけ依存しているかを評価する。そのために、推論の際に、パッチ間の注意について空間距離に基づくマスクを用いてテストを行う。ViTは無制限の注意で訓練されたが、注意の距離を制限するとモデルの性能が低下することがわかった。

右端の図は、ブロック数を変化させたときに、CLSトークンでのみ注意が計算され、それ以外では注意が計算されない場合を示している。ネットワークの最後でパッチ間のアテンションを完全に除去しても、精度にはほとんど影響しませんが、最初のブロックを除去すると悪影響を及ぼします。これは、CLSトークンが初期セクションに比べて最終セクションで主に更新されているという以前の観察結果と一致しています。

これらの結果から、ViTモデルは非常に冗長であり、推論中に大幅に刈り込むことが可能であると結論付けられました。

まとめ

ViTはデータが豊富な場合に有利な選択であり、いくつかのケースでは、モデルサイズをスケールアップしたときにパフォーマンスが向上しています。また、ViTは任意の1つのレイヤーを削除してもロバストであり、冗長性が高いと思われる。この論文で紹介した一連の実験を通して、ビジョン・トランスフォーマーがCNNと同等かそれ以上の性能を発揮することが明らかになった。変換器が視覚のためのものであることは同意できるが、今後の研究では、本稿で取り上げたViTのいくつかの欠点を改善することができるだろう。

この記事に関するカテゴリー