变形金刚是用于计算机视觉的吗?

三个要点

✔️ 对ViT模型及其变体的广泛研究,其中有一些图像和结构的扰动

✔️与SOTA ResNet模型的比较

✔️更好地理解视觉变换器的学习技术和应用

Understanding Robustness of Transformers for Image Classification

written by Yicheng Liu, Jinghuai Zhang, Liangji Fang, Qinhong Jiang, Bolei Zhou

(Submitted on 26 Mar 2021)

Comments: Accepted to arXiv.

Subjects: Computer Vision and Pattern Recognition (cs.CV); Artificial Intelligence (cs.AI); Machine Learning (cs.LG)

code:

首先

很久以来卷积神经网络(CNN)一直是计算机视觉的主导模型。最近,Vision Transformer(ViT)因其能够使基于注意力的模型表现得与最先进的CNN一样或更好而成为头条新闻。 ViT是一个纯粹的基于变压器的网络,其性能超过了计算机视觉中最广泛使用的深度神经网络之一ResNets。在CNN统治了十多年之后,将视觉研究工作转向转化器是一个巨大的飞跃。

在本文中,我们研究了使用几种图像扰动的ViT的变化性能。我们还比较了ViT和ResNets在类似训练条件下的性能。通过这种方式,我们表明,视觉变频器旨在更深入地了解ViT的运作方式,并帮助确定其应用和改进的潜在途径。

ViT变压器和变化

ViT变压器与原来的变压器模型非常相似。它使用多个区块,每个区块由一个多自我注意层和一个前馈层组成。唯一的区别是在第一个图像处理层。图像被分割成几个不重叠的斑块,然后用一个学习过的线性层将其压扁并进行转换。例如,一个384x384的图像被分成16x16的斑块,每个斑块被压扁为24x24=576的尺寸。一个特殊的CLS标记也被添加到输入序列中,其表示法被用于最终分类。欲了解更多信息,请看这篇文章)。

对输入扰动的稳健性

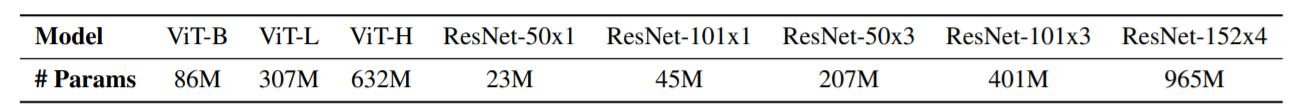

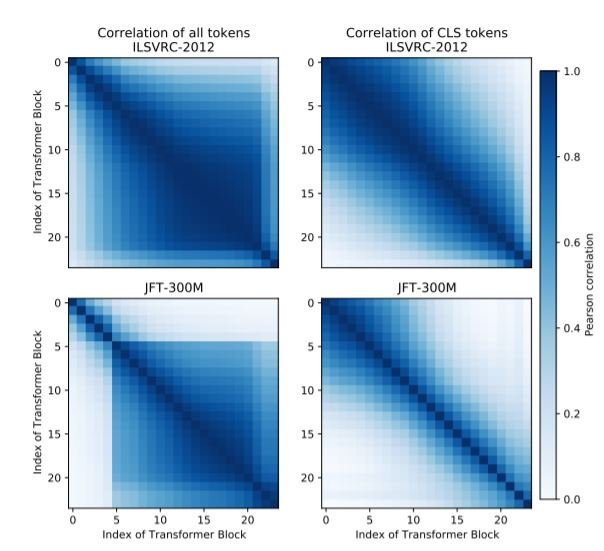

所有模型都在ILSVRC-2012、ImageNet-21k或JFT-300M数据集上进行预训练,并在ILSVRC-2012上进行微调。然后,我们用三个特殊的基准测试了该模型的鲁棒性,即ImageNet-C、ImageNet-R和ImageNet-A。

ImageNet-C基准被用来评估ViT对自然图像扰动的鲁棒性。共有15种类型的图像扰动,包括噪声、模糊、天气和数字损坏。与相同规模的ResNets相比,ViT在小数据集上的稳健性较差。然而,随着数据集规模的增加(IMageNet-21k,JFT-300M),我们发现它变得更加强大。这一趋势对所有三个数据集(C、R和A)都是如此。另一个有趣的发现是,对于ViT来说,当数据集很小的时候,增加模型的大小并不一定能提高性能。

ImageNet-R基准是对ImageNet类(艺术、卡通、绘画、折纸...)的演绎。它由以下部分组成模型性能比ImageNet-C基准差,但模型大小和预训练数据集大小的趋势非常相似:ViT显示了模型大小和训练实例大小的明显优势。

ImageNet-A模型由未经修改的、真实世界的、自然发生的例子组成,这些例子大大降低了ML模型(使用ResNets创建)的性能。viT的架构与ResNets不同,但我们发现它在类似的对抗性图像上也具有挑战性。我们发现,。

敌意扰乱

大多数DNN受到输入图像的小的、专门制作的扰动的极大不利影响。我们使用了两种标准方法,快速梯度正弦法(FGSM)和投影梯度下降法(PGD),每种方法有8次迭代,PGD的步长为1/8音。结果显示,对抗性模式在ResNet和ViT之间没有迁移。换句话说,在ResNet中有效的模式在ViT中不起作用,反之亦然。另外,与ResNet类似,我们发现小补丁尺寸(16x16)的ViT模型对空间攻击(翻译和旋转)的抵抗力更强,而大补丁尺寸的ViT模型更容易受到空间攻击。

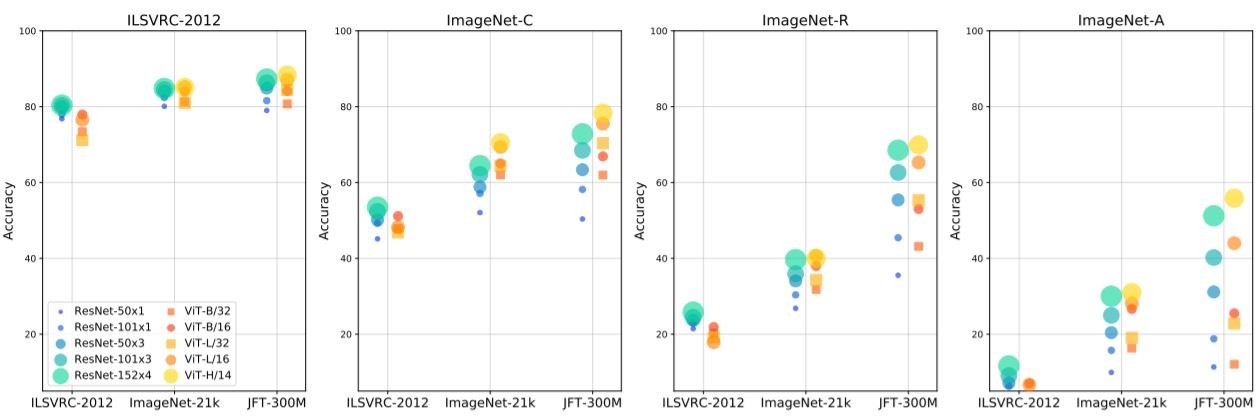

纹理偏差

众所周知,CNN使用纹理进行图像分类(人类使用形状)。减少纹理偏差已被证明能使模型对不熟悉的图像中的失真更加稳健。因此,我们通过准备不同质地和形状的图像来测试ViT的纹理偏差。结果显示,在所有情况下,具有较大斑块的ViT模型表现得更好。

模型对干扰的稳健性

除了评估训练数据变化的影响外,我们还试图了解ViT模型中的信息流。结果将在以下三个小节中描述。

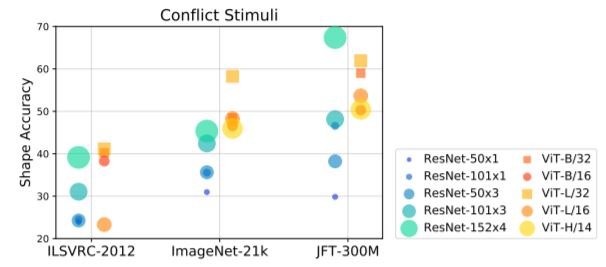

层的关联性

左边的两张图显示了两个数据集的ViT-L/16变压器的不同块的表示方法之间的相关性。我们可以看到,后面一层的表述与其他层高度相关,只是略有不同;在ResNets中,我们可以看到,下采样层将模型分成不同空间分辨率的组。右边的两张图显示了不同区块后CLS标记的表述之间的相关性。右边的两张图显示了不同区块后CLS标记的代表性的相关性。从这个分析中,我们可以看出,后面几层的重点是汇总CLS标记的信息,而对整个表示的更新很少。

病变研究

由于不同区块所做的表示是高度相关的,一些区块可能是多余的和不必要的。

因此,我们试验了从ViT的各种转换块中去除多头的自我注意层、前馈层或两者。在下图中,你可以看到,随着块数的增加,传感器的精度会按比例下降。在一个大型数据集(JFT-300M)上训练的模型被发现对层的去除不太稳健。删除MLP的前馈层比删除自我注意层对模型的影响要小,突出了自我注意的相对重要性。

对注意力的限制

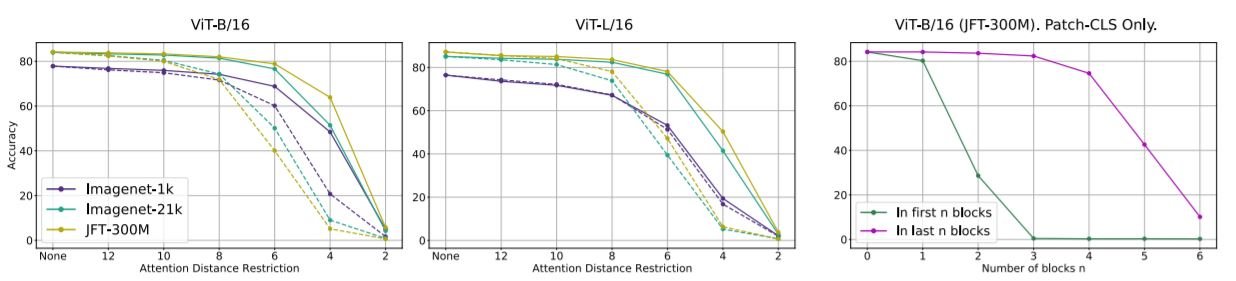

接下来,我们评估ViT模型对长距离注意力的依赖程度。为此,我们使用基于空间距离的掩码来测试推理过程中跨斑块的注意力;ViT是在不受限制的注意力下训练的,但我们发现限制注意力距离会降低模型的表现。

最右边的图显示了当块的数量变化时,只计算CLS标记而不计算其他标记的情况。完全去掉网络末端的斑块之间的注意力对准确性影响不大,但去掉第一个斑块则有负面作用。这与之前的观察是一致的,即CLS标记的更新主要是在最后一节,而不是初始一节。

从这些结果中,我们得出结论,ViT模型是高度冗余的,可以在推理过程中进行大幅修剪。

摘要

当数据丰富时,ViT是一个有利的选择,在某些情况下,在扩大模型规模时表现出更好的性能。此外,ViT对任何一层的移除都是稳健的,似乎是高度冗余的。通过本文介绍的一系列实验,很明显,视觉变换器的表现可以和CNN一样好,甚至更好。虽然我们同意变压器是为了视觉,但未来的工作可以改进本文讨论的ViT的一些缺点。

与本文相关的类别

![[MusicLM]谷歌开发的文本到音乐生](https://aisholar.s3.ap-northeast-1.amazonaws.com/media/October2023/musiclm-520x300.png)